ERNIE-ViLG 2.0 - ERNIE-ViLG 2.0

模型详细情况和参数

ERNIE-ViLG 2.0

- 模型全称

- ERNIE-ViLG 2.0

- 模型简称

- ERNIE-ViLG 2.0

- 模型类型

- 基础大模型

- 发布日期

- 2022-10-27

- 预训练文件大小

- 未知

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 240.0

- 模型HuggingFace链接

- https://huggingface.co/spaces/PaddlePaddle/ERNIE-ViLG

- 在线演示地址

- 暂无

- 基础模型

- 无基础模型

- 发布机构

ERNIE-ViLG 2.0 简介

ERNIE-ViLG 2.0是一个基于知识增强和混合去噪专家策略的文本到图像生成模型。该模型的设计理念是在学习过程中融入知识,并通过混合去噪专家策略来提高模型的生成能力。根据论文中的描述,该模型最多可以扩展到240亿参数规模。

模型简介

ERNIE-ViLG 2.0是一个基于知识增强和混合去噪专家策略的文本到图像生成模型。该模型的设计理念是在学习过程中融入知识,并通过混合去噪专家策略来提高模型的生成能力。该模型采用中文提示作为输入,生成高分辨率的图像,与最近的以英文为主的文本到图像模型不同。

模型特点

- 知识增强:模型在学习过程中融入知识,这有助于提高模型的生成能力。

- 混合去噪专家策略:该策略可以提高模型的生成能力,使生成的图像更加自然和逼真。

- 高分辨率图像生成:模型可以根据中文提示生成高分辨率的图像。

模型参数

论文中并未详细介绍模型的参数。

性能测试结果

根据论文中的实验结果,ERNIE-ViLG 2.0在ViLG-300上的人类评估结果显示,与DALL-E 2和Stable Diffusion等模型相比,人类评估者更喜欢ERNIE-ViLG 2.0。在图像-文本对齐和图像保真度两个维度上,ERNIE-ViLG 2.0都优于所有其他模型。此外,ERNIE-ViLG 2.0可以生成比基线模型更清晰、纹理更好的图像。

下图是与其它模型的对比结果:

可以看到,在MS-COCO 256 × 256数据集上做的文本生成图像实验中,ERNIE-ViLG2.0的效果最好。

在知识增强策略的部分,实验结果显示,将知识融入学习过程可以显著提高图像保真度、图像-文本对齐以及收敛速度。在混合去噪专家策略的部分,实验结果显示,增加专家的数量可以提高模型的生成能力,使生成的图像更加自然和逼真。

总的来说,ERNIE-ViLG 2.0模型在文本到图像生成任务上表现出色,无论是在图像质量、图像-文本对齐,还是在收敛速度上,都优于其他模型。

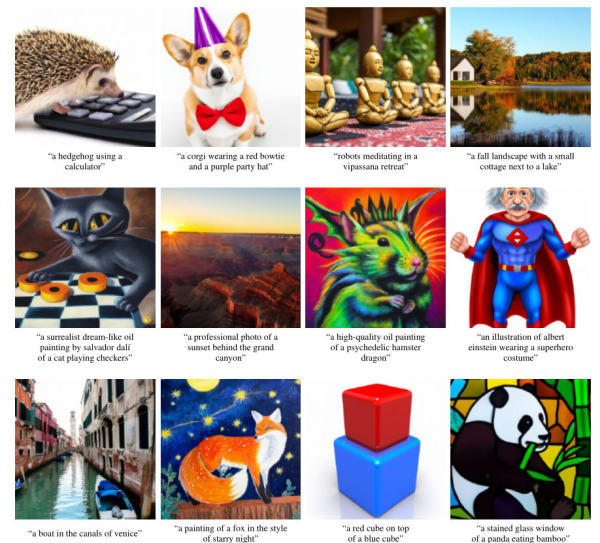

ERNIE-ViLG 2.0实际生成的图片效果

下图是官方发布的1024*1024的效果图,效果很好。

目前ERNIE-ViLG 2.0已经被文心系列的CV模型取代。不过HuggingFace上的demo依然可用。

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

ERNIE-ViLG 2.0所属的领域

ERNIE-ViLG 2.0相关的任务