BloombergGPT - BloombergGPT

模型详细情况和参数

BloombergGPT

- 模型全称

- BloombergGPT

- 模型简称

- BloombergGPT

- 模型类型

- 基础大模型

- 发布日期

- 2023-03-30

- 预训练文件大小

- 未知

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 500.0

- 模型GitHub链接

- 暂无

- 模型HuggingFace链接

- 暂无

- 在线演示地址

- 暂无

- 基础模型

-

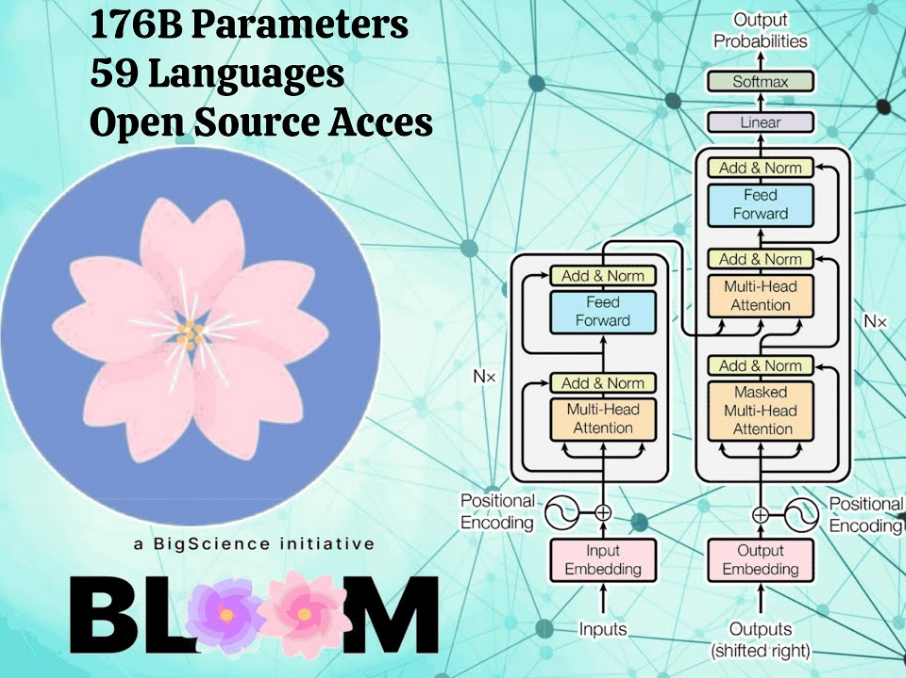

BLOOM

查看详情 - 发布机构

BloombergGPT 简介

BloombergGPT是BloombergGPT发布的一个金融领域的大模型,参数500亿。主要使用通用数据以及彭博社40多年积累的金融领域数据进行训练。

与最近发布的模型不同,BloombergGPT是Bloomberg基于基于Hoffmann等人(2022年)和Le Scao等人(2022年)的指南进行设计。目前很少存在领域特定的LLM,这些模型仅在领域特定的数据源上进行训练,或者将一个非常大的通用模型适应于领域特定任务。而Bloomberg则是选择在领域特定和通用数据源上训练LLM。

BloombergGPT模型参数约500亿,训练tokens数约5700亿!具体的,他们训练的数据如下:

需要注意的是,BloombergGPT里面使用的金融数据占比约54.2%,约有3630亿个tokens。

Bloomberg终端在过去40年中提供了全面的结构化和非结构化金融数据和分析。为了实现这一目标,Bloomberg分析师策划了一组金融文档,这些文档要么是内部创建的,要么是从外部来源获得的。我们利用这一广泛的、精心策划和维护的文档集合创建了FinPile,其中包括公司申报文件、金融新闻和其他与金融市场相关的数据。

FinPile中包含的一些文档(例如公司申报文件)对公众开放,尽管收集这些文档并为LLM训练进行预处理是一个非平凡的任务。其他文档,如(Bloomberg新闻的子集),必须购买。其余文档是私有的,并且可以通过Bloomberg终端等其他来源获得。最后,我们对这些数据进行清理,以去除标记、特殊格式和模板。

需要注意的是,FinPile中的每个文档都有时间戳,日期范围从2007-03-01到2022-07-31;文档的质量和数量随时间增加而增加。虽然我们在这项工作中没有使用日期信息,但我们计划在未来使用它,例如用于评估模型对不同时间段的学习情况。虽然我们无法发布FinPile,但我们在大规模、精心策划和干净的领域特定数据集上进行训练的经验可能为社区提供有用的见解,这些见解涉及特别是构建金融LLM的优点和挑战,以及领域特定模型的优点和挑战。我们在表2中提供了FinPile的分类和分析,并对包括的数据类型进行了简要描述。

具体的金融数据包括:

BloombergGPT模型的具体参数如下:

| 参数项 | 参数结果 |

|---|---|

| 模型层数 | 70 |

| Heads数量 | 40 |

| 词汇数量 | 131072 |

| 隐维度 | 7680 |

| 模型参数总量 | 506亿 |

| 最高学习速率 | 6e*5 |

| 最终学习速率 | 6e-6 |

| 学习速率调度 | cosine decay |

| 梯度Clipping | 0.3 |

| 训练使用的tokens数量 | 5690亿 |

| 硬件资源 | 64 × 8 A100 40GB |

| 处理速度(Throughput) | 32.5 sec/step |

| 平均TFLOPs | 102 |

| 总FLOPS | 2.36e23 |

作者也在BIG-BENCH做了测试,结果显示BloombergGPT效果十分优秀。与GPT-NeoX、OPT、PaLM等相比也是非常出色。

下图是BloombergGPT问答对比结果实例:

下图是在财经领域和通用领域中BloombergGPT的效果对比:

不过可惜的是,BloombergGPT并不是开源的模型。

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送