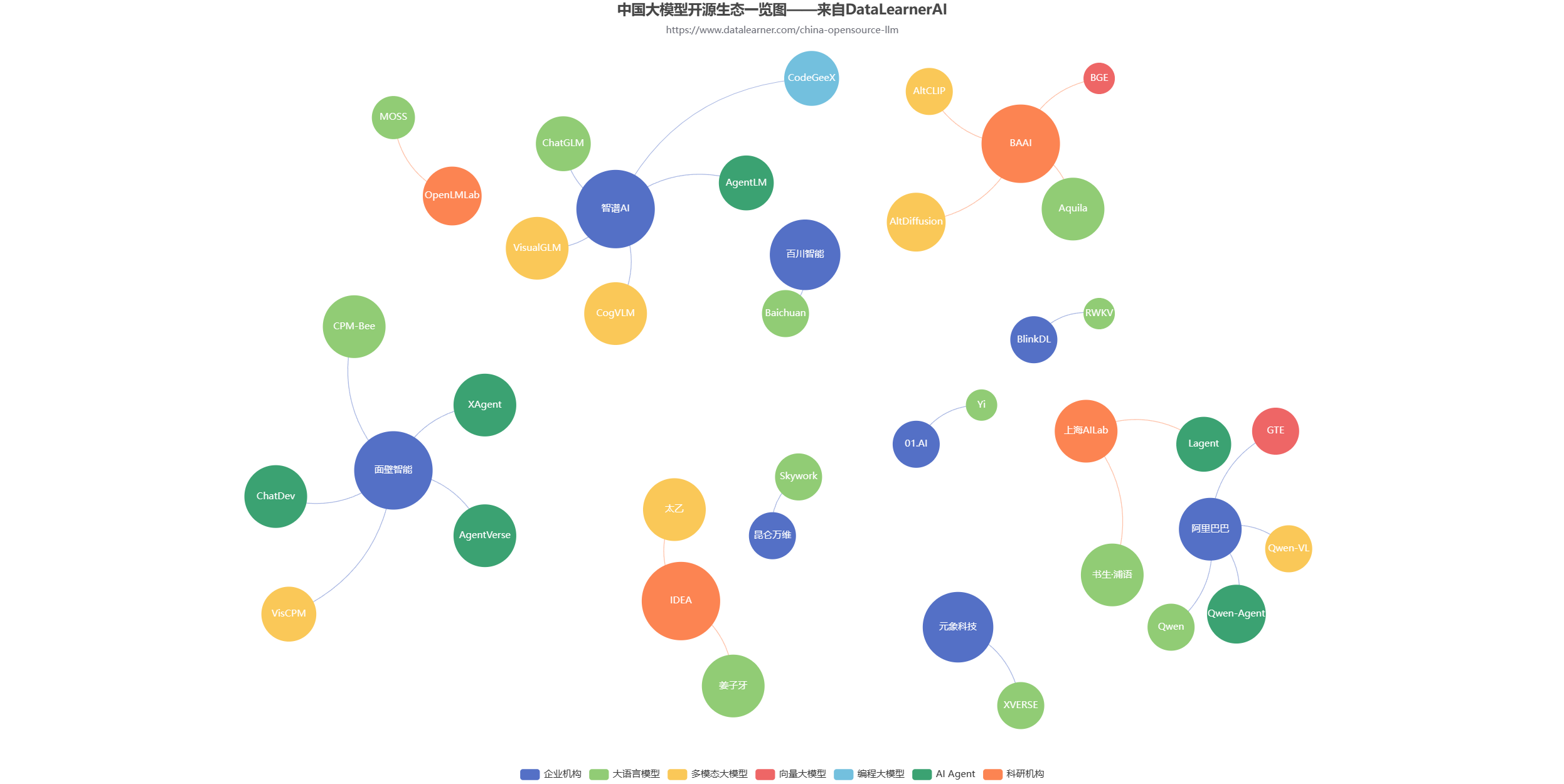

随着人工智能技术的迅速进展,大模型已成为推动科技前沿的关键驱动力。在这一领域,中国众多企业和科研组织正快速行动,开发并推出各式各样的大模型。鉴于开源大模型的数量日益增多,及时追踪与深入理解国内开源大模型的生态及其发展变化成为了一个重要课题。基于这一需求,我们创建了这个网页,旨在整理和提供一个清晰的信息集合点,帮助用户轻松跟进中国开源大模型的最新动态,掌握生态演变,并深化对该领域发展的认识。

Note:上图是Echarts的交互版本,建议PC端浏览,下方是截图结果。

下方收集了当前主流开源大模型背后的企业和机构,可以点击进入查看各个机构介绍及其开源的大模型列表。如有问题和任何疑问欢迎交流。交流方式可以加入微信社区。

中国国产开源大模型背后的企业和科研机构列表

中国国产大模型综合能力评测统计和编程水平评测结果统计

此外,为了更加清晰地对比不同的国产开源大模型的水平能力,DataLearnerAI还收集了国产开源大模型公布的在公开评测结果中的对比。 虽然各大模型有自己的统计结果,但是不同模型公布的评测内容不同,即便是业界认可度比较高的MMLUL、GSM8K等评测,也不是所有模型都会公布。有时候,因为各种原因,各家模型公布的对比也并不完全。 另外,虽然HuggingFace的Open LLM Leaderboard也有类似的结果,但是包含的主要是HF上提交的模型结果,不会主动收集国产模型自己公布的数据。为此,我们建立了这样的对比页面。 这两个评测收集统计的主要目的就是方便大家在一个地方对比不同模型在不同评测中的结果,方便大家对比。

评测统计地址参考如下:

- 国产开源大模型综合评测对比: https://www.datalearner.com/ai-models/llm-evaluation

- 国产开源大模型编程能力评测对比: https://www.datalearner.com/ai-models/llm-coding-evaluation