DataLearnerAI发布中国国产开源大模型生态概览统计:国产开源大模型都有哪些?现状如何?

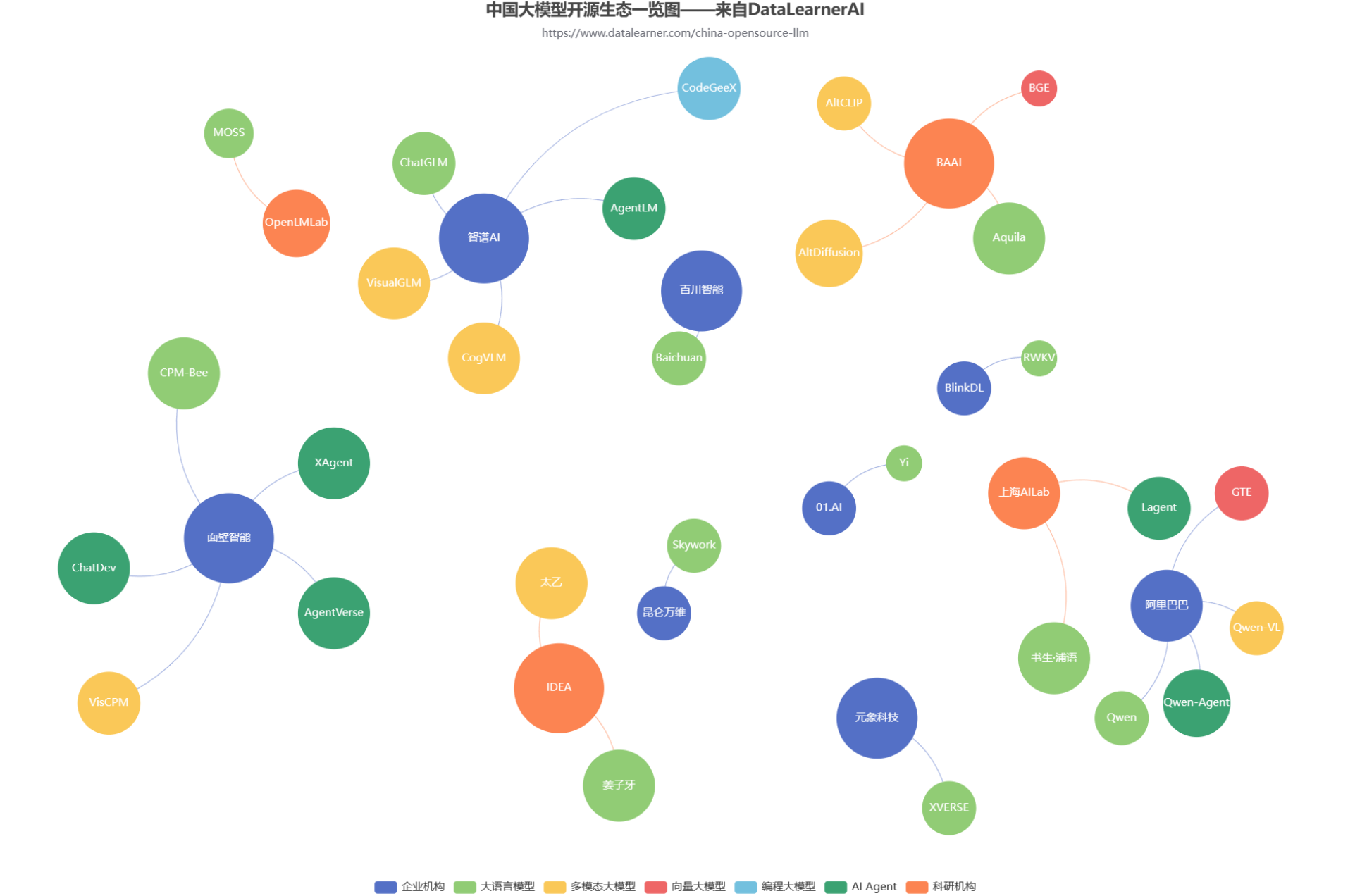

随着GPT的一路爆火,国内大模型的开源生态也开始火热。各大商业机构和科研组织都在不断发布自己的大模型产品和成果。但是,众多的大模型产品眼花缭乱。为了方便大家追踪国产开源大模型的发展情况,DataLearnerAI发布了中国国产大模型生态系统全景统计(地址:https://www.datalearner.com/china-opensource-llm ),本文也将根据这个统计结果简单分析当前国产开源大模型的生态发展情况。

中国国产大模型生态总体说明

首先说明一下数据来源于DataLearnerAI统计结果,主要包括机构自己训练开源的模型,并不包含所有种类和一些已经不更新的模型。当前属于测试阶段,已经收集的数据如果有任何问题欢迎告知交流。数据在不断完善中,将持续更新。

如上图所示,是当前国产主流的开源大模型总结的图。在国产的开源大模型的发布者中,主要包括两类发布者,一个是企业机构,为了获得商业影响力而开源的模型。如智谱AI开源的ChatGLM系列。一类是以科研机构为主,主要展示最新的科研成果,如北京智源人工智能研究院发布的Aquila系列大模型。

而国产大模型本身的发布者众多,还有许多公司仅仅发布商业产品,包括华为盘古大模型、百度文心一言等。由于商业产品缺少模型细节,并不是我们关注的重点,因此不在分析之列。

国产大模型总体开源情况

国产开源大模型的数量很多,类型也很丰富。包括大语言模型、多模态大模型、向量大模型、编程大模型和AI Agent框架(模型)几类。

根据上图显示结果我们可以看到。所有机构都有发布大语言模型。但是,不同机构的模型丰富程度不同。

按照统计,智谱AI、阿里巴巴的开源大模型都较为丰富,都开源了四种大模型。例如智谱AI开源的大模型包括:

- 大语言模型ChatGLM系列

- 多模态大模型CogVLM

- Agent大模型AgentLM

- 编程大模型CodeGeeX

而阿里巴巴的四类模型则是大语言模型、多模态大模型、向量大模型和Agent框架(模型)。

其它大多数企业或者机构开源的模型都是1-3类左右。

这其中,智谱AI是目前唯一开源了编程大模型的机构。而向量大模型则只有北京智源和阿里巴巴两家有开源。

另外值得一提的是,面壁智能开源了比较多的Agent类的模型和框架。

国产开源大模型的参数分布

这部分目前可能不太完全,但是大体的分布应该是差不多的。我们将模型开源的参数规模分为五类:

- 7B规模参数模型,表明该模型参数规模在70亿以下

- 13B规模参数模型,表明该模型参数规模在70亿到100亿之间

- 34B规模参数模型,表明该模型参数规模在100亿到400亿之间

- 65B规模参数模型,表明该模型参数规模在400亿到1000亿之间

- 100B规模参数模型,表明该模型参数规模在1000亿以上

ChatGLM系列应该是最早开源的模型系列,参数规模是60-70亿左右,而此后大多数模型的开源水平都在这个区间。国外最著名的开源大模型LLaMA1的最大参数规模是650亿,LLaMA2是700亿。这中间的差距持续了一段实践。而随着时间的发展,目前国产开源大模型的参数规模已经提高到了650亿规模,是元象科技发布的XVERSE-65B。而340亿参数规模的模型分别有2个:北京智源的Aquila-34b、李开复零一万物开源的Yi-34b(包括200K的版本)。

而阿里巴巴也即将开源700亿参数规模的大模型,到时候也会更新。这意味着国产开源大模型的参数规模已经持平国外最强大的模型。

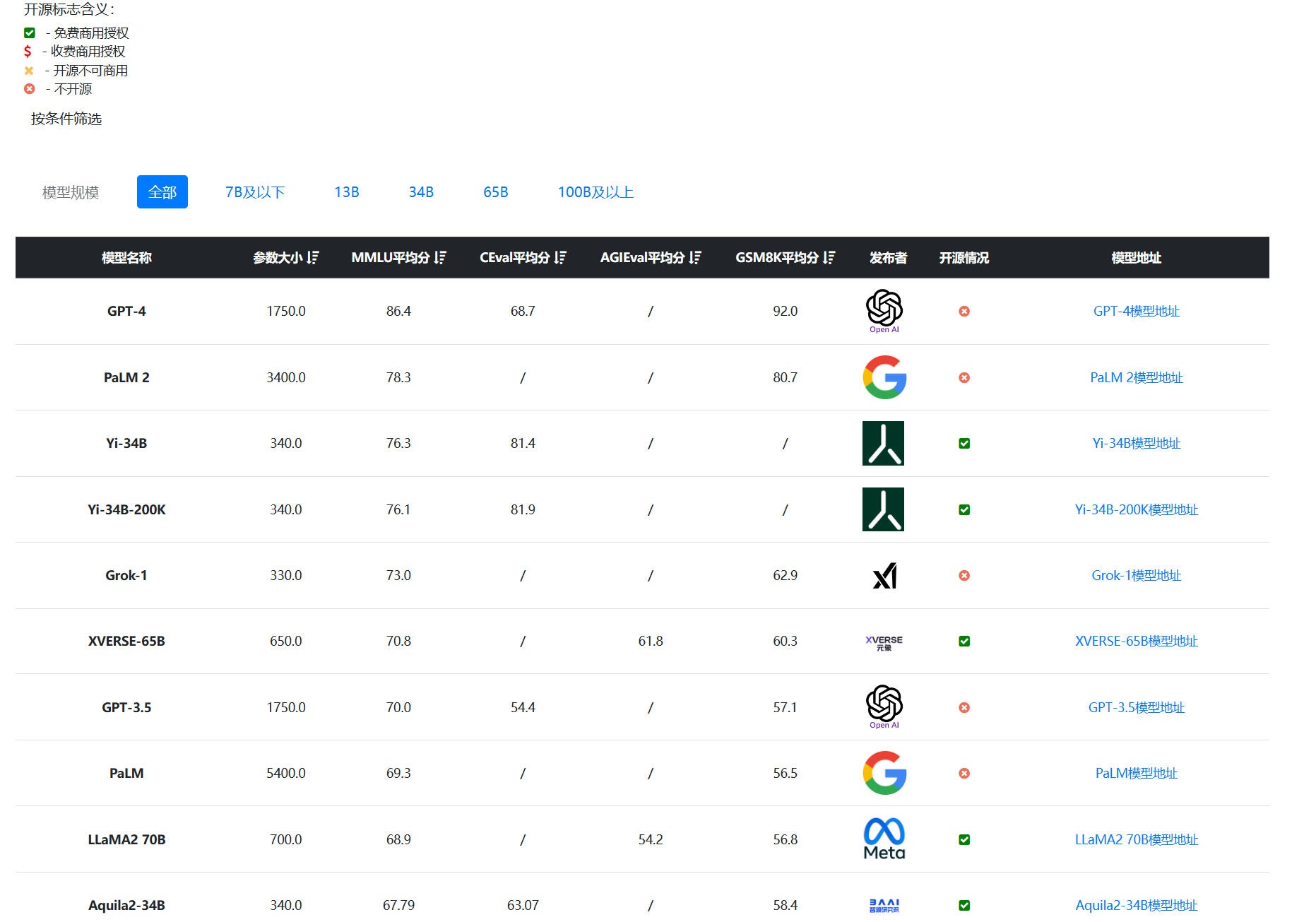

国产开源大模型的评测结果

为了更加方便大家对比追踪国产开源大模型。DataLearnerAI还提供了国产大模型综合能力评测统计和编程水平评测结果统计。

在综合能力评测上,以MMLU(大模型的理解能力)为例,国产开源模型的能力已经非常强悍了。按照DataLearnerAI的统计,李开复零一万物开源的Yi-34B模型的MMLU得分已经超过GPT-3.5,得分76.3,仅次于闭源的GPT-4和PaLM2模型(参考:李开复创业公司零一万物开源迄今为止最长上下文大模型:Yi-6B和Yi-34B,支持200K超长上下文)。

按照GSM8K(数学逻辑能力)的评分排行看,更是夸张。智谱AI的ChatGLM3-6B-Base模型以60多亿参数规模的结果超过了GPT-3.5、Qwen-14B等知名模型,排名仅次于GPT-4和PaLM2。

至于编程水平,大家表现都很一般。按照HumanEval Pass@ 1的得分结果看,除了闭源的PanGu-Coder2的得分超过了60分,其它模型都没怎么公布或者排名靠后。

关于这两个评测统计,大家可以自己查看详细内容:

大模型综合能力评测对比表:https://www.datalearner.com/ai-models/llm-evaluation 大模型编程能力评测对比表:https://www.datalearner.com/ai-models/llm-coding-evaluation

国产大模型开源情况总结

当前的分析仅基于目前已经收集的数据。大体上也可以看到,就模型的发布数量、参数规模、模型种类来说,国产开源模型的生态已经比较不错。但是,也有一些比较突出或者值得期待的问题和方向:

- 超过200亿参数规模的大模型发布较少,但已经有不少规划中

- 模型种类的多样性还是有欠缺,例如编程大模型、向量大模型目前都很少发布开源

- 编程水平、数学推理等更加高级的能力不足(除了小部分模型)

- 部分模型的文档信息比较差,很多重要信息未纰漏

最后,大家可以去原文地址追踪分析,我们还提供了按照机构查看开源的模型、具体模型的开源地址、参数情况、开源协议等信息。未来,DataLearnerAI将继续完善。另外,有任何问题和数据错误也欢迎来社区指正交流(可以vx:datalearner_ai进入技术交流群)

DataLearnerAI国产大模型开源生态追踪地址:https://www.datalearner.com/china-opensource-llm

未来规划

关于这部分的功能,未来我们将持续更新,短期目标如下:

- 丰富完善各家机构的模型数据

- 针对超长上下文、Agent能力进一步提供细分

- 收集更多评测数据