李开复创业公司零一万物开源迄今为止最长上下文大模型:Yi-6B和Yi-34B,支持200K超长上下文

1,460 阅读

零一万物(01.AI)是由李开复在2023年3月份创办的一家大模型创业企业,并在2023年6月份正式开始运营。在2023年11月6日,零一万物开源了4个大语言模型,包括Yi-6B、Yi-6B-200K、Yi-34B、Yi-34B-200k。模型在MMLU的评分上登顶,最高支持200K超长上下文输入,获得了社区的广泛关注。

加载中...

零一万物(01.AI)是由李开复在2023年3月份创办的一家大模型创业企业,并在2023年6月份正式开始运营。在2023年11月6日,零一万物开源了4个大语言模型,包括Yi-6B、Yi-6B-200K、Yi-34B、Yi-34B-200k。模型在MMLU的评分上登顶,最高支持200K超长上下文输入,获得了社区的广泛关注。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

这是李开复亲自担任CEO的一家企业,可以说相当地重视。本次发布的模型包括4个:

注意,这里的4K/32K表示模型本身在4K的序列上进行训练,但是在推理阶段可以扩展到32K。

这四个模型最大的特点是最高支持200K的上下文长度,是目前全球支持的最长的上下文大模型。

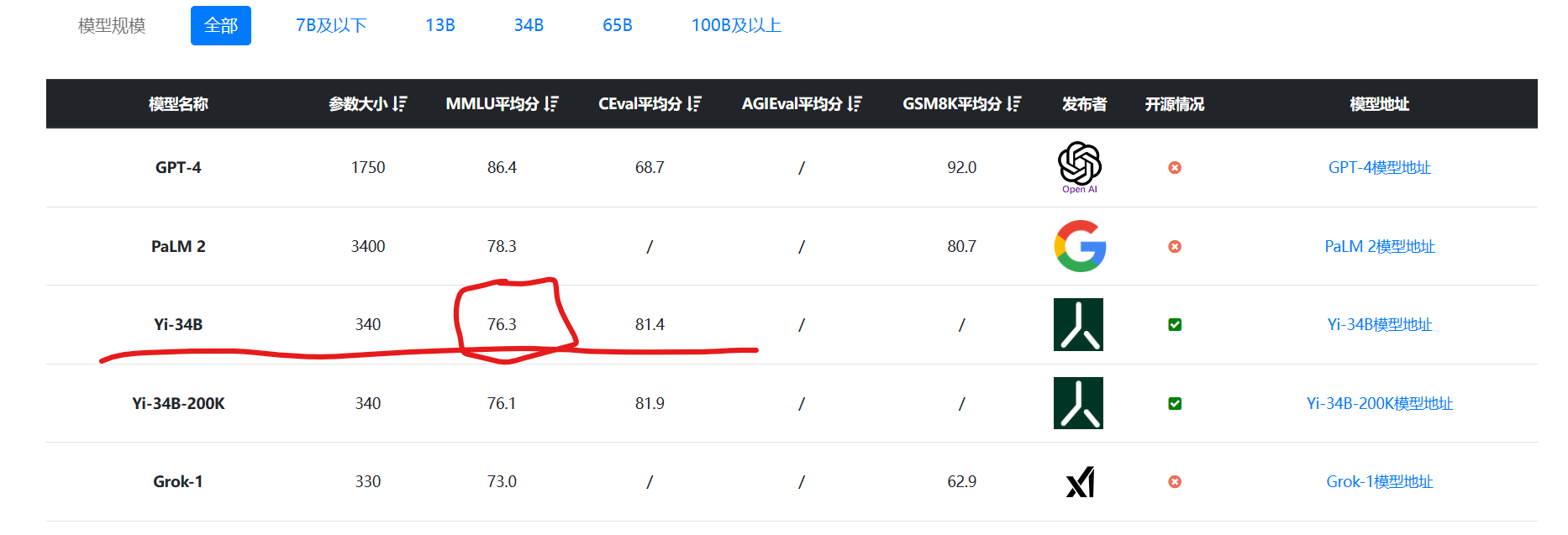

此外,这四个模型的表现也十分好,在MMLU的语言理解评测上得分76.3,是目前为止全球最高的开源大模型(预训练结果测试结果,不包含特殊微调的模型):

由于该模型也在HuggingFace的OpenLLM Leaderboard上提交了数据,也引起了国外很多人的关注。

关于Yi-6B和Yi-34B的模型训练细节,官方没有透露,只说明了这两个模型在多语言语料上训练,语料的数据达到3万亿tokens。官方说明这些模型是双语模型,支持中文和英文。

6B的模型可以在消费级显卡上运行。而34B的模型是可以出现涌现能力的最低参数规模,这可能也是发布这两个模型的初衷。

模型本身的GitHub代码采用Apache2.0开源方式,但是模型的预训练结果则是自有开源协议,个人和科研完全免费使用,商用需要获得授权申请,但是申请免费。

模型的其它信息参考DataLearner信息卡: