国产全球最长上下文大语言模型开源:XVERSE-13B-256K,一次支持25万字输入,免费商用授权~

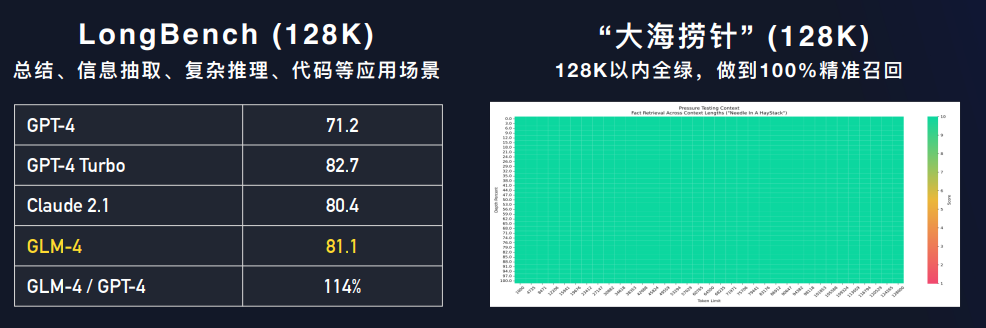

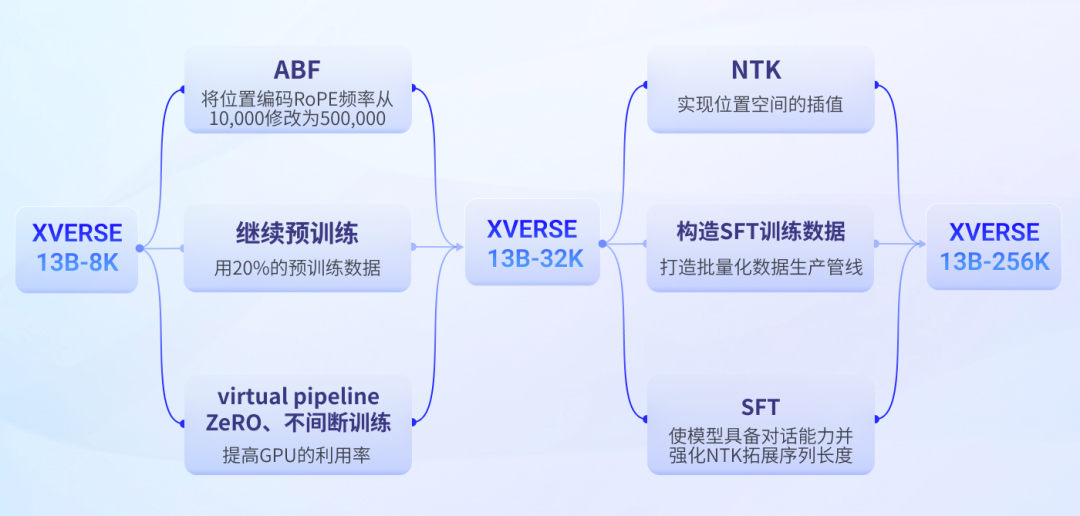

大语言模型支持更长的上下文意味着模型可以一次处理更多的数据,可以一次性考虑更广泛、更深入的信息范围,这不仅提高了对话的连贯性和准确性,还使模型更好地理解复杂的话题和细微的语境变化。在财报分析、长篇文章写作等方面都有很高的价值。此前,商业大模型中上下文长度最高的是李开复零一万物的Yi-34B-200K上下文大模型以及Anthropic的Claude-2-200K模型,而深圳的元象科技开源了一个最高上下文256K的大语言模型XVERSE-13B-256K,可以一次性处理25万字左右,是目前上下文长度最高的大模型,而且这个模型是以Apache2.0协议开源,完全免费商用授权。

XVERSE-13B-256K的具体参数和开源地址参考DataLearnerAI模型信息卡:https://www.datalearner.com/ai-models/pretrained-models/XVERSE-13B-256K

XVERSE-13B-256K介绍

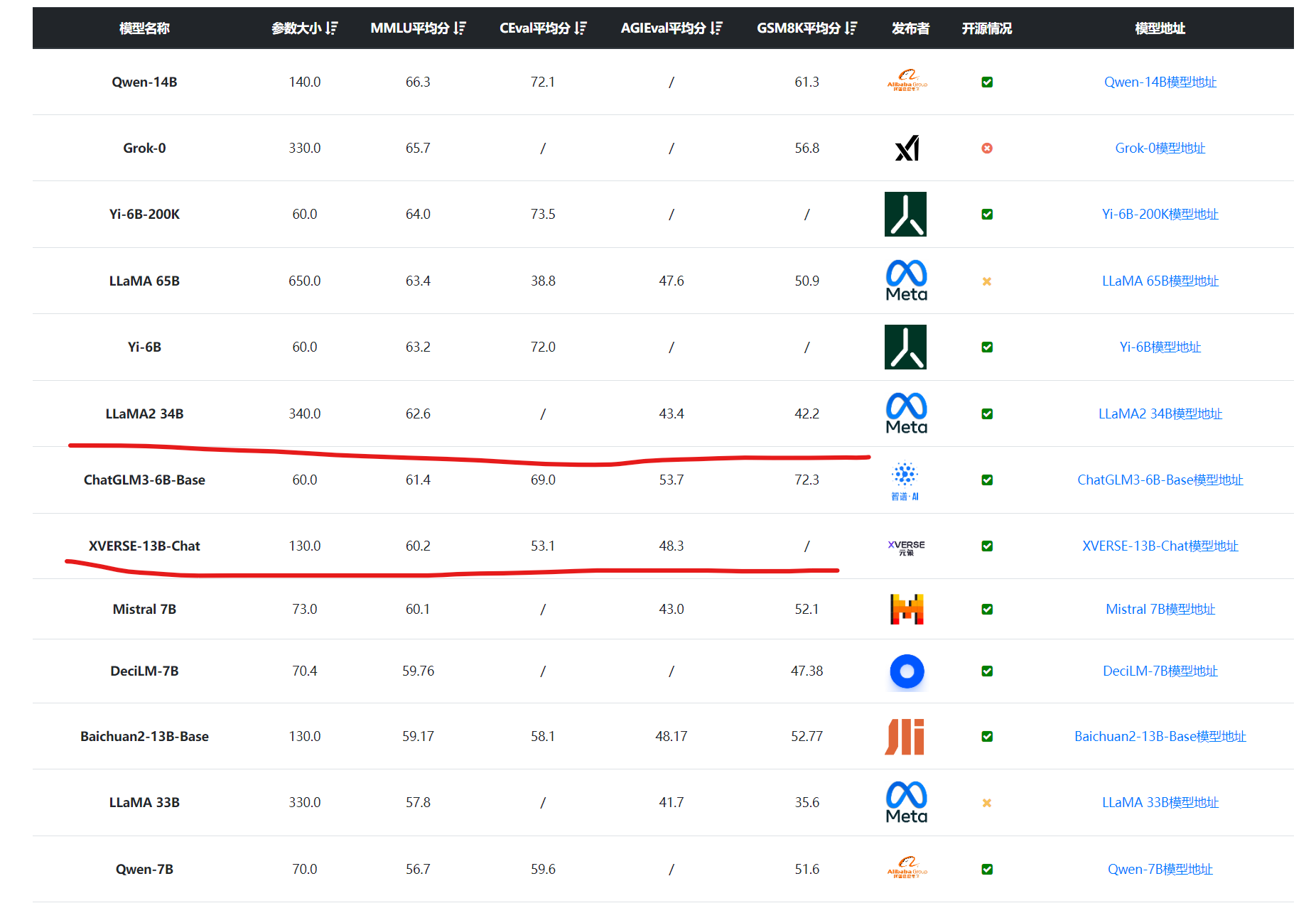

XVERSE-13B-256K是基于XVERSE-13B-2继续训练得到的,后者是XVERSE开源一个130亿参数规模的大语言模型,该模型在3.2万亿tokens数据集上训练得到,各项评测指标结果与340亿参数的LLaMA2-34B水平差不多。