GPT-4-Turbo的128K长度上下文性能如何?超过73K Tokens的数据支持依然不太好!

GPT-4 Turbo是OpenAI最新发布的号称性能超过当前GPT-4的模型。在新版本的ChatGPT中已经可以使用。而接口也在开放。除了速度和质量外,GPT-4 Turbo最吸引人的是支持128K超长上下文输入。但是,实际测试中GPT-4 Turbo对于超过73K tokens文档的理解能力急速下降。

加载中...

GPT-4 Turbo是OpenAI最新发布的号称性能超过当前GPT-4的模型。在新版本的ChatGPT中已经可以使用。而接口也在开放。除了速度和质量外,GPT-4 Turbo最吸引人的是支持128K超长上下文输入。但是,实际测试中GPT-4 Turbo对于超过73K tokens文档的理解能力急速下降。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

GPT-4 Turbo是OpenAI最新的开放模型,相比较此前的版本,GPT-4的知识已经更新到了2023年4月份,并且支持最高128K的超长上下文输入,约300页文本。不过,模型最大允许输出的长度是4096。

虽然GPT-4 Turbo宣称支持128K,但是有人实测结果并不理想。

前Salesforce工作人员做了这项测试,作者使用Paul Graham的论文作为上下文输入。Paul Graham是英国的计算机科学家,也是著名投资企业Y Combinator的创办者,它的论文超过了128K。

为了测试GPT-4 Turbo在超长上下文中准确定位信息的能力,作者随机在论文不同位置插入一句话“The best thing to do in San Francisco is eat a sandwich and sit in Dolores Park on a sunny day.”。然后让GPT-4只能用这个论文作为回答的依据。

作者测试了很多次,这句话在文档的开头到结束不同位置,上下文长度从1K到128K不等。

作者做了15次实验,比较GPT-4 Turbo是否能准确回答结果。

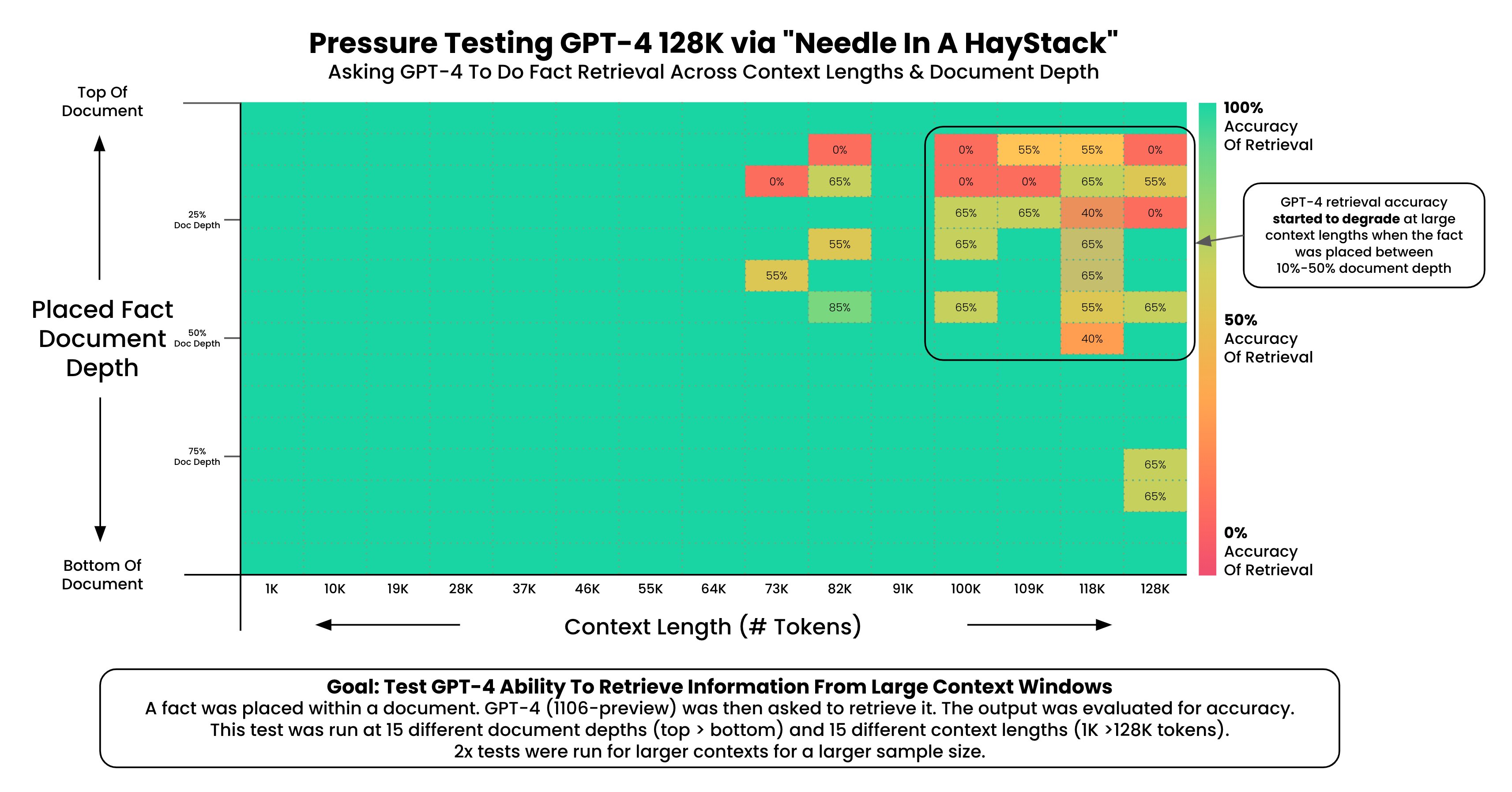

作者做了一张图描述这个结果:

图的横坐标是文档的长度,纵坐标是插入的文本在文档的位置。可以看到,在右上角区域模型表现效果很差,这些基本都是文档上半段,然后开始位置之后(7%位置之后)。但是如果这句话在文档下半段效果反而还可以。

最终的实验结论如下:

GPT-4的召回率在输入文档超过73K tokens之后下降明显,这意味着,如果你的文档超过了50万单词之后可能GPT-4并不能准确找到你问题的答案位置;

如果你的答案恰巧在文档7%-50%的位置,那么GPT-4能找到的概率最低,而50%的位置正好是文档中间。这也侧面验证了此前大模型的Lost in Middles特点(具体参考:大模型如何使用长上下文信息?斯坦福大学最新论文证明,你需要将重要的信息放在输入的开始或者结尾处!)

如果需要回忆的事实位于文档的开头,无论上下文长度如何,都能被回忆起。这可能意味着模型对文档开头的信息有更好的记忆能力。

根据这些发现,其实大家也可以理解。如果你想要准确的让模型理解你的问题,那么你的上下文必须短一点。也就是说,短一点的上下文可以提升GPT-4 Turbo的定位问题的能力。当然,如果文档很长,但是重要的信息在文档开始位置,或者是下半段,那么效果也都不错~

这项测试成本200美元,真不便宜~实验原文:https://x.com/GregKamradt/status/1722386725635580292?s=20