加载中...

加载中...

汇集AI与机器学习领域常用数据集,提供下载链接与使用指南

<p>ImageNet项目是一个大型视觉数据库,旨在用于视觉对象识别软件的研究。该项目对1400多万张图片进行了手工注释,以表明图片中的物体是什么,在至少100万张图片中,还提供了边界框。ImageNet包含2万多个类别,一个典型的类别,如 "气球 "或 "草莓",由几百张图片组成。第三方图片URL的注释数据库可以直接从ImageNet免费获得,尽管实际的图片不属于ImageNet。自2010年以来,ImageNet项目每年都会举办一次软件竞赛,即ImageNet大规模视觉识别挑战赛(ILSVRC),软件程序在竞赛中对物体和场景进行正确分类和检测。该挑战赛使用了一个由1000个不重叠的类组成的 "修剪 "列表。</p><p>该数据集直接促进了计算机视觉模型的对比基准,在图像分类和语义分割方面都有大量的模型进行了相关的测试。</p><p style="text-align: right;">——来自维基百科</p><p style="text-align: right;"><br></p><p style="text-align: left;">官方网址: <a href="https://www.image-net.org/" target="_blank">https://www.image-net.org/</a> </p><p style="text-align: left;">数据集地址: <a href="https://www.kaggle.com/competitions/imagenet-object-localization-challenge/overview" target="_blank">https://www.kaggle.com/competitions/imagenet-object-localization-challenge/overview</a> </p><p style="text-align: left;">PapersWithCode地址: <a href="https://paperswithcode.com/dataset/imagenet" target="_blank">https://paperswithcode.com/dataset/imagenet</a> </p>

发布者:Fei-Fei Li

<p>Habitat-Matterport三维语义数据集(HM3D-Semantics v0.1)是有史以来最大的三维室内空间语义标注数据集。HM3D-Semantics v0.1包含对Habitat-Matterport 3D数据集中120个高分辨率3D场景的密集语义注释。HM3D场景有1700多个原始物体名称的注释,它们被映射到40个Matterport类别。平均而言,HM3D-Semantics v0.1中的每个场景由114个类别的646个物体组成。这个数据集是由大约30位注释者花费了12000多个小时的人力进行注释和验证的结果。</p><p><br></p><p>HM3D-Semantics v0.1是免费的,可用于学术、非商业研究。研究人员可以将其与FAIR的人居环境模拟器一起使用,以大规模地训练有形的代理,如家用机器人和人工智能助手,以完成语义导航任务。</p>

发布者:Meta

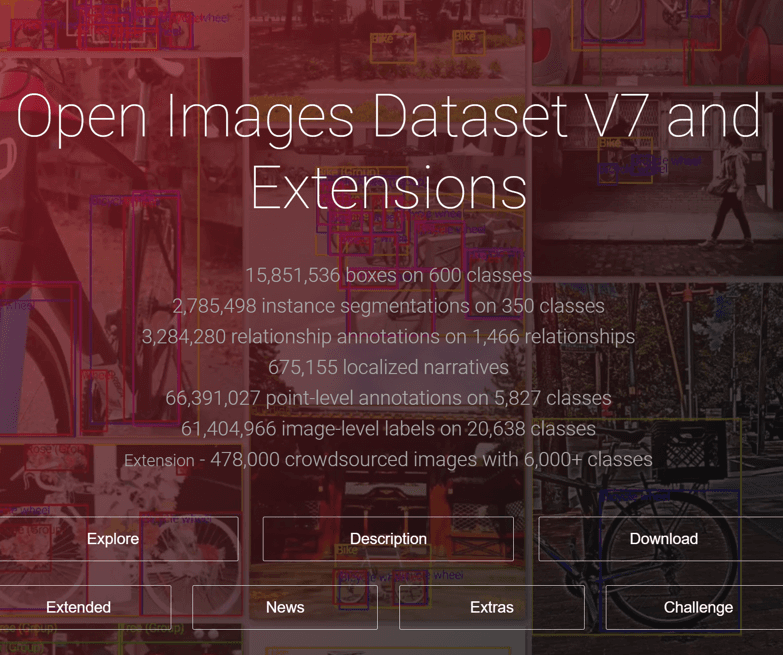

<p>Open Images是由谷歌发布的一个开源图片数据集,在2022年10月份发布了最新的V7版本。这个版本的数据集包含了900多万张图片,都有类别标记。其中190多万张图片有非常精细的标注:<span style="color: rgb(0, 0, 0);">bounding boxes, object segmentations, visual relationships, localized narratives, point-level labels, and image-level labels. </span></p><p><span style="color: rgb(0, 0, 0);">具体来说,这份数据集包括:</span></p><p><span style="color: rgb(0, 0, 0);">600个类上的15,851,536个boxes</span></p><p><span style="color: rgb(0, 0, 0);">对350个类进行2,785,498个实例分割</span></p><p><span style="color: rgb(0, 0, 0);">3,284,280个关于1,466个关系的关系注释</span></p><p><span style="color: rgb(0, 0, 0);">675,155个本地化的叙述</span></p><p><span style="color: rgb(0, 0, 0);">对5,827个类的66,391,027个point级别注释</span></p><p><span style="color: rgb(0, 0, 0);">对20,638个类别的61,404,966个图像级标签</span></p><p><span style="color: rgb(0, 0, 0);">扩展数据中 - 478,000张众包图像,包含6,000多个类别</span></p><p><br></p><p><span style="color: rgb(0, 0, 0);">本数据集的特点如下:</span></p><ul><li><span style="color: rgb(0, 0, 0);">它包含了190万张图片上600个物体类别的16M个边界框,使其成为现有最大的物体位置注释数据集。这些方框主要是由专业注释者手工绘制的,以确保准确性和一致性。这些图像非常多样化,通常包含有多个物体的复杂场景(平均每张图像8.3个)。</span></li><li><span style="color: rgb(0, 0, 0);">开放图像还提供了视觉关系注释,表明特定关系的物体对(如 "弹吉他的女人"、"桌上的啤酒")、物体属性(如 "桌子是木制的")和人类行为(如 "女人在跳跃")。它总共有来自1,466个不同关系三元组的330个注释。</span></li><li><span style="color: rgb(0, 0, 0);">在V5中,我们为350个类中的280万个对象实例添加了分割掩码。分割掩码标志着物体的轮廓,它以更高的细节水平来描述其空间范围。</span></li><li><span style="color: rgb(0, 0, 0);">在V6中,我们增加了675k个本地化叙述:对图像的多模态描述,包括同步的语音、文字和在被描述物体上的鼠标痕迹。(请注意,我们最初在V6中只在培训中推出了本地化的叙述,但从2020年7月起,我们也有验证和测试的内容)。</span></li><li><span style="color: rgb(0, 0, 0);">在V7中,我们在140万张图片上增加了6640万个点级标签,覆盖了5827个类别。这些标签提供了稀疏的像素级定位,适用于零/少量照片的语义分割训练和评估。</span></li><li><span style="color: rgb(0, 0, 0);">最后,该数据集被添加了6140万个图像级别的标签,涵盖20638个类别。</span></li></ul><p><br></p>

发布者:Google

<p>COCO全称是Common Objects in Contenxt,由微软研究院和几位高校老师合作发布的图像数据集。最早的版本是2015年发布,2107年发布了新的版本。</p><p>各个版本的记录数如下:</p><table style="width: auto;"><tbody><tr><th colSpan="1" rowSpan="1" width="auto">年份(年)</th><th colSpan="1" rowSpan="1" width="auto">数据集类型</th><th colSpan="1" rowSpan="1" width="auto">记录数(万张)</th><th colSpan="1" rowSpan="1" width="auto">大小(GB)</th></tr><tr><td colSpan="1" rowSpan="1" width="auto">2014</td><td colSpan="1" rowSpan="1" width="auto">训练集</td><td colSpan="1" rowSpan="1" width="auto">8.3</td><td colSpan="1" rowSpan="1" width="auto">13</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">2014</td><td colSpan="1" rowSpan="1" width="auto">验证集</td><td colSpan="1" rowSpan="1" width="auto">4.1</td><td colSpan="1" rowSpan="1" width="auto">6</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">2014</td><td colSpan="1" rowSpan="1" width="auto">测试集</td><td colSpan="1" rowSpan="1" width="auto">4.1</td><td colSpan="1" rowSpan="1" width="auto">6</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">2015</td><td colSpan="1" rowSpan="1" width="auto">测试集</td><td colSpan="1" rowSpan="1" width="auto">8.1</td><td colSpan="1" rowSpan="1" width="auto">12</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">2017</td><td colSpan="1" rowSpan="1" width="auto">训练集</td><td colSpan="1" rowSpan="1" width="auto">11.8</td><td colSpan="1" rowSpan="1" width="auto">18</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">2017</td><td colSpan="1" rowSpan="1" width="auto">验证集</td><td colSpan="1" rowSpan="1" width="auto">0.5</td><td colSpan="1" rowSpan="1" width="auto">1</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">2017</td><td colSpan="1" rowSpan="1" width="auto">测试集</td><td colSpan="1" rowSpan="1" width="auto">4.1</td><td colSpan="1" rowSpan="1" width="auto">6</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">2017</td><td colSpan="1" rowSpan="1" width="auto">未标注数据</td><td colSpan="1" rowSpan="1" width="auto">12.3</td><td colSpan="1" rowSpan="1" width="auto">19</td></tr></tbody></table><p>COCO数据集十分著名,也和历年的学术会议挑战赛有关。不同年份的数据集也被用来测试不同任务。这些数据支持的任务包括图像检测(Detection)、图像描述(Captioning)、关键点(keypoint)、具有特定尺寸和形状的物体(COCO Stuff )、全景分割(Panoptic Segmentation)等。</p><p>这份数据的标注也很详细。具体来说:</p><ul><li>150万个对象实例</li><li>80个对象类别</li><li>91个特定尺寸和形状的类别</li><li>每个图片包含5个描述</li><li>25万个带关键点的人物</li></ul><p>需要注意的是:</p><ol><li>部分图片没有标注;</li><li>COCO 2014和2017数据集使用相同的图像集,但训练集、验证集和测试集的划分不同;</li><li>测试拆分没有任何标注,只有图像;</li><li>数据集总共定义了91个类,但只使用了80个类;</li><li>全景注释定义了200个类,但只使用133个。</li></ol><p>官方下载地址: <a href="https://cocodataset.org/#download" target="_blank">https://cocodataset.org/#download</a> </p><p>GitHub地址: <a href="https://github.com/cocodataset/cocodataset.github.io" target="_blank">https://github.com/cocodataset/cocodataset.github.io</a> </p><p>PapersWithCode地址: <a href="https://deepai.org/dataset/coco" target="_blank">https://deepai.org/dataset/coco</a> </p>

发布者:Microsoft

<p>DS-1000是由香港大学、北京大学等高校老师联合发布的一个代码生成领域的基准数据集。包含了1000个问题和答案,这些问题来自StackOverflow上451个问题。涵盖了7个Python领域库的相关问题和答案(如NumPy、Pandas等)。这些问题和答案花费了1200多个expert小时进行整理。具体来说,这些问题和答案:</p><ul><li>基于StackOverflow平台选择和重写</li><li>对问题做了干扰防止出现潜在的记忆问题</li><li>对于每一个问题都实现了一个个性化的评估指标</li></ul><p>这些工作都是十分耗费人力的工作。五位作者花费了大约1200个小时完成的。</p><p>DS-1000数据的样例,对于每一个问题,都包含了"[insert]"标记,任务就是把代码插入的insert位置。数据集包含了评估答案的评估指标。</p><p>对于来自StackOverflow的问题,作者为它们配备了prompts、测试用例和评估函数,并将它们称为Origin。为了防止模型简单地回忆预训练期间看到的解决方案,作者以两种方式扰动问题:表面扰动和语义扰动。为了使DS-1000更具挑战性,作者还引入了困难重写。其中152个问题做了surface perturbations,235个问题做了semantic perturbations,162个问题做了difficult rewrites。</p><p>涉及的7个Python库如下:</p><ul><li>NumPy</li><li>SciPy</li><li>Pandas</li><li>TensorFlow</li><li>PyTorch</li><li>Scikit-learn</li><li>Matplotlib</li></ul><p><br></p><p>具体的数据集目录如下:</p><pre><code >ds1000_data ├── Numpy ├── Completion └── Insertion ├──q0 ├── .cfg ├── ans ├── input ├── prompt.txt ├── code_context.txt ├── reference_code.txt ├── test_code.py └── test_generate_pickle.py ├── Pandas ├── Pytorch ├── Scipy ├── Sklearn ├── Tensorflow ├── Matplotlib</code></pre><p>以NumPy文件夹为例,里面包含Completion与Insertion两个prompts格式,这两个文件夹内容完全一样,只是prompts不同(一些代码情景和代码引用也有一点差异)。针对每一个文件及下的文件解释如下:</p><p><code>.cfg</code>:问题的元数据信息</p><p><code>ans和input</code>:是输入和解决对象的pickles文件</p><p><code>prompt.txt</code>:是官方推荐的用来查询大模型答案的prompt</p><p><code>code_context.txt</code>:是用于评估的可执行代码context</p><p><code>reference_code.txt</code>:是the ground truth solution code</p><p><code>test_code.py</code>:测试代码</p><p><code>test_generate_pickle.py</code>:用于生成input里面pickles文件的脚本</p><p><br></p><p>数据集下载地址: <a href="https://github.com/HKUNLP/DS-1000/raw/main/ds1000_data.zip" target="_blank">https://github.com/HKUNLP/DS-1000/raw/main/ds1000_data.zip</a></p><p>论文地址: <a href="https://arxiv.org/abs/2211.11501" target="_blank">https://arxiv.org/abs/2211.11501</a> </p><p>GitHub地址: <a href="https://github.com/HKUNLP/DS-1000" target="_blank">https://github.com/HKUNLP/DS-1000</a> </p><p>官方网站: <a href="https://ds1000-code-gen.github.io/" target="_blank">https://ds1000-code-gen.github.io/</a> </p><p>PapersWithCode地址: <a href="https://paperswithcode.com/paper/ds-1000-a-natural-and-reliable-benchmark-for" target="_blank">https://paperswithcode.com/paper/ds-1000-a-natural-and-reliable-benchmark-for</a> </p>

发布者:香港大学

<p>WuDaoCorpora 2.0是由北京智源人工智能研究院发布的多模态数据集。根据官网的介绍,WuDaoCorpora 2.0由全球最大的纯文本数据集、全球最大的多模态数据集和全球最大的中文对话数据集三部分构成,分别致力于构建微缩中文世界、打破图文模态壁垒、浓缩对话核心规律,从而形成多维度世界顶级数据库,促进中国的通用人工智能发展。</p><p>WuDaoCorpora 2.0数据集包含文本数据集、图文数据集和对话数据集三个。不过可惜的是,<span style="color: rgb(225, 60, 57);"><strong>WuDaoCorpora 2.0数据集只开源文本数据集中的200GB,其它数据均不对外开放!</strong></span></p><p><span style="font-size: 19px;"><strong>WuDaoCorpora 2.0文本数据集</strong></span></p><p>采用20多种规则从100TB原始网页数据中清洗得出最终数据集,注重隐私数据信息的去除,源头上避免GPT-3存在的隐私泄露风险;包含教育、科技等50+个行业数据标签,可以支持多领域预训练模型的训练。WuDaoCorpora 2.0的文本数据集原始大小为3TB,但是开源给业界使用的仅200GB。数据格式为json,其包含的字段如下:</p><table style="width: auto;"><tbody><tr><th colSpan="1" rowSpan="1" width="auto">字段名</th><th colSpan="1" rowSpan="1" width="auto">含义</th></tr><tr><td colSpan="1" rowSpan="1" width="auto">id</td><td colSpan="1" rowSpan="1" width="auto">数据在该json文件中的id</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">uniqueKey</td><td colSpan="1" rowSpan="1" width="auto">这条数据的唯一识别码</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">titleUkey</td><td colSpan="1" rowSpan="1" width="auto">该标题的唯一识别码</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">dataType</td><td colSpan="1" rowSpan="1" width="auto">数据类型</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">title</td><td colSpan="1" rowSpan="1" width="auto">数据标题</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">content</td><td colSpan="1" rowSpan="1" width="auto">正文</td></tr></tbody></table><p><span style="font-size: 19px;"><strong>WuDaoCorpora 2.0图文数据集</strong></span></p><p>数据集精选高质量6.5亿图文对,数据总量达到93TB。 数据标签包括科技、人物、艺术等60+种类别。采用全面的数据清洗规则,去除涉恐涉暴等隐私敏感信息,保证数据集质量;融合中西方数据源,帮助模型解决文化壁垒带来的数据偏置问题。</p><p><span style="font-size: 19px;"><strong>WuDaoCorpora 2.0对话数据集</strong></span></p><p>是目前体量最大的中文对话数据集。采用严格的逻辑清洗规则,对敏感数据进行过滤,从9TB原始数据筛选得到181GB高质量数据。可支撑智能助手、虚拟亲友等方面的下游应用,同时为开放型对话领域研究提供基础数据支撑。</p>

发布者:北京智源人工智能研究院

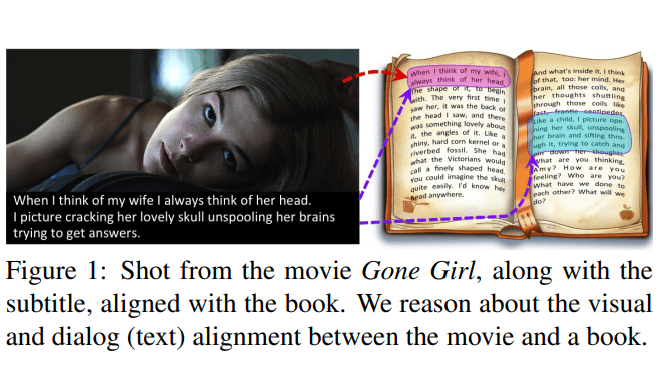

<p>BookCorpus是由多伦多大学的Yukun Zhu等人在2015年提出的一个关于书籍的数据集。该数据集主要是由尚未出版的作者写的免费书籍。该数据集的主要统计结果如下:</p><p><br></p><table style="width: auto;"><tbody><tr><th colSpan="1" rowSpan="1" width="auto">统计项</th><th colSpan="1" rowSpan="1" width="auto">统计项(英文)</th><th colSpan="1" rowSpan="1" width="auto">统计结果</th></tr><tr><td colSpan="1" rowSpan="1" width="auto">书籍数量</td><td colSpan="1" rowSpan="1" width="auto"># of books</td><td colSpan="1" rowSpan="1" width="auto">11038</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">语句数量</td><td colSpan="1" rowSpan="1" width="auto"># of sentences</td><td colSpan="1" rowSpan="1" width="auto">74004228</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">单词数量</td><td colSpan="1" rowSpan="1" width="auto"># of words</td><td colSpan="1" rowSpan="1" width="auto">984846357</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">独立单词数(词汇)</td><td colSpan="1" rowSpan="1" width="auto"># of unique words</td><td colSpan="1" rowSpan="1" width="auto">1316420</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">平均每个语句的单词数量</td><td colSpan="1" rowSpan="1" width="auto">mean # of words per sentence</td><td colSpan="1" rowSpan="1" width="auto">13</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">每个语句的单词中位数</td><td colSpan="1" rowSpan="1" width="auto">median # of words per sentence</td><td colSpan="1" rowSpan="1" width="auto">11</td></tr></tbody></table><p><br></p><p>作者收集的书籍中的每一本书都至少包含2万个单词,防止过短的内容产生噪音影响。BookCorpus被大量用来训练自然语言模型的embedding结果。</p><p>该数据集首次在论文Aligning Books and Movies: Towards Story-like Visual Explanations by Watching Movies and Reading Books中提出(arXiv地址: <a href="https://arxiv.org/abs/1506.06724" target="_blank">https://arxiv.org/abs/1506.06724</a> )</p>

发布者:多伦多大学

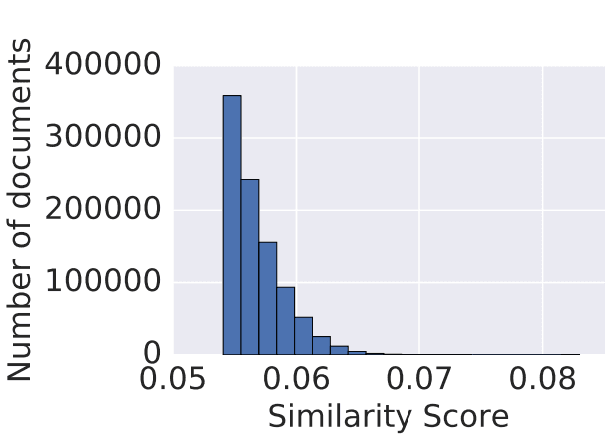

<p>CC-Stories(又称STORIES),最早是由谷歌研究人员在论文A Simple Method for Commonsense Reasoning中发布。这篇论文主要的目标是解决常识推理问题(Commonsense Reasoning)。作者根据之前论文的做法(在评估阶段观察问题,然后从knowledge bases收集相关数据),在Commonsense Reasoning Tasks中构建了一个个性化的文本语料库,即STORIES。</p><p>该数据集是谷歌自己构建的一个个性化数据集,并没有公布。但是论文中描述了数据集的收集方式:从CommonCrawl数据集中聚合文档,选择的条件是与Commonsense Reasoning Tasks中问题重复n-grams的结果。每个文档在计算重合的n-grams时候都采用加权求和的方式进行。最终,选择前0.1%的结果作为数据集,形成STORIES。将这个数据集命名为 "STORIES"的原因是大多数的组成文件都是以故事的形式出现的,有一长串连贯的事件。STORIES现在习惯性被叫成CC-Stories(CC就是CommonCrawl)的意思。</p><p>CC-Stories最终产生了月100万个文档,最高的得分月0.08,相比较理论最高1.0的得分依然是比较低的。</p><p style="text-align: center;"><img src="resources/ai_resources/images/46c52dc8-e454-4a78-9aa0-826b2adaee31.png" alt="" data-href="" style="width: 601.71px;height: 257.69px;"></p><p>尽管原始的CC-Stories数据集不再提供,但是也有人基于这个筛选规则,开源了一个CC-Stories的数据集,下载地址: <a href="https://huggingface.co/datasets/spacemanidol/cc-stories" target="_blank">https://huggingface.co/datasets/spacemanidol/cc-stories</a> </p>

发布者:Google

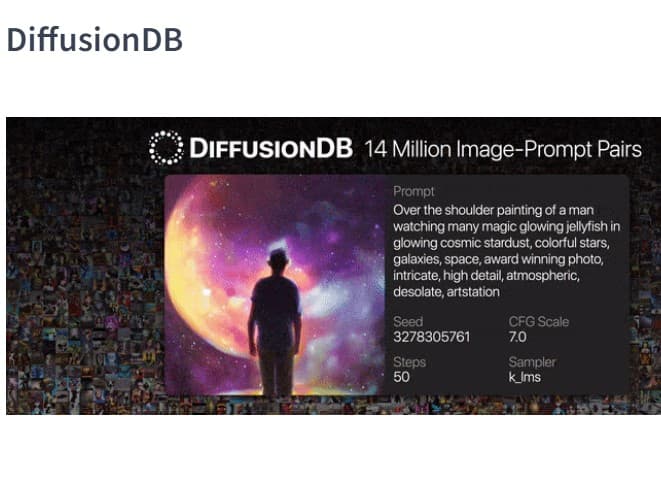

<p><span style="color: rgb(75, 85, 99); background-color: rgb(255, 255, 255);">DiffusionDB是全网第一个公开的大规模文本生成图像模板数据集(Text-to-Image Prompt)。它包含1400万个基于Stable Diffusion生成的图像。这些图像的参数设定由真实的用户设定prompts和超参数产生。</span></p><p><span style="color: rgb(75, 85, 99); background-color: rgb(255, 255, 255);">DiffusionDB目前是公开可获取的数据,它可以帮助我们完成多项任务,包括理解模板和生成模型之间的相互作用、检测deepfakes以及设计人类-人工智能交互工具以帮助用户更容易使用这些模型等。</span></p><p><span style="color: rgb(75, 85, 99); background-color: rgb(255, 255, 255);">注意,本数据集中大部分语言都是英语,不过也包含西班牙语、中文和俄语。</span></p><p><span style="color: rgb(75, 85, 99); background-color: rgb(255, 255, 255);"><strong>DiffusionDB具体信息</strong></span></p><p><span style="color: rgb(75, 85, 99); background-color: rgb(255, 255, 255);">根据需要,DiffusionDB提供两个版本的数据集,分别是</span>DiffusionDB 2M和DiffusionDB Large<span style="color: rgb(75, 85, 99); background-color: rgb(255, 255, 255);">:</span></p><table style="width: auto;"><tbody><tr><th colSpan="1" rowSpan="1" width="auto">数据集名称</th><th colSpan="1" rowSpan="1" width="auto">图像数量</th><th colSpan="1" rowSpan="1" width="auto">不同prompts数量</th><th colSpan="1" rowSpan="1" width="auto">大小</th></tr><tr><td colSpan="1" rowSpan="1" width="auto">DiffusionDB 2M</td><td colSpan="1" rowSpan="1" width="auto">200万</td><td colSpan="1" rowSpan="1" width="auto">150万</td><td colSpan="1" rowSpan="1" width="auto">1.6TB</td></tr><tr><td colSpan="1" rowSpan="1" width="auto">DiffusionDB Large</td><td colSpan="1" rowSpan="1" width="auto">1400万</td><td colSpan="1" rowSpan="1" width="auto">180万</td><td colSpan="1" rowSpan="1" width="auto">6.5TB</td></tr></tbody></table><p>这两个数据集的差别如下:</p><ol><li>两个子集的不同的prompts数量相似,但DiffusionDB Large的图片要多得多。DiffusionDB Large是DiffusionDB 2M的一个超集。</li><li>DiffusionDB 2M中的图片是以png格式存储的;DiffusionDB Large中的图片使用的是无损的webp格式。</li></ol><p>作者使用模块化的文件结构来分发DiffusionDB。DiffusionDB 2M中的200万张图片被分成2000个文件夹,其中每个文件夹包含1000张图片和一个JSON文件,该文件将这1000张图片与它们的提示和超参数联系起来。同样地,DiffusionDB Large中的1400万张图像被分成14000个文件夹。</p><p>数据集文件结构如下:</p><pre><code ># DiffusionDB 2M ./ ├── images │ ├── part-000001 │ │ ├── 3bfcd9cf-26ea-4303-bbe1-b095853f5360.png │ │ ├── 5f47c66c-51d4-4f2c-a872-a68518f44adb.png │ │ ├── 66b428b9-55dc-4907-b116-55aaa887de30.png │ │ ├── [...] │ │ └── part-000001.json │ ├── part-000002 │ ├── part-000003 │ ├── [...] │ └── part-002000 └── metadata.parquet </code></pre><pre><code ># DiffusionDB Large ./ ├── diffusiondb-large-part-1 │ ├── part-000001 │ │ ├── 0a8dc864-1616-4961-ac18-3fcdf76d3b08.webp │ │ ├── 0a25cacb-5d91-4f27-b18a-bd423762f811.webp │ │ ├── 0a52d584-4211-43a0-99ef-f5640ee2fc8c.webp │ │ ├── [...] │ │ └── part-000001.json │ ├── part-000002 │ ├── part-000003 │ ├── [...] │ └── part-010000 ├── diffusiondb-large-part-2 │ ├── part-010001 │ │ ├── 0a68f671-3776-424c-91b6-c09a0dd6fc2d.webp │ │ ├── 0a0756e9-1249-4fe2-a21a-12c43656c7a3.webp │ │ ├── 0aa48f3d-f2d9-40a8-a800-c2c651ebba06.webp │ │ ├── [...] │ │ └── part-000001.json │ ├── part-010002 │ ├── part-010003 │ ├── [...] │ └── part-014000 └── metadata-large.parquet </code></pre><p><strong>数据集样例</strong></p><p>例如,下面是f3501e05-aef7-4225-a9e9-f516527408ac.png的图片和它在part-000001.json中的键值对。</p><p><img src="resources/ai_resources/images/c4da5c56-abab-45b5-b079-b466beb07883.png" alt="" data-href="" style="width: 323.00px;height: 258.39px;"/></p><pre><code >{ "f3501e05-aef7-4225-a9e9-f516527408ac.png": { "p": "geodesic landscape, john chamberlain, christopher balaskas, tadao ando, 4 k, ", "se": 38753269, "c": 12.0, "st": 50, "sa": "k_lms" }, } </code></pre><p>上述具体字段含义如下:</p><ol><li>key:唯一的图像名称</li><li>p: 模板(Prompt)</li><li>se: 随机种子</li><li>c: CFG规模(指导规模)</li><li>st: 步数(Steps)</li><li>sa: 采样器(Sampler)</li></ol><p><strong>DiffusionDB数据集的下载和使用</strong></p><p>DiffusionDB在HuggingFace上开源托管: <a href="https://huggingface.co/datasets/poloclub/diffusiondb" target="_blank">https://huggingface.co/datasets/poloclub/diffusiondb</a> </p><p>相关的代码在GitHub上: <a href="https://github.com/poloclub/diffusiondb" target="_blank">https://github.com/poloclub/diffusiondb</a> </p><p>论文地址: <a href="https://arxiv.org/abs/2210.14896" target="_blank">DiffusionDB: A Large-scale Prompt Gallery Dataset for Text-to-Image Generative Models</a> </p><p>DiffusionDB的下载使用方式有两个,一个是使用HuggingFace的官方脚本:</p><pre><code >import numpy as np from datasets import load_dataset # Load the dataset with the `large_random_1k` subset dataset = load_dataset('poloclub/diffusiondb', 'large_random_1k') </code></pre><p>第二个方法是使用PoloClub下载脚本:</p><p>脚本地址: <a href="https://github.com/poloclub/diffusiondb/blob/main/scripts/download.py" target="_blank">https://github.com/poloclub/diffusiondb/blob/main/scripts/download.py</a> </p><p>使用这个脚本运行即可。</p><p><strong>DiffusionDB数据集的开源协议</strong></p><p>DiffusionDB数据集以CC0 1.0许可协议提供。该资源库中的Python代码在MIT许可下提供。因此,使用基本没有限制(CC0 1.0是非常自由的开源协议: <a href="https://creativecommons.org/publicdomain/zero/1.0/" target="_blank">https://creativecommons.org/publicdomain/zero/1.0/</a> 没有版权要求,MIT也是类似!)</p><p><br></p><p><strong>DiffusionDB的引用</strong></p><pre><code >@article{wangDiffusionDBLargescalePrompt2022, title = {{{DiffusionDB}}: {{A}} Large-Scale Prompt Gallery Dataset for Text-to-Image Generative Models}, author = {Wang, Zijie J. and Montoya, Evan and Munechika, David and Yang, Haoyang and Hoover, Benjamin and Chau, Duen Horng}, year = {2022}, journal = {arXiv:2210.14896 [cs]}, url = {https://arxiv.org/abs/2210.14896} } </code></pre><p><br></p>

发布者:Jay Wang

<p>SlimPajama是一个开源的大模型训练数据集。</p>

发布者:Cerebras

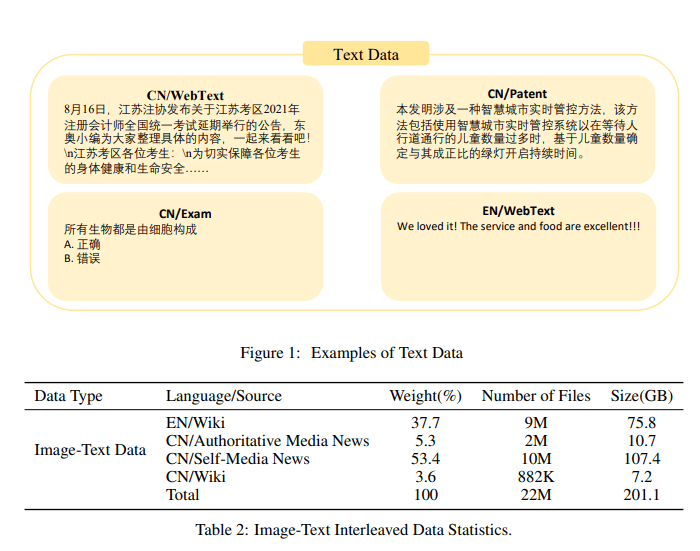

<p>书生·万卷 1.0是由上海人工智能实验室发布的一个开源大规模数据集,包含三个部分:纯文本格式数据集、文本-图像对数据集和视频数据集。</p><p><br></p><h4><strong>大模型训练所需要的中文数据集很匮乏</strong></h4><p><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">随着近年来GPT-3、ChatGPT等大模型的兴起,高质量的数据集在模型训练中扮演着越来越重要的角色。但是当前领先的预训练模型使用的数据集细节往往不公开,开源数据的匮乏制约着研究社区的进一步发展。</span><span style="color: rgb(225, 60, 57); background-color: rgb(255, 255, 255);"><strong>特别是大规模中文数据集十分缺乏,对中文大模型以及业界模型的中文支持都有很大的影响</strong></span><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">。此次,上海人工智能实验室发布的这个数据集包含了丰富的中文,对于大模型的中文能力提升十分有价值。</span></p><p><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">为此,上海人工智能实验室近日开源发布了大规模多语言多模态数据集书生·万卷 1.0。</span></p><p><br></p><h4><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);"><strong>书生·万卷 1.0数据集详细介绍</strong></span></h4><p><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">该数据集包含三个部分:纯文本数据集、文本图像对数据集和纯视频数据集。分别介绍如下:</span></p><p><br></p><h5><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);"><strong>书生·万卷 1.0文本数据集介绍</strong></span></h5><p><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">书生·万卷 1.0文本数据集包含6亿份文档,来源于网络和书籍等。具体来说,所包含的数据集领域如下:</span></p><p><br></p><table style="width: auto; text-indent: 0px; text-align: start;"><tbody><tr><th colspan="1" rowspan="1" width="auto">来源</th><th colspan="1" rowspan="1" width="auto">具体内容</th><th colspan="1" rowspan="1" width="auto">数据集规模</th></tr><tr><td colspan="1" rowspan="1" width="auto">英文互联网数据</td><td colspan="1" rowspan="1" width="auto">来源于Common Crawl的网页数据</td><td colspan="1" rowspan="1" width="auto">3.83亿个文件,542.51GB</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文互联网数据</td><td colspan="1" rowspan="1" width="auto">来源于网络上的各种网页、文档等</td><td colspan="1" rowspan="1" width="auto">2.2亿个文件,466.54GB</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文法律数据</td><td colspan="1" rowspan="1" width="auto">来源于法律法规、判决文书等法律领域数据</td><td colspan="1" rowspan="1" width="auto">800万个文件,37.89GB</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文新闻数据</td><td colspan="1" rowspan="1" width="auto">来源于各大新闻媒体的新闻报道</td><td colspan="1" rowspan="1" width="auto">700万个文件,21.53GB</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文考试数据</td><td colspan="1" rowspan="1" width="auto">来源于各类考试的题目、试卷等</td><td colspan="1" rowspan="1" width="auto">400万个文件,18.46GB</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文专利数据</td><td colspan="1" rowspan="1" width="auto">来源于专利文献数据库</td><td colspan="1" rowspan="1" width="auto">100万个文件,4.62GB</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文教材数据</td><td colspan="1" rowspan="1" width="auto">来源于各学科教材</td><td colspan="1" rowspan="1" width="auto">45.4万个文件,2.38GB</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文维基百科</td><td colspan="1" rowspan="1" width="auto">来源于中文维基百科</td><td colspan="1" rowspan="1" width="auto">9.2万个文件,0.11GB</td></tr></tbody></table><p>可以看到,数据集十分丰富。根据介绍,<span style="color: rgb(225, 60, 57); background-color: rgb(255, 255, 255);"><strong>书生·万卷 1.0文本数据集中中文数据占比35.1%,约2.2亿个文件,466.54GB。英文数据集占比61.4%,共3.83亿个文件,542.51GB</strong></span><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">。可以说应该是目前开源领域包含最多的中文数据集了!</span></p><p><br></p><h5><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);"><strong>书生·万卷 1.0文本-图像对数据集介绍</strong></span></h5><p><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">书生·万卷 1.0文本-图像对数据集包含2200多万个文本-图像对数据,数据量超过200GB(不含图像文件)。其中主要来源如下:</span></p><table style="width: auto; text-indent: 0px; text-align: start;"><tbody><tr><th colspan="1" rowspan="1" width="auto">来源</th><th colspan="1" rowspan="1" width="auto">占比</th><th colspan="1" rowspan="1" width="auto">数据量</th></tr><tr><td colspan="1" rowspan="1" width="auto">英文维基百科</td><td colspan="1" rowspan="1" width="auto">37.7%</td><td colspan="1" rowspan="1" width="auto">900万对</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文权威媒体新闻</td><td colspan="1" rowspan="1" width="auto">5.3%</td><td colspan="1" rowspan="1" width="auto">200万对</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文自媒体新闻</td><td colspan="1" rowspan="1" width="auto">53.4%</td><td colspan="1" rowspan="1" width="auto">1000万对</td></tr><tr><td colspan="1" rowspan="1" width="auto">中文维基百科</td><td colspan="1" rowspan="1" width="auto">3.6%</td><td colspan="1" rowspan="1" width="auto">88.2万对</td></tr></tbody></table><p><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">可以看到,这里的中文数据占比达到了62.3%!十分丰富!</span></p><p><br></p><h5><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);"><strong>书生·万卷 1.0视频数据集介绍</strong></span></h5><p>书生·万卷 1.0视频数据集式包含1000多个视频文件,来源<span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">中国媒体集团(CMG)和上海媒体集团(SMG)的节目。</span></p><p><br></p><h4><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);"><strong>书生·万卷 1.0数据集总结</strong></span></h4><ol style="text-indent: 0px; text-align: start;"><li>文本数据包括超过6亿个文档,数据量超过1TB。图像文本数据经处理形成超过2200万个文档,数据量超过200GB。视频数据包含超过1000个视频,数据量超过900GB。</li><li>数据收集和处理过程中,采用了算法和人工验证相结合的方式,确保数据安全、高质量以及价值取向。</li><li>提供了统一的JSON格式处理,数据集下载工具及支持文档,方便用户快速应用大模型训练。</li><li>该数据集中的预训练数据显著提升了训练模型的知识内涵、逻辑推理和泛化能力。</li><li>数据集的开放发布有助于自然语言处理和计算机视觉等领域的模型训练和算法研究,尤其是需要多模态理解和生成的任务。</li><li>本数据集填补了公开源大规模多模态预训练数据集的空白,有助于推动相关领域技术的进一步发展。</li></ol><p><br></p><p>最后,书生·万卷 1.0数据集的开源协议是 CC BY 4.0 ,<span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">是知识共享组织制定的一个开源协议,它</span><span style="color: rgb(225, 60, 57); background-color: rgb(255, 255, 255);"><strong>允许用户可以自由地共享、修改和商业使用受该协议保护的内容</strong></span><span style="color: rgb(28, 25, 23); background-color: rgb(255, 255, 255);">,只要遵守署名要求即可。</span></p><p>下载地址: <a href="https://opendatalab.org.cn/WanJuan1.0" target="_blank">https://opendatalab.org.cn/WanJuan1.0</a> </p>

发布者:上海人工智能实验室

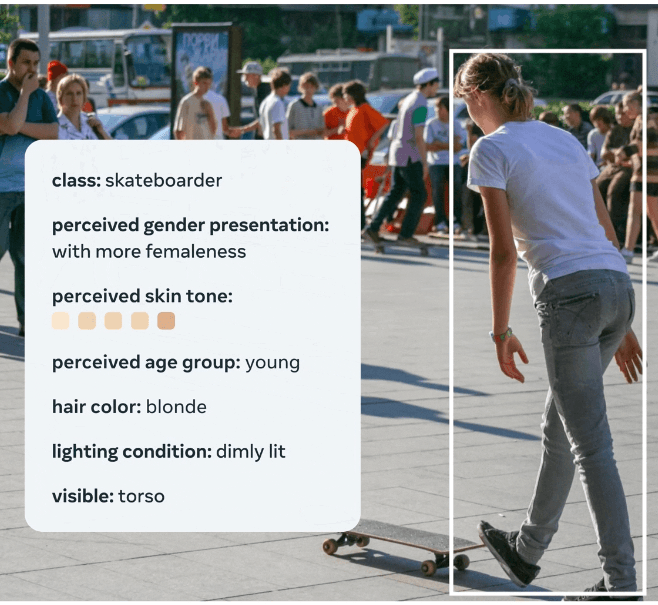

<p>FACET是一个全面的基准数据集,旨在衡量或评估受保护群体的人工智能和机器学习视觉模型的稳健性和算法公平性。</p>

发布者:MetaAI