又一个国产开源大模型发布:前腾讯创始人创业公司元象发布XVERSE-13B,超过Baichuan-13B,与ChatGLM2-12B齐平!但免费商用授权!

1,390 阅读

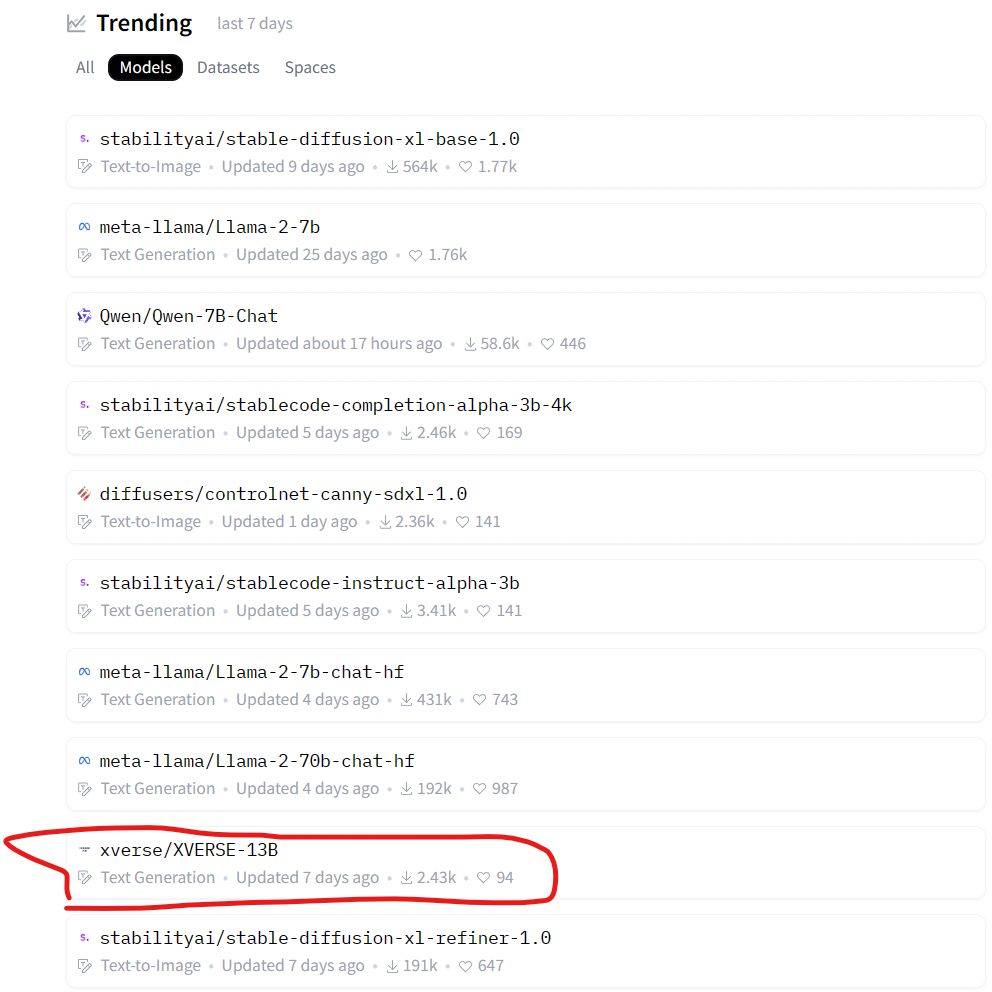

XVERSE-13B是元象开源的一个大语言模型,发布一周后就登顶HuggingFace流行趋势榜。该模型最大的特点是支持多语言,其中文和英文水平都十分优异,在评测结果上超过了Baichuan-13B,与ChatGLM2-12B差不多,不过ChatGLM2-12B是收费模型,而XVERSE-13B是免费商用授权!

元象简介

这是一家成立于2021年的初创企业,由腾讯公司前副总裁姚星创办。2022年3月A/A+轮融资1.2亿美元。

此前,该公司的产品和服务与元宇宙关系密切,包括一些3D互动技术等。本次发布的大语言模型是在HuggingFace上也吸引了很多人的下载使用。