EleutherAI、MetaAI、StabilityAI、伦敦大学等合作的最新关于大语言模型的11个应用方向和16个挑战总结:来自688篇参考文献与业界实践

前天,EleutherAI、MetaAI、StabilityAI、伦敦大学等研究人员合作提交了一个关于大语言模型(Large Language Model,LLM)的挑战和应用的论文综述,引用了688篇参考文献总结了当前LLM的主要挑战和应用方向。

这个论文并不是简单罗列论文,而是从业界实践和学术研究多方面综合性系统性地总结了当前LLM的问题,十分值得学习。本文总结一下这篇论文的核心内容。

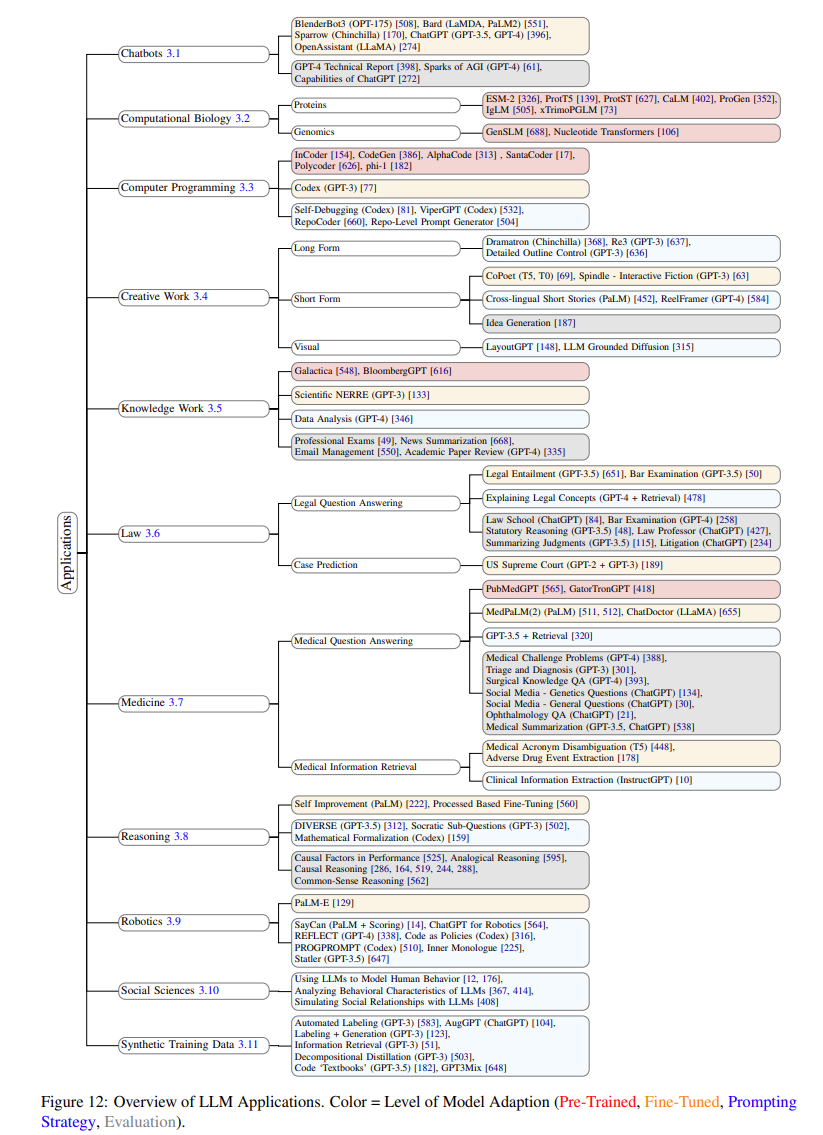

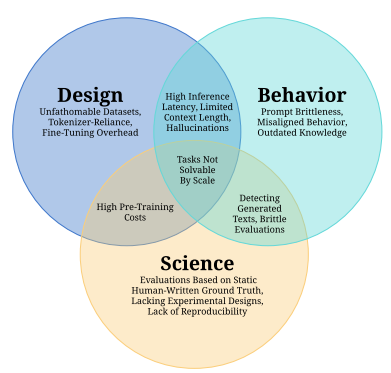

这篇论文大方向就两个,一个是LLM的挑战,一个是LLM的应用。作者先说的LLM挑战,再说的应用,我们换个思路,先说一下LLM的11个应用方向,再说一下LLM的16个挑战。