阿里开源截止目前为止参数规模最大的Qwen1.5-110B模型:MMLU评测接近Llama-3-70B,略超Mixtral-8×22B!

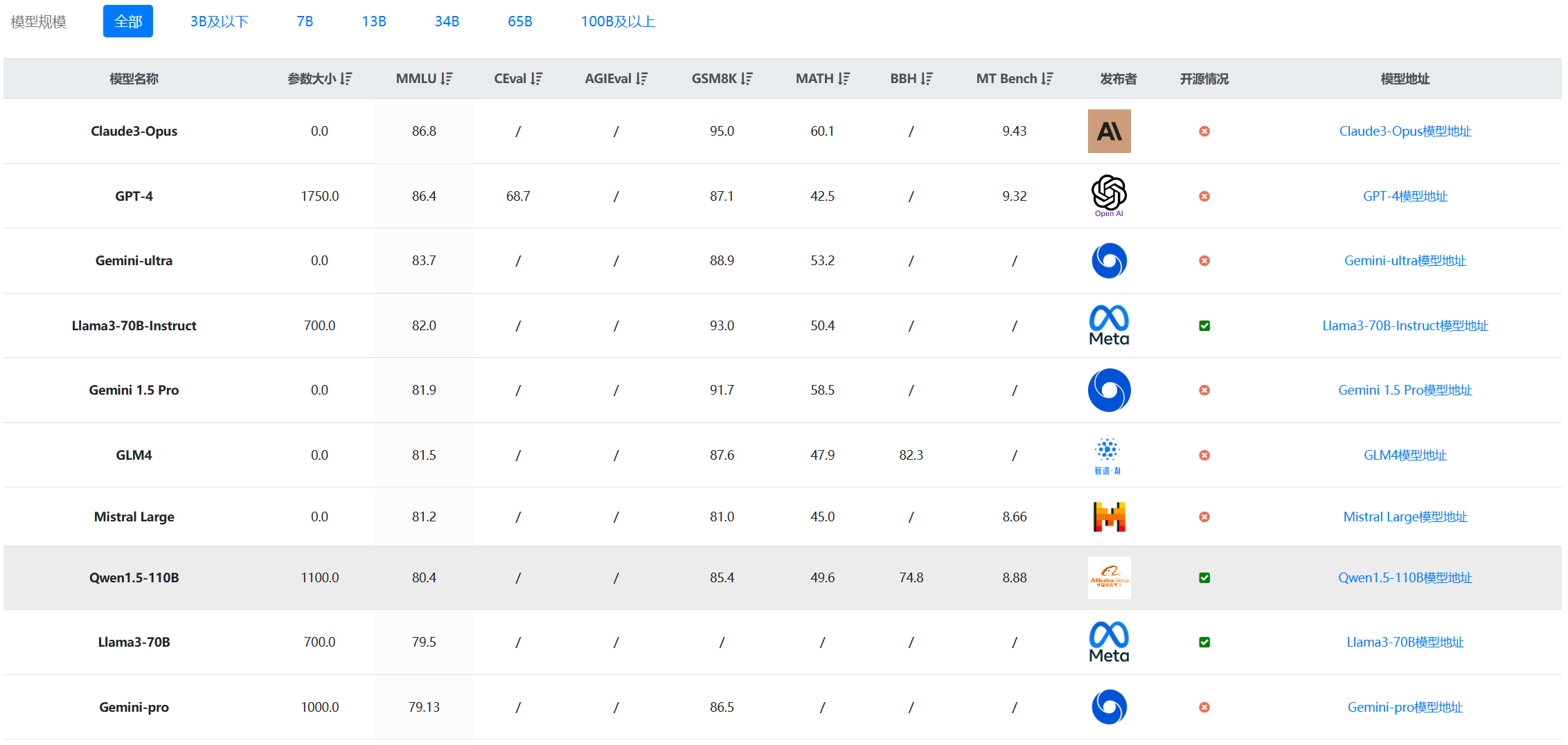

Qwen1.5系列是阿里开源的一系列大语言模型,也是目前为止最强开源模型之一。Qwen1.5是Qwen2的beta版本,此前开源的模型最大参数规模都是720亿,和第一代模型一样。就在刚刚,阿里开源了1100亿参数规模的Qwen1.5-110B模型。评测结果显示MMLU略超Llama3-70B和Mixtral-8×22B。DataLearnerAI实测结果,相比Qwen1.5-72B模型来说,Qwen1.5-110B模型复杂任务的逻辑提升比较明显!

Qwen1.5-110B模型简介

在开源大模型领域,最大的模型参数规模通常不会超过700亿参数规模。最近2个月,国外开源的DBRX、Mixtral-8×22B-MoE是最新的超过1000亿参数规模的模型。而国内此前开源领域最大的参数模型是720亿参数规模的Qwen1.5-72B规模和650亿参数的深圳元象科技开源的XVERSE-65B。

这次阿里开源的1100亿参数规模的Qwen1.5-110B模型是截止目前为止国内开源模型中参数规模最大的模型。Qwen1.5-110B模型与其它Qwen1.5系列模型架构一致。采用了分组查询注意力机制,因此推理效率很高。该模型最高支持32K上下文,并且支持多语言,包括英文、中文、法语、西班牙语、德语、俄语、韩语、日文等。

按照1100亿参数估计,。