重磅!阿里开源325亿参数规模的推理大模型QwQ-32B:性能接近DeepSeek R1满血版,参数更低,免费商用授权!

就在几个小时前,阿里巴巴开源了最新的一个推理大模型,QwQ-32B,该模型拥有类似o1、DeepSeek R1模型那样的推理能力,但是参数仅325亿,以Apache 2.0开源协议开源,这意味着大家可以完全免费商用。

QwQ-32B模型简介

其实,在2024年11月28日,阿里就已经开源了预览版的推理大模型QwQ-32B-Preview,彼时DeepSeek R1尚未发布(2024年11月20日,DeepSeek官宣了DeepSeek-R1-Lite-Preview,但是没开源)。这应该是当时最早开源的推理大模型之一。三个月后的今天,QwQ-32B正式开源,去掉了预览版的标签。

相比预览版,正式版的QwQ-32B各方面都有明显的提升,包括上下文长度增加到131K(预览版为32K),AIME评分提升50%等。

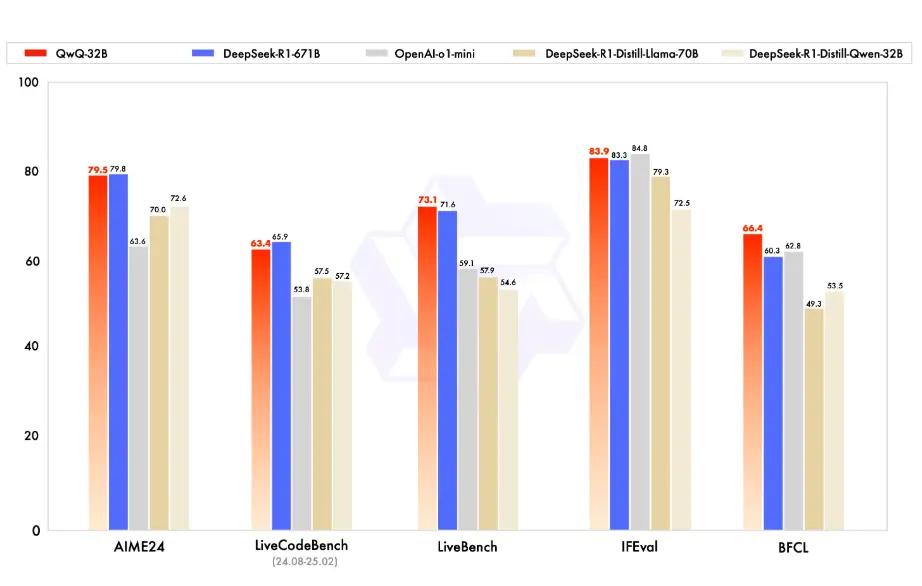

QwQ 是 Qwen 系列中的推理模型,相较于传统的指令微调模型,QwQ 具备更强的思考和推理能力,能够在下游任务中,尤其是高难度问题上,展现出显著的性能提升。QwQ-32B 作为该系列的中等规模版本,其推理能力在多个基准测试中表现出竞争力,与 DeepSeek-R1、o1-mini 等当前领先的推理模型相媲美。

QwQ-32B模型的主要技术参数如下: