FrontierMath:AI大模型高级数学推理评测的新基准

FrontierMath是一个由Epoch AI开发的基准测试套件,包含数百个原创的数学问题。这些问题由专家数学家设计和审核,覆盖现代数学的主要分支,如数论、实分析、代数几何和范畴论。每个问题通常需要相关领域研究人员投入数小时至数天的努力来解决。基准采用未发表的问题和自动化验证机制,以减少数据污染风险并确保评估可靠性。当前最先进的AI模型在该基准上的解决率低于2%,这反映出AI在处理专家级数学推理时的局限性。该基准旨在为AI系统向研究级数学能力进步提供量化指标。

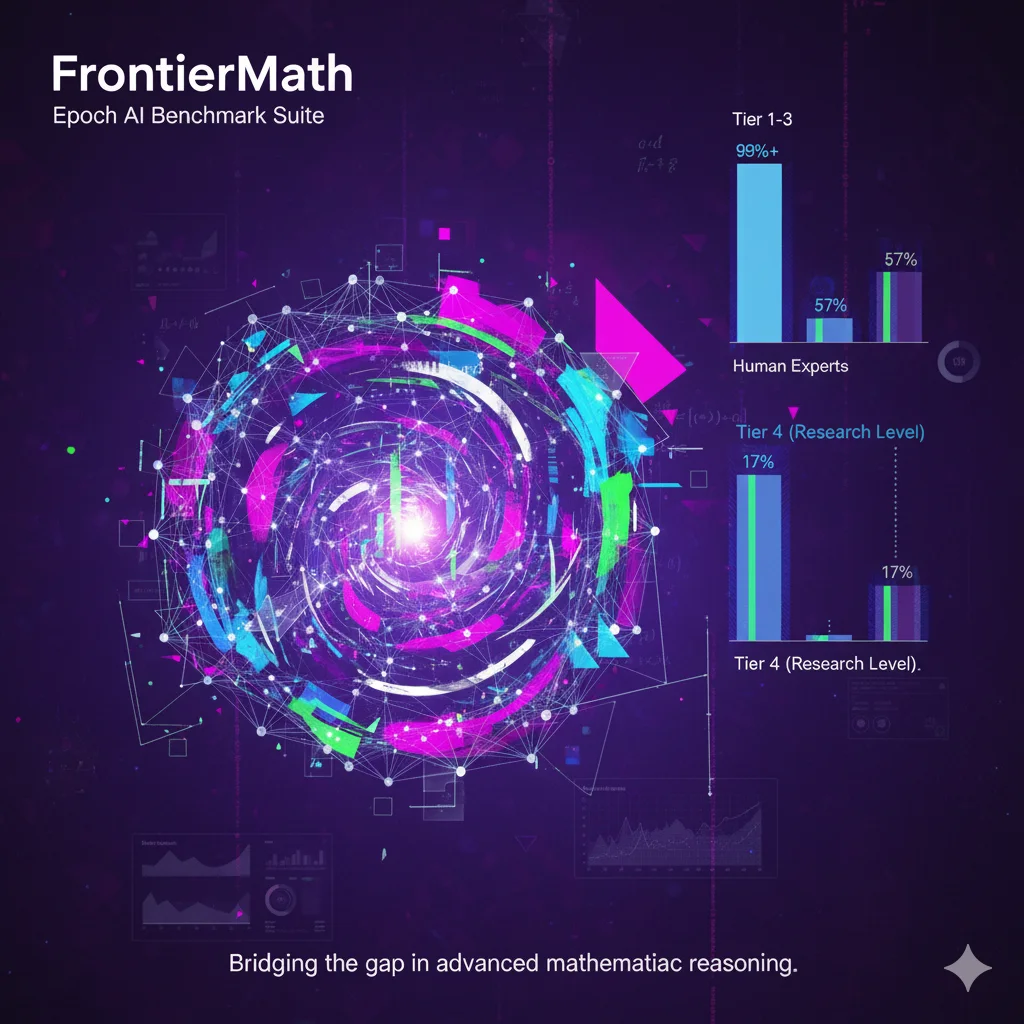

目前,FrontierMath分为2个不同版本的评测,Tier1-3是属于本科阶段的数学水平,具体排行数据参考DataLearnerAI的FrontierMath排行榜:https://www.datalearner.com/benchmarks/frontier-math FrontierMath Tier 4是研究生级别的数学问题,具体数据参考DataLearnerAI的FrontierMath - Tier4的排行榜:https://www.datalearner.com/benchmarks/frontier-math-tier-4