加载中...

加载中...

LongChat-13B-16K

数据优先来自官方发布(GitHub、Hugging Face、论文),其次为评测基准官方结果,最后为第三方评测机构数据。 了解数据收集方法

LongChat-13B-16K是由LM-SYS开源的一个支持超长上下文输入的聊天大语言模型。也是目前开源领域对超长上下文支持最好的模型之一。关于LongChat的基本介绍参考: https://www.datalearner.com/blog/1051688222070709

2023年6月29日,LM-SYS发布LongChat系列的时候除了这里的LongChat-13B-16K,还包括一个7B版本的模型,参考: https://www.datalearner.com/ai-models/pretrained-models/LongChat-7B-16K

LongChat-13B-16K是基于MetaAI开眼的LLaMA-13B进行微调得到的。使用ShareGPT中提供的用户与GPT的对话数据微调得到。原始的LLaMA模型只支持2048长度的输入。而LongChat-7B则通过将原始输入长度进行重新编码后得到支持16K长度的上下文输入。具体方法参考: https://www.datalearner.com/blog/1051688257255268

官方公布的评测结果看,在发布的时候LongChat-13B-16K是开源领域对长输入支持最好的模型。官方的两个评测任务中,LongChat-13B-16K都是只比商业模型GPT-3.5和Claude-1.3差。

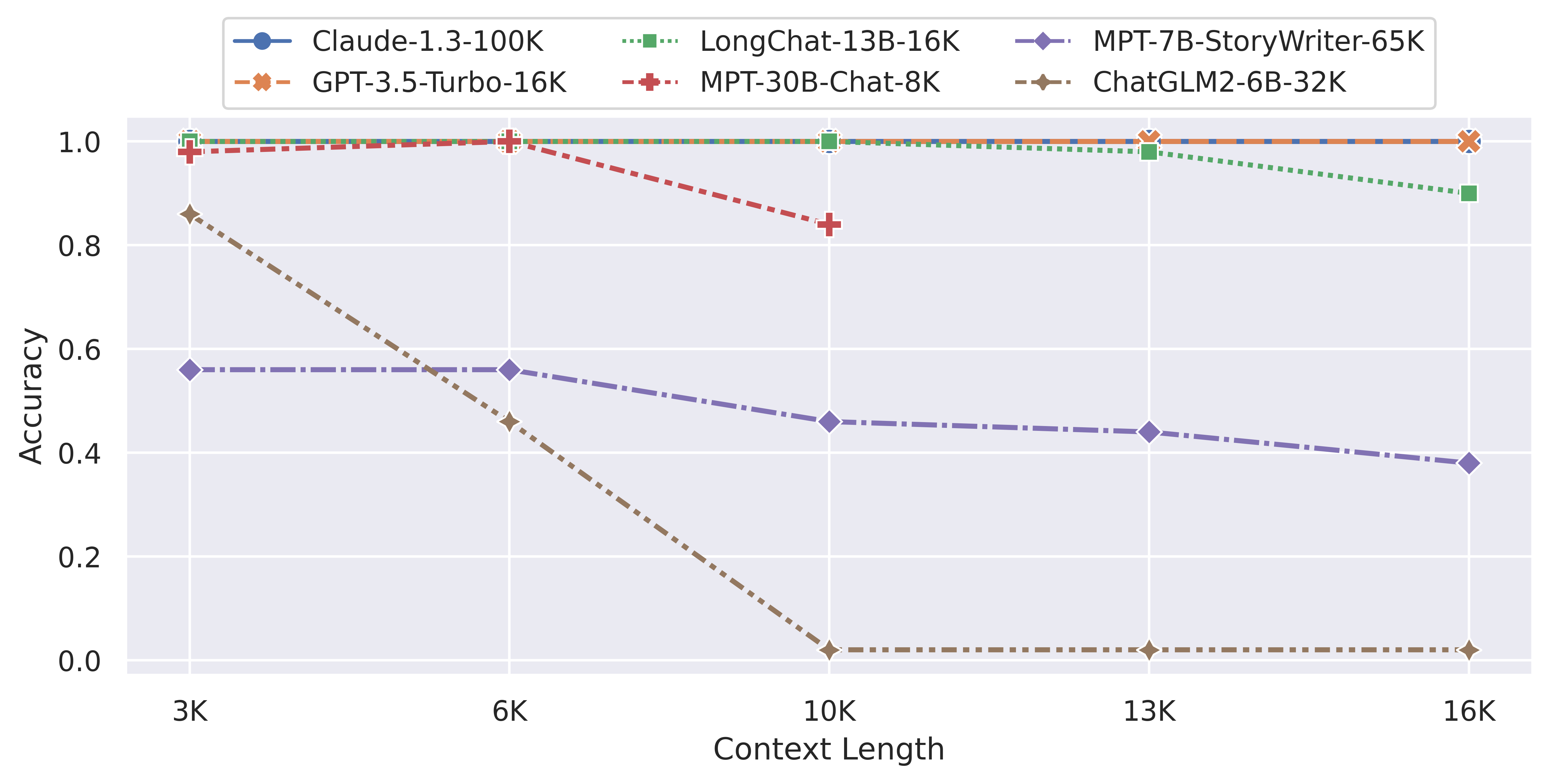

下图是超长主题检索评测结果总结:

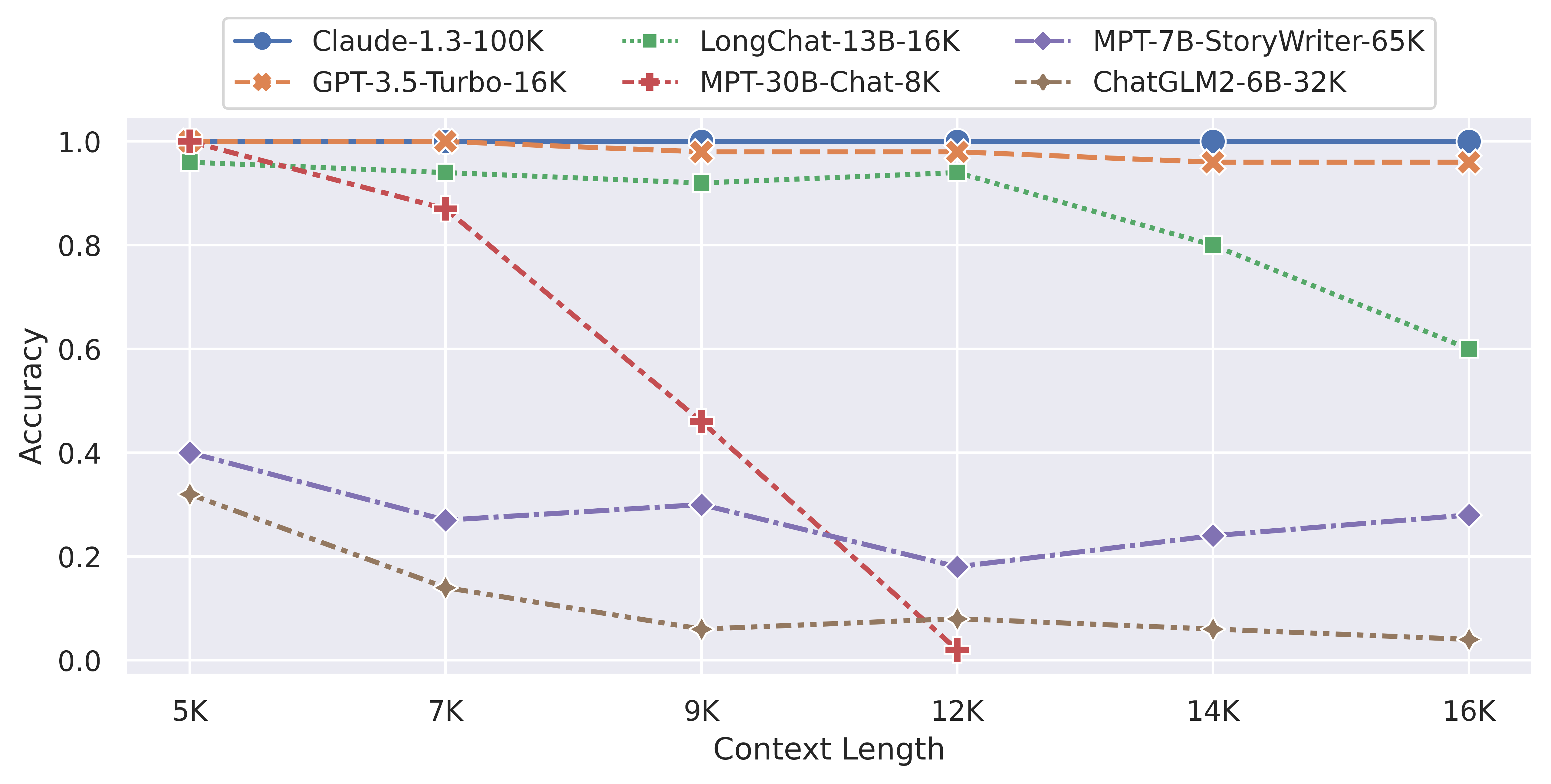

下图是超长行检索评测结果总结

上述2个任务介绍:

任务1 - 粗粒度主题检索:在现实生活中的长对话中,用户通常会与chatbot交谈和切换多个主题。主题检索任务模拟了这种场景,要求chatbot检索长对话中包含多个主题的第一个主题。

任务2 - 精细粒度行检索:为了进一步测试模型从长对话中定位和关联文本的能力,LongChat引入了一种更精细粒度的行检索测试。在这项测试中,LLM需要从长文档中精确检索出一个编号,而不是从多轮长对话中检索一个主题。

官方宣称这两个任务都是大家在使用LLM遇到的比较多的超长上下文的应用场景,代表了模型在支持现实中超长上下文使用的真实场景。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送