ChatGLM2-6B

聊天大模型Chat General Language Model 2 - 6B

发布时间: 2023-06-25

模型参数(Parameters)

62.0

最高上下文长度(Context Length)

32K

是否支持中文

支持

推理能力(Reasoning)

模型基本信息

是否支持推理过程

不支持

最高上下文输入长度

32K tokens

最长输出结果

暂无数据

模型类型

聊天大模型

发布时间

2023-06-25

模型预文件大小

12GB

开源和体验地址

官方介绍与博客

官方论文

DataLearnerAI博客

暂无介绍博客

API接口信息

接口速度(满分5分)

暂无数据

接口价格

输入价格:

- 文本: 暂无数据

- 图片: 暂无数据

- 音频: 暂无数据

- 视频: 暂无数据

- Embedding: 暂无数据

输出价格:

- 文本: 暂无数据

- 图片: 暂无数据

- 音频: 暂无数据

- 视频: 暂无数据

- Embedding: 暂无数据

输入支持的模态

文本

输入不支持

图片

输入不支持

视频

输入不支持

音频

输入不支持

Embedding(向量)

输入不支持

输出支持的模态

文本

输出不支持

图片

输出不支持

视频

输出不支持

音频

输出不支持

Embedding(向量)

输出不支持

ChatGLM2-6B模型在各大评测榜单的评分

发布机构

智谱AI

查看发布机构详情

模型介绍

关于ChatGLM2-6B的详细介绍可以参考: https://www.datalearner.com/blog/1051687694704581

ChatGLM2-6B是清华大学知识工程和数据挖掘小组(Knowledge Engineering Group (KEG) & Data Mining at Tsinghua University)发布的ChatGLM-6B模型的第二代。于2023年6月25日发布。

相比较第一代的ChatGLM-6B,ChatGLM2-6B模型的性能更加强大,并支持更长的上下文。

ChatGLM2-6B 使用了 Multi-Query Attention,提高了生成速度。生成 2000 个字符的平均速度对比如下

| Model | 推理速度 (字符/秒) |

|---|---|

| ChatGLM-6B | 31.49 |

| ChatGLM2-6B | 44.62 |

ChatGLM2-6B的推理显存需求:

| 量化等级 | 编码 2048 长度的最小显存 | 生成 8192 长度的最小显存 |

|---|---|---|

| FP16 / BF16 | 13.1 GB | 12.8 GB |

| INT8 | 8.2 GB | 8.1 GB |

| INT4 | 5.5 GB | 5.1 GB |

ChatGLM2-6B模型的预训练文件下载地址

HuggingFace地址: https://huggingface.co/THUDM/chatglm2-6b/tree/main

清华大学云盘地址: https://cloud.tsinghua.edu.cn/d/674208019e314311ab5c/

注意,所有的bin文件都要下载,而且config.json也要下载,这个文件只能在HuggingFace上下载,缺少这个文件会报配置错误。

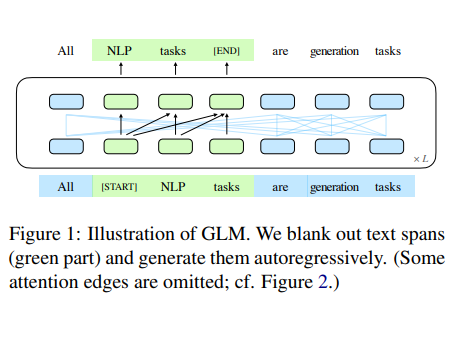

Foundation Model

GLM

View Details关注DataLearnerAI公众号

关注DataLearnerAI微信公众号,接受最新大模型资讯