Stable Diffusion的Tensorflow/Keras实现及使用

最近一段时间Text-to-Image模型十分火热。OpenAI的DALL·E2模型的效果十分惊艳。不过,由于Open AI现在的不Open策略,大家还无法使用这个模型,业界只开放了一个小版本的DALL·E mini。不过,前段时间,Stability AI发布的Stable Diffusion其效果明显好于现有模型,且免费开放使用,让大家都开心了一把。不过原有模型是Torch实现的,而现在,基于Tensorflow/Keras实现的Stable Diffusion已经开源。

相比较原有的模型,该模型的运行速度要快4倍(基于8GB的M1 MacBook Air的笔记本测试)。

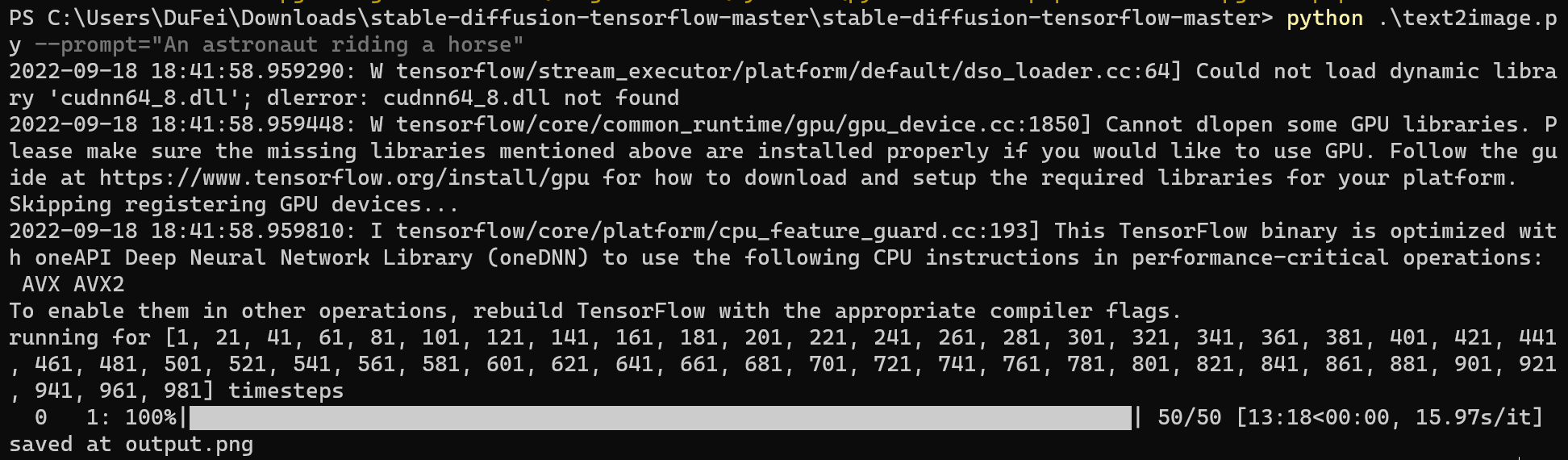

下图是测试的结果:

输入: A epic and beautiful rococo werewolf drinking coffee, in a burning coffee shop. ultra-detailed. anime, pixiv, uhd 8k cryengine, octane render

输出:

这个版本的Stable Diffusion是由Meta的研究人员 Divam Gupta开发,其主要的特点: