SlimPajama:CerebrasAI开源最新可商用的高质量大语言模型训练数据集,含6270亿个tokens!

大语言模型训练的一个重要前提就是高质量超大规模的数据集。为了促进开源大模型生态的发展,Cerebras新发布了一个超大规模的文本数据集SlimPajama,SlimPajama可以作为大语言模型的训练数据集,具有很高的质量。

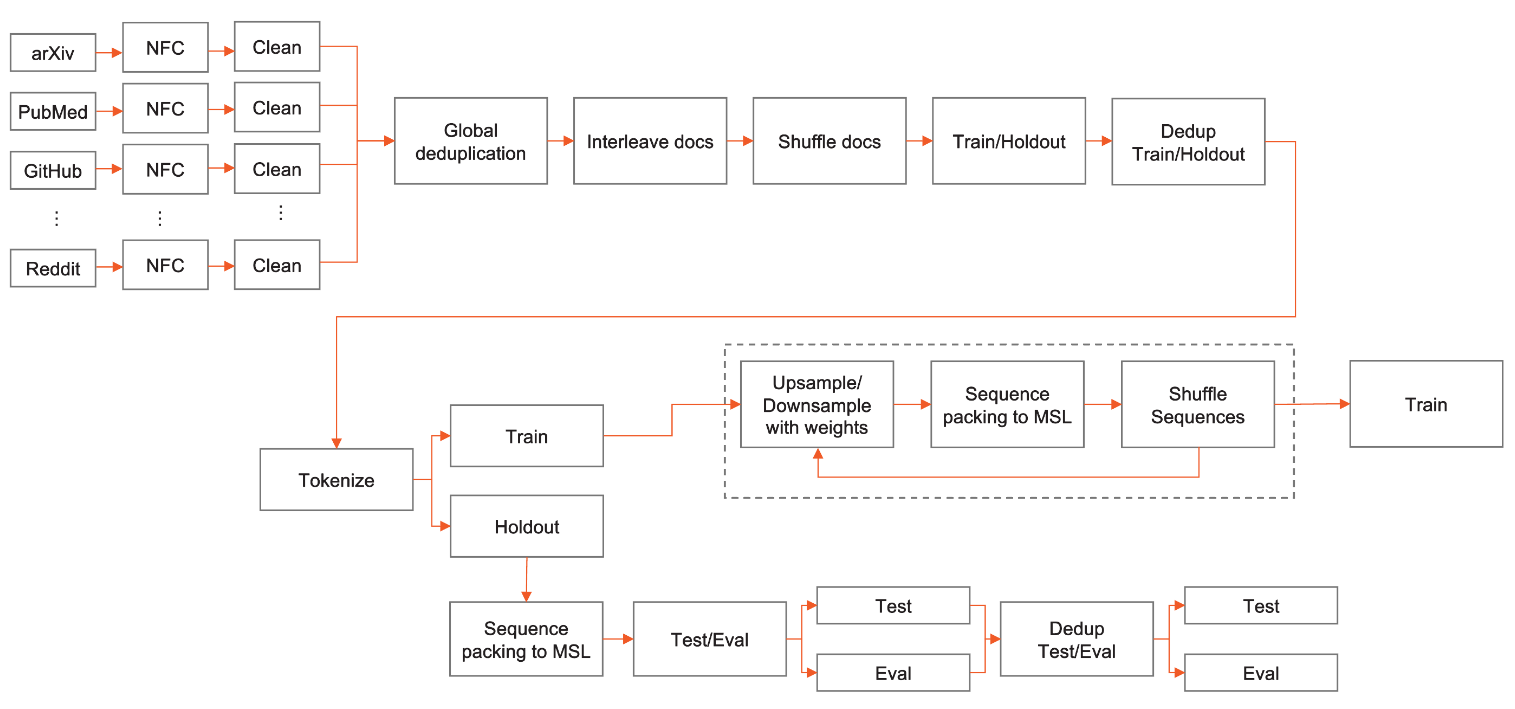

除了SlimPajama数据集外,Cerebras此次还开源了处理原始数据的脚本,包括去重和预处理部分。官方认为,这是目前第一个开源处理万亿规模数据集的清理和MinHashLSH去重工具。

Cerebras为什么要发布SlimPajama数据集

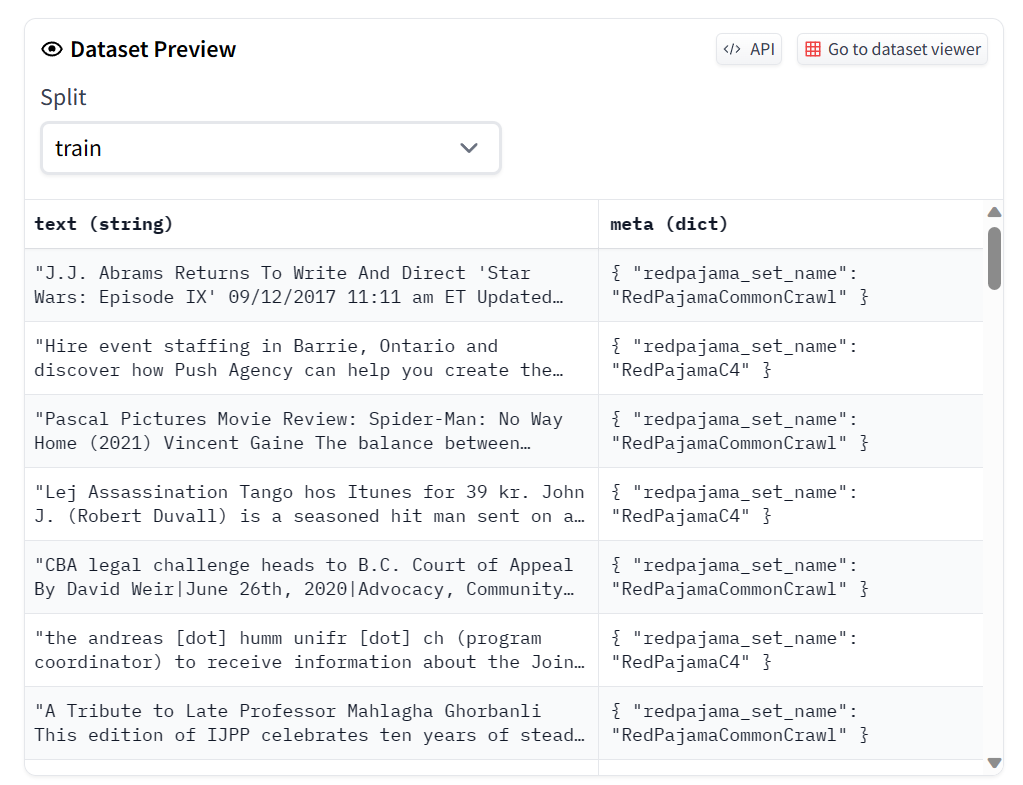

SlimPajama数据集来自RedPajama的清洗和去重结果。

MetaAI发布的LLaMA模型中详细描述了他们是如何收集数据集的。而LLaMA的效果也证明了在高质量数据集上训练的重要性。尽管LLaMA开源了他们的预训练结果(不可商用),也在论文中详细描述了LLaMA如何训练。但是,LLaMA的训练数据集却从未公开。为此,TOGETHER联合多家公司发起了RedPajama项目。

RedPajama是一个开源大模型项目,由TOGETHER联合多家公司发起。目前包括一个开源的数据集,有1.2万亿tokens,严格按照LLaMA模型论文中的方法收集。