过去几年,大语言模型的训练路线相对稳定:更大的模型、更长的预训练、更精细的指令微调与人类反馈对齐。这套方法在很长一段时间内持续奏效,也塑造了人们对“模型能力如何提升”的基本认知。

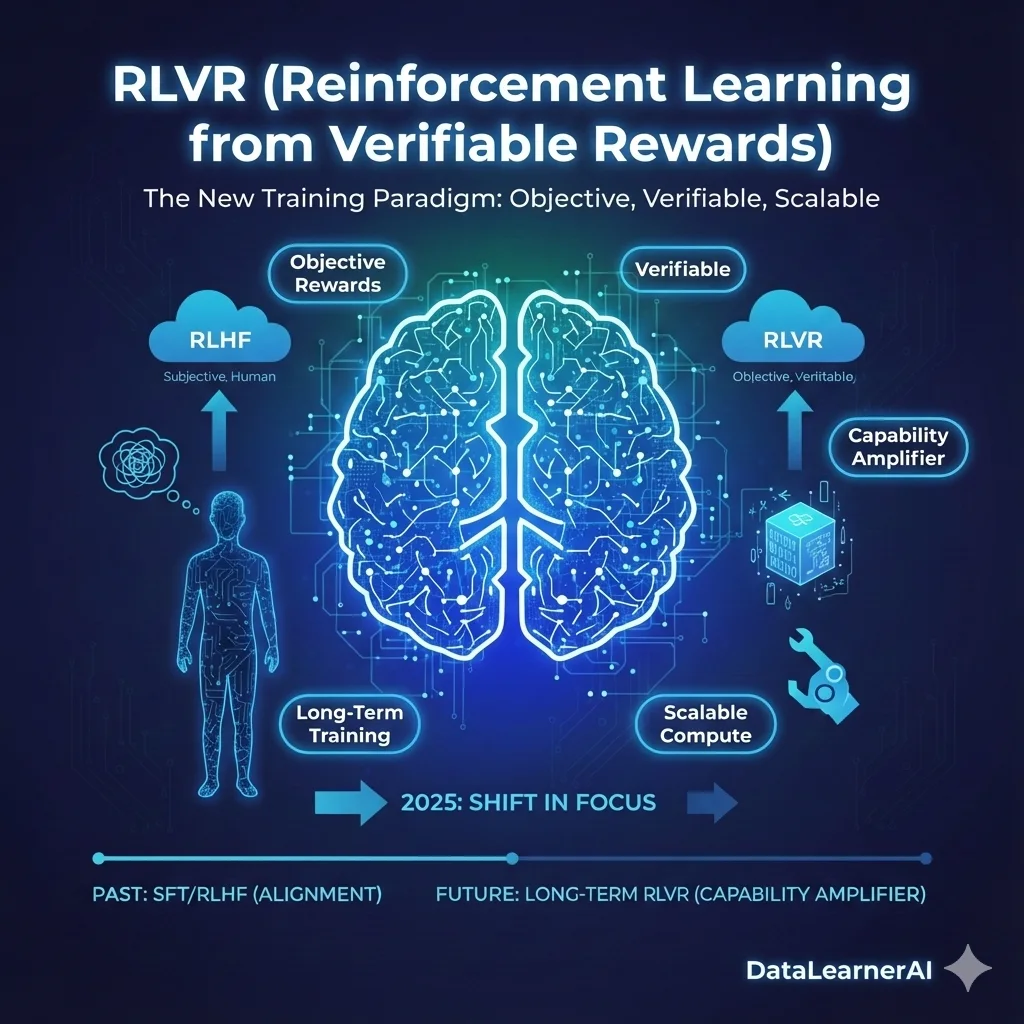

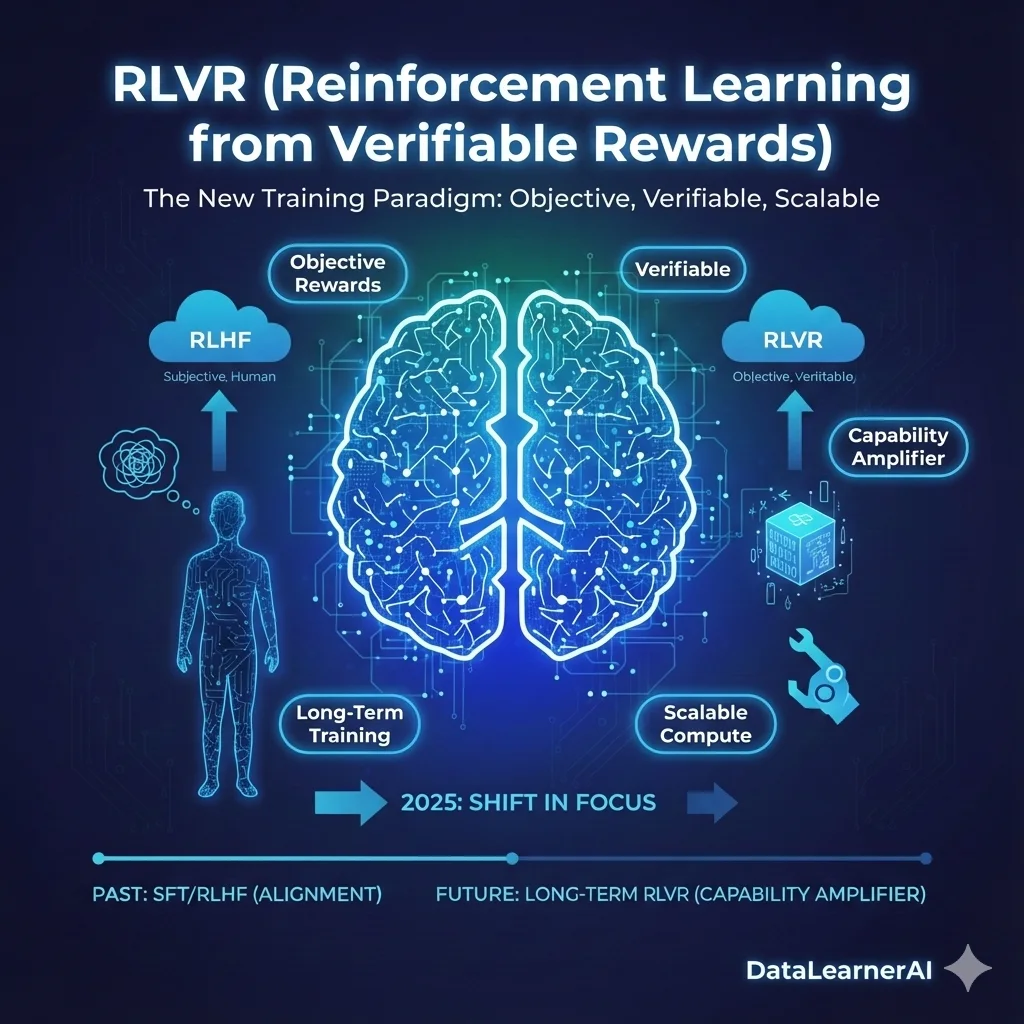

但在 2025 年前后,一种并不算新的训练思路突然被推到台前,并开始占据越来越多的计算资源与工程关注度,这就是基于可验证奖励的强化学习(Reinforcement Learning from Verifiable Rewards,RLVR)。

它并非一项全新的算法发明,却在这一阶段显现出与以往完全不同的战略地位。这篇文章试图从训练逻辑与工程现实的角度,解释这一变化是如何发生的。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

一、RLVR 是什么:它仍然是强化学习,但奖励不再来自人类

-

大规模无监督数据预训练(Pretraining):这个过程通常需要几个月的时间,使用成千上万的显卡,通过数千亿甚至数万亿个tokens的训练数据,让大模型学习世界上通用的知识。

-

有监督微调(Supervised Fine-Tuning, SFT):此步骤使用标注过的有监督数据进行微调,帮助模型更好地理解人类指令,从而提升其对特定任务的表现。

-

基于人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF):最后,模型通过基于人类反馈的强化学习来优化其行为,使得模型能够更好地对齐人类的价值观,理解哪些答案是“更好”的。

RLVR与RLHF的区别

2025年流行的这个RLVR(基于可验证奖励的强化学习,英文全称Reinforcement Learning from Verifiable Rewards,RLVR),从算法分类上来看,依然属于强化学习范畴。与人们熟悉的RLHF相比,二者的核心差异不在于是否使用强化学习,而在于奖励信号的来源。

-

在RLHF中:模型的输出需要通过人类或由人类训练的奖励模型进行评估,奖励的本质是主观的,根据“哪个回答更好、更符合人类的偏好”来打分。

-

在RLVR中:奖励由自动化系统生成,无需人工参与。奖励的标准来自于客观条件,例如:

- 数学题是否算对

- 代码是否通过测试

- 推理结果是否符合设定的约束

这些标准是已经设定好的规则,可以通过程序自动判断,不需要人类的干预。因此,RLVR的奖励信号是客观且透明的,它依据程序化的检查机制来决定模型输出的好坏。

从这个角度看,RLVR并不是“更聪明的强化学习”,而是更客观的强化学习。因为奖励的判断完全基于客观标准,而这些标准是事先设定好的,能够自动化验证模型输出是否符合要求,而不依赖人工判断。

二、RLVR 与 RLHF 的根本差异:不是效果,而是“能跑多久”

如果只看短期效果,RLVR 与 RLHF 的区别并不总是显著。真正拉开差距的,是它们在可持续优化能力上的不同。

RLHF 的奖励信号来自人类偏好,这带来几个天然限制:

- 成本高,无法无限规模化

- 奖励信号容易被“迎合”

- 长时间训练容易出现退化或模式坍塌

因此在工程实践中,RLHF 往往是一个相对短暂的阶段,用于对齐风格、减少风险,而不是长期能力演化的主引擎。

RLVR 则不同。由于奖励是自动、客观、可重复计算的,它具备一个关键属性:可以在同一任务分布上持续运行强化学习,而不会迅速耗尽信号质量。正是这一点,使 RLVR 在计算层面第一次具备了“可以吃掉大量算力”的现实可能性。

三、一个自然的问题:既然RLVR如此直接,为什么以前没成为主流?

回顾今天,RLVR似乎是一条“显而易见”的路径,但在早期,它并未成为大模型训练的核心。这并非偶然,背后有多方面的原因。

首先,早期模型能力不足。在大模型尚未稳定掌握基础语言理解时,强化学习往往容易放大噪声,难以形成可靠的策略。RLVR对底层模型能力的要求远高于直观想象,只有在模型具备一定的理解和推理能力时,自动化奖励才会发挥应有作用。

简单解释一下,这里所谓的**“放大噪声”**的原因在于:当模型的基础能力不足时,强化学习的反馈机制可能会根据错误的奖励信号调整模型行为,而这种反馈循环可能会使错误决策被放大,导致学习过程中的不稳定和不可靠的策略。因此,在RLVR等方法中,模型必须有足够稳定和可靠的能力,才能有效地使用自动化奖励生成系统,避免这种负面循环的产生。

其次,可验证任务的范围有限。长期以来,行业关注的核心问题是提升通用语言能力和知识覆盖,而这些领域的任务往往难以设计出清晰、无歧义的自动化奖励。因此,RLVR的应用范围在早期相对受限。

第三,主流共识长期集中在“规模即能力”。在过去,扩大模型的参数规模和增加训练数据量被认为是提升模型能力的最直接途径,这条路径的效果更为显著。而相比之下,强化学习的性价比并不那么明确,尤其是在人类反馈作为奖励信号时,往往能带来更可控的优化效果。

最后,工程与安全的考虑。RLHF更容易解释,并且符合“对齐优先”的产品目标,这使得它在生产系统中更受青睐,成为主流的方法。而RLVR虽然在理论上有潜力,但在工程实践中则需要更高的可靠性和可验证性,涉及的技术实现难度较大。

因此,RLVR并非被忽视的技术,而是在当时的条件下,缺乏成为主流训练阶段的现实基础。

四、为什么 2025 年,RLVR 突然“成立”了?

一方面,大模型的底座能力已经足够强,能够在强化学习中稳定形成中间策略,而不是随机试探。

另一方面,数学、代码等可验证任务被证明不仅提升局部技能,还会迁移性地改善复杂问题处理能力。

在这一背景下,一些实验性结果开始显现出超出预期的现象。例如,来自 DeepSeek 的开源模型展示了这样一种情况:

在没有人类提供“推理示范”的前提下,模型在可验证奖励驱动下,自发形成了问题拆解、回溯与多路径尝试等复杂行为。

这些结果在模型与代码公开之后被更多团队复现,也促使行业重新评估 RLVR 的潜力。从工程角度看,它第一次展现出一种新的可能性:在不显著扩大模型规模的前提下,通过更长时间的强化学习持续提升能力。

五、RLVR 带来的另一个直观变化:为什么模型“看起来更会推理了”?

你有没有注意到,2025 年的大模型开始“看起来像是在推理”?

在过去的几年里,我们已经习惯了大模型在各种任务上的出色表现——无论是生成文本、解决数学问题,还是编写代码。但有一个现象变得尤为引人注意:这些模型开始展示出一种更像人类思考的行为,它们似乎不仅仅是在模仿,而是在“推理”。

那么,这种“推理感”从何而来?我们为什么会觉得大模型开始具备了思维的能力?此前的SFT后模型展示出来的推理和RLVR有什么区别呢?这里我们稍微简单解释一下。

SFT 阶段的推理:是模仿,不是自主

首先,SFT(监督微调)阶段的模型训练方式帮助我们理解了这一现象的背景。在 SFT 中,模型的推理过程本质上是模仿:

- 模型学习的是人类给定的标注数据中的推理轨迹。

- 它并不真正“理解”推理的过程,而是依靠这些数据“记忆”推理路径,并模仿这些路径进行任务解答。

这种模仿并不涉及自主探索。模型只是学习如何生成“合适的回答”——这并不等同于“推理”。

RLVR:让模型自主生成推理路径

那么,RLVR(Reinforcement Learning from Verifiable Rewards)是什么让这种情况发生了根本性的变化?核心是RLVR 不像 SFT 那样依赖于人工设计的数据集,它更依赖奖励信号的自动生成。RLVR的奖励并不是来自人类偏好的反馈,而是通过对可验证结果的判断(比如数学是否算对、代码是否通过测试等)来驱动模型学习。

那么问题来了:如果没有“推理示范”,模型如何“学会”推理呢?这就要提到奖励信号带来的效果。

RLVR 的作用:从优化到推理

在 RLVR 的训练机制下,模型并没有被人工提供推理路径,而是通过持续的任务奖励来自我发现推理的必要性和方法。当模型在解决问题时,无法立刻给出正确答案时,它会:

- 自动分解问题,逐步化繁为简

- 通过中间计算来验证每个步骤

- 在失败后回溯并寻找新的解决方案

这些自发的行为,让人类观察者看到的结果就是“推理过程”——尽管它并非由人类提供的示范,而是模型自己在强化学习的过程中,逐步优化出的问题解决路径。

为什么 RLVR 会带来这种推理感?

RLVR 之所以能够带来“推理感”,是因为它不仅仅是让模型“生成”一个答案,而是让模型学习如何一步步地进行问题解决,类似于人类的思维过程。通过不断回溯和修正,模型能逐渐学会长时间跨度的推理,这种推理不依赖于外部推理示范,而是通过奖励反馈自己发现合适的解决路径。因此,当我们说“模型开始推理”时,我们指的是它在 RLVR 训练中自发地形成了中间步骤和推理链,这些步骤和链条不依赖于人工干预,而是基于可验证奖励机制自主学习出来的。

六、一个更深层的变化:训练重心开始迁移,长时间RLVR也带来了推理的scale law

从整体训练结构看,2025 年前后的变化并不是“多了一步”,而是重心发生了迁移。

预训练(能力来源) + SFT / RLHF(对齐与修饰)

预训练(能力底座) + SFT / RLHF(对齐与修饰) + 长时间 RLVR(能力放大器)

在这种结构下,测试时计算量(thinking time)也成为新的调节维度,使能力不再只由参数规模决定。为什么这样说?

在 RLVR 模型中,能力的增长不再仅仅依赖于训练阶段的参数规模,而是更加强调推理过程的深度和推理时计算的时间。RLVR 通过长期的强化学习优化了模型的推理能力,使得模型在进行复杂推理时需要更多的计算时间,从而提升其整体表现。

这种变化导致了一个全新的 scale law(规模规律),在 RLVR 训练下,模型的能力不仅依赖于训练数据量和模型规模,还与 测试时的计算资源直接挂钩。推理能力的增强不再仅仅是通过扩大模型的规模或增加训练数据来实现的,而是通过增加模型推理时的计算量(thinking time)来进一步扩展。

2025 年,随着 RLVR 的广泛应用,测试时计算量开始成为一个新的关键调节参数。推理过程中的计算量不仅影响到模型的响应速度,还直接决定了模型是否能够在更复杂的任务中发挥优势,特别是在长链路推理、复杂数学问题或需要多步推理的任务上。

- 如果模型能够进行更多的计算步骤,它的推理能力就会进一步增强。

- RLVR 模型通过长时间的推理优化,形成了更加复杂的推理策略,这就需要更多的计算资源。

从这一角度来看,推理能力和模型的计算资源需求之间形成了一个 scale law,这个规律说明了推理所需计算量的非线性增长。也就是为什么各家模型的参数都有了reasoning effort或者是low、high模式了。

结语

RLVR 并不是对既有范式的否定,而是一次重心调整。它让行业意识到:在模型规模逐渐放缓的阶段,训练方式本身仍然存在尚未被充分挖掘的能力空间。从这个角度看,2025 年的变化并不只是某一种技术的流行,而是一次关于“能力从何而来”的重新认识。

本文是基于当前发展情况做的洞察和讨论,也许其中也有不对的地方,欢迎大家加入微信群中讨论。

突破英特尔CPU+英伟达GPU的大模型训练硬件组合:苹果与AMD都有新进展!