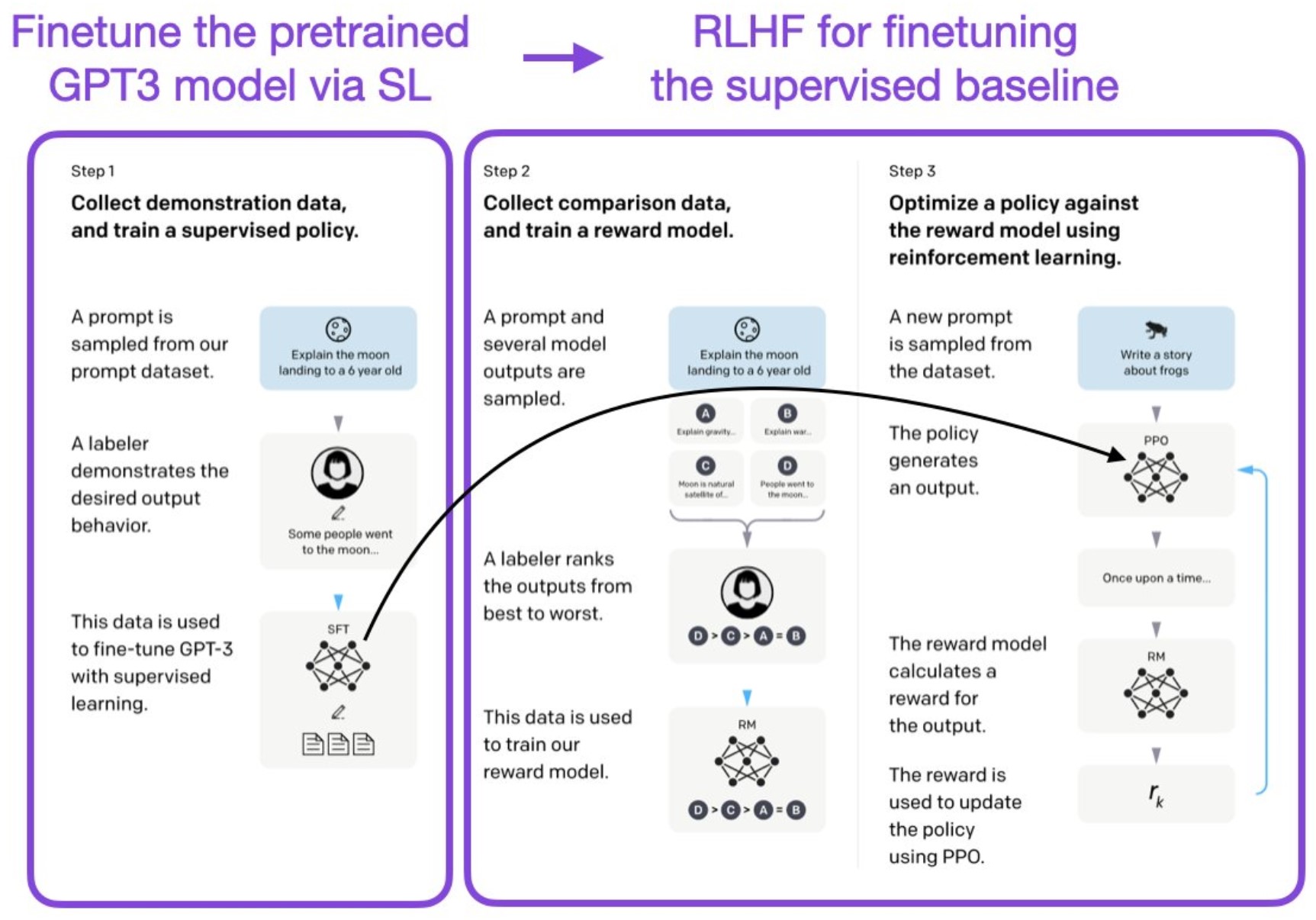

为什么最新的大语言模型(如ChatGPT)都使用强化学习来做微调(finetuning)?

最近,随着ChatGPT(ChatGPT模型卡:https://www.datalearner.com/ai-resources/pretrained-models/chat-gpt )的火爆,大语言模型(Large language model)再次被大家所关注。当年BERT(BERT模型卡:https://www.datalearner.com/ai-resources/pretrained-models/BERT )横空出世的时候,基于BERT做微调风靡全球。但是,最新的大语言模型如ChatGPT都使用强化学习(Reinforcement Learning, RL)来做微调(finetuning),而不是用之前大家所知道的有监督的学习(supervised learning,SL)。这是为什么呢?

著名AI研究员Sebastian Raschka解释了这样一个很重要的转变。大约有5个原因促使了这一转变。

原因1:预测response比预测排序更重要

在有监督的学习中,我们通常都将真实标签和模型输出之间的最小化作为目标。对某些提示(certain prompts)来说,标签(Labels)实际上是对response的排名分数。因此,使用常规的有监督学习对模型进行微调实际上是让模型来预测排序,而不是让模型来预测response。