互联网女皇Mary Meeker最新报告:当前以大模型为核心的AI是人类历史上前所未有的机会

在人工智能(AI)迅猛发展的当下,BOND资本公司于2025年5月30日发布了《Trends – Artificial Intelligence》报告,这份报告有340页的PPT,包含了全球AI趋势的深度洞察和分析。

BOND资本是一家总部位于旧金山的风险投资公司,由被誉为“互联网女皇”的玛丽·梅克(Mary Meeker)创立。梅克女士曾是华尔街著名的证券分析师,以其对互联网和新兴技术趋势的深刻洞察而闻名。她自1995年起每年发布《互联网趋势报告》,深入分析互联网、消费者行为和技术演变等方面的趋势,影响了众多投资者和企业的战略决策。

过去几年,AI的发展速度超越了历史上任何一次技术革新

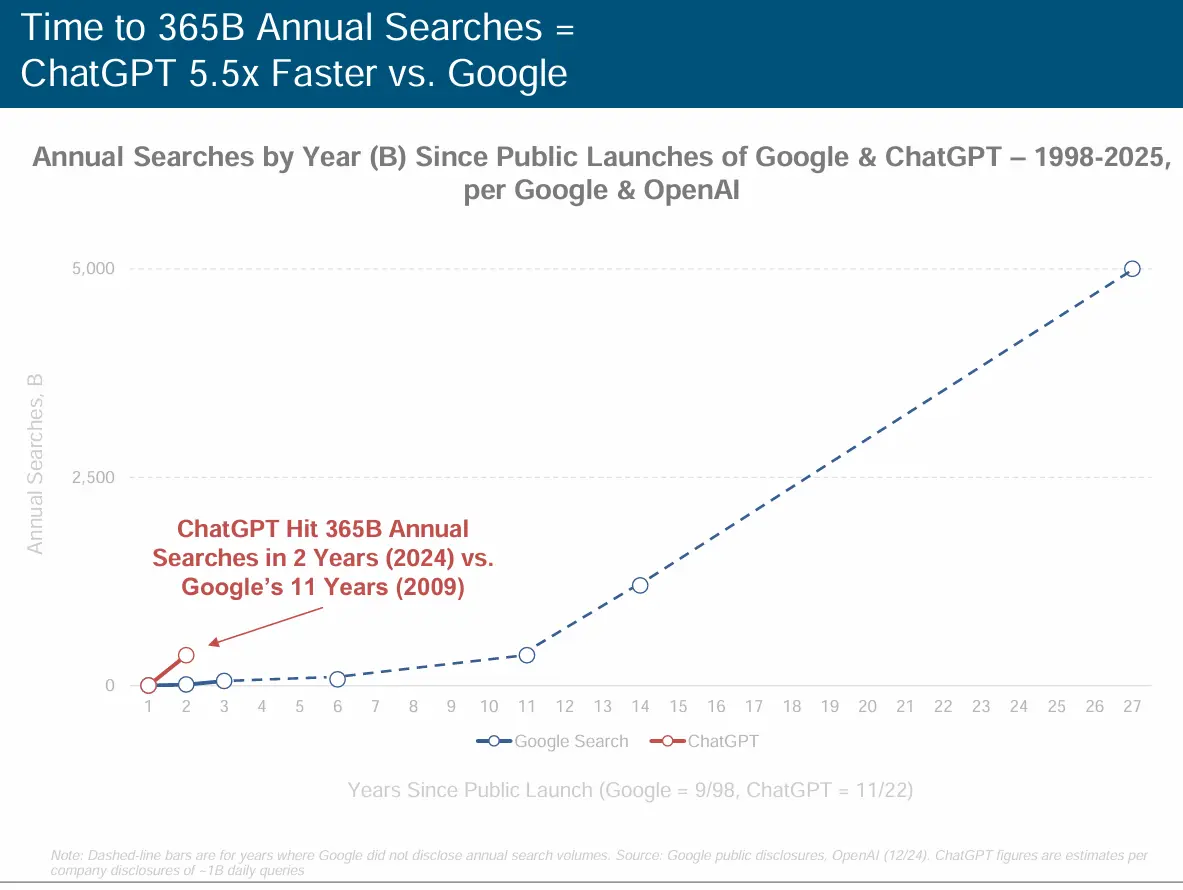

过去几年,人工智能(AI)的发展速度达到了令人震惊的程度,其变革的广度和深度甚至超越了历史上任何一次技术革新。为了直观理解这一速度,我们对比了新一代AI应用与传统互联网巨头的成长轨迹。以年度搜索量这一核心指标为例,ChatGPT达到3650亿年搜索量的门槛仅用了约2年时间,而互联网搜索巨头谷歌则花费了11年,前者速度是后者的5.5倍 (数据来源:Google公开披露, OpenAI 12/24, ChatGPT数据基于约10亿日均查询估算)。这一对比鲜明地揭示了AI技术在市场渗透和用户接纳方面的空前效率。

ChatGPT的成功不仅仅体现在搜索类交互上,其用户增长、付费订阅转化和营收增长同样迅猛,为科技平台树立了新的标杆。

- 用户规模:自2022年10月公开发布以来,ChatGPT的周活跃用户数从0迅速攀升,预计到2025年4月将达到约8亿。

- 付费订阅:同期,付费订阅用户数预计将从0增长至2025年4月的约2000万。

- 营收表现:商业化进展同样迅速,预计到2024年,ChatGPT的年营收将达到约38亿美元,而其在2022年营收尚为0。

这种“现象级”的增长表明,AI驱动的应用正以前所未有的速度融入大众市场并实现商业价值。

AI发展的核心驱动力是算力、训练数据以及模型的指数级飞跃

支撑AI应用层爆发的,是底层技术要素的持续指数级增长。主要包括算力、训练数据、模型效率的指数级增长,也包括了成本的快速下降,根据Meeker的报告,过去几年,算力和训练数据的年均增长都是150%以上。接下来我们具体分析一下。

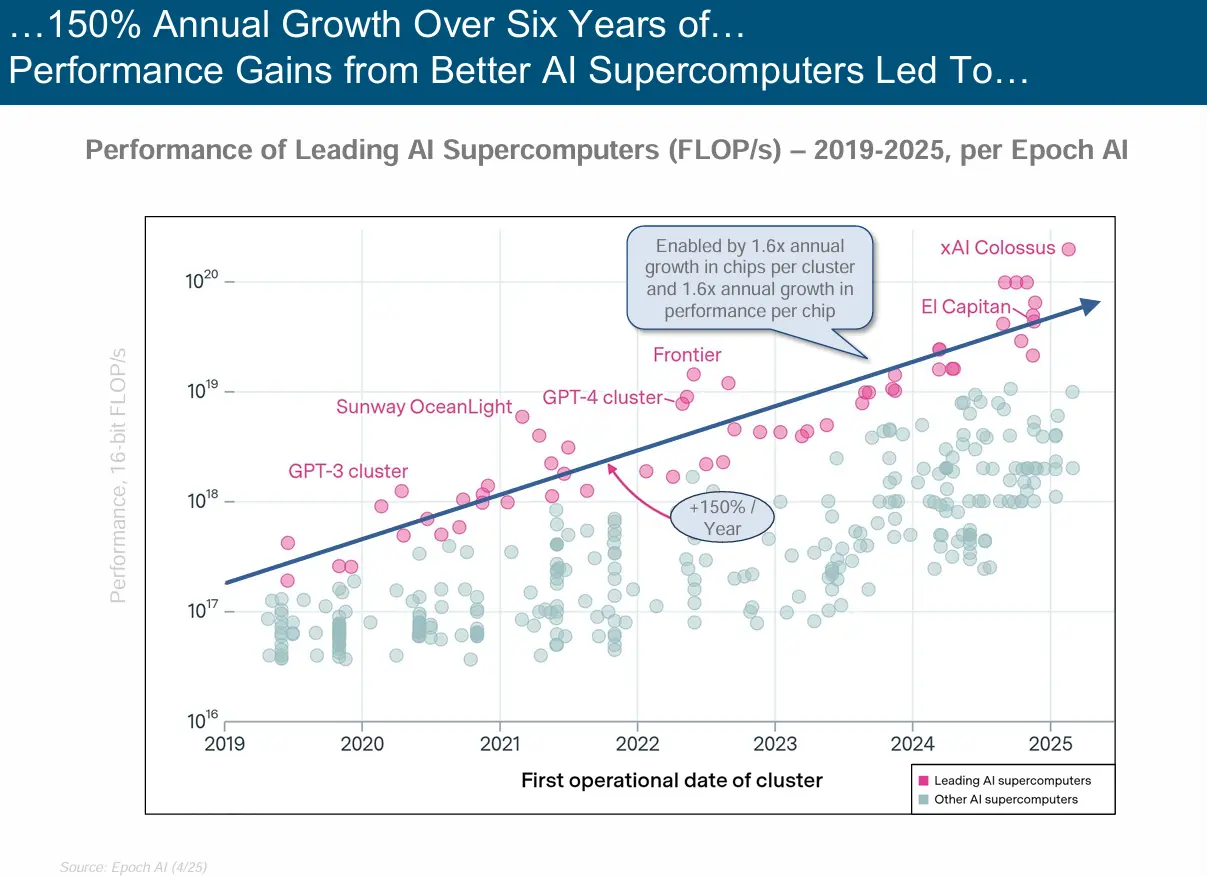

AI超级计算机性能的飙升,大模型训练算力指数级增长

领先AI超级计算机的16位浮点算力(FLOP/s)在2019-2025年的六年间实现了约150%的累计增长(提升至原始值的2.5倍)。过去几年,训练大模型的核心基础设施是GPU集群:2019年GPT-3训练集群算力为 $10^{18}$ FLOP/s,而2025年xAI的XAI Colossus集群算力已接近$10^{20}$ FLOP/s,绝对值跃升两个数量级!

这一增长由两大技术趋势驱动:

- 单个集群的芯片数量以年均1.6倍(≈60%)的速度扩张;

- 单芯片性能以年均1.6倍(≈60%)的速度提升。

两者的叠加效应推动整体算力年均增长率超过60%。

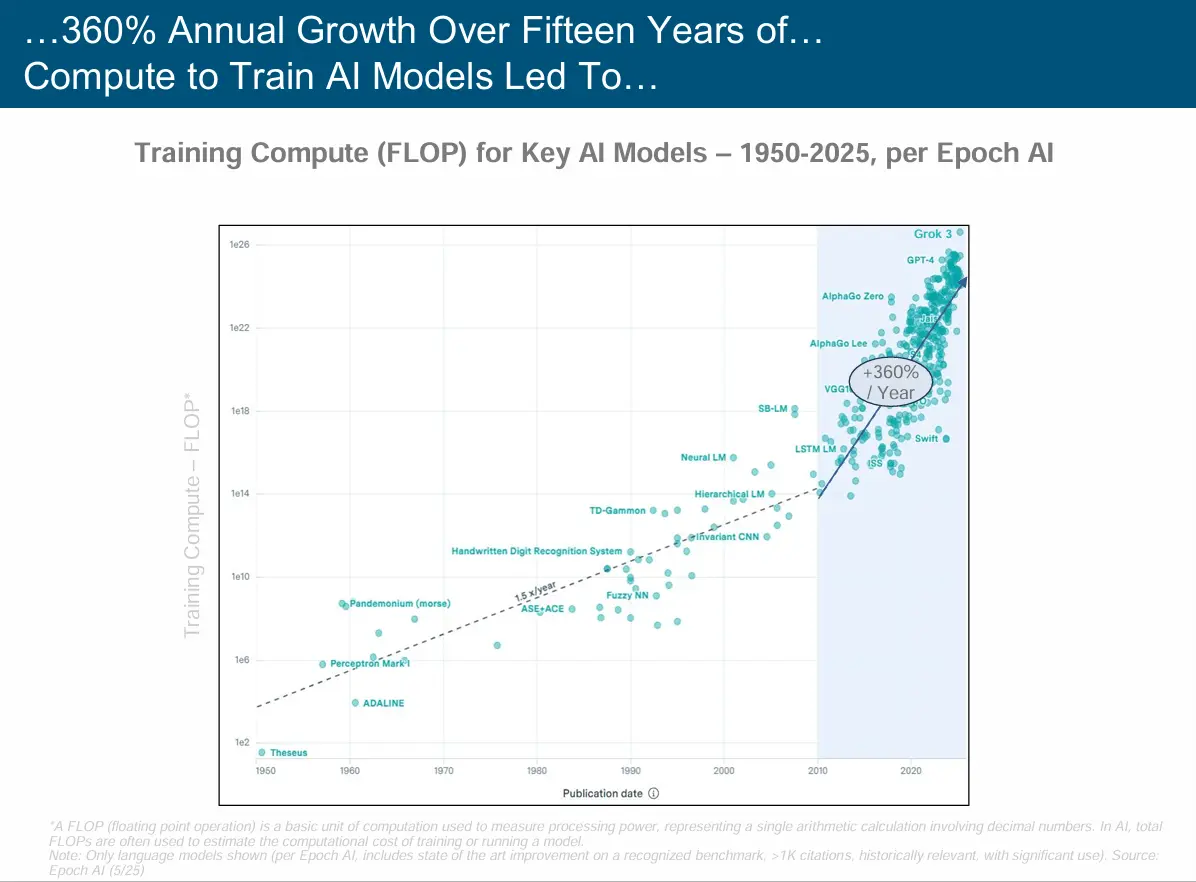

与此同时,从AI模型训练所需的总计算量角度来看,增长趋势更为惊人。如图所示,AI模型训练的计算需求在过去15年中保持了年均360%的指数级增长。从2010年的早期神经网络模型到2025年的最新大模型,训练计算量已经跨越了近10个数量级:

2012年AlexNet等早期深度学习模型的训练计算量约为$10^{18}$ FLOP 2017年Transformer架构的出现标志着一个转折点 2019年GPT-2将训练计算量推升至$10^{21}$ FLOP级别 2020-2022年间,GPT-3、GPT-4等模型将这一数字进一步推高到$10^{23}-10^{24}$ FLOP 预计2025年的前沿模型训练将达到$10^{26}$ FLOP的惊人规模

这意味着每隔约2-3年,AI模型的训练计算需求就会增长100倍。相比之下,虽然GPU集群的算力在同期实现了100倍的增长,但仍然需要通过延长训练时间、优化算法效率等方式来满足模型规模爆炸式增长的计算需求。这种计算需求与算力供给之间的"剪刀差"正在成为AI发展的关键瓶颈之一。

训练数据集规模的持续扩大

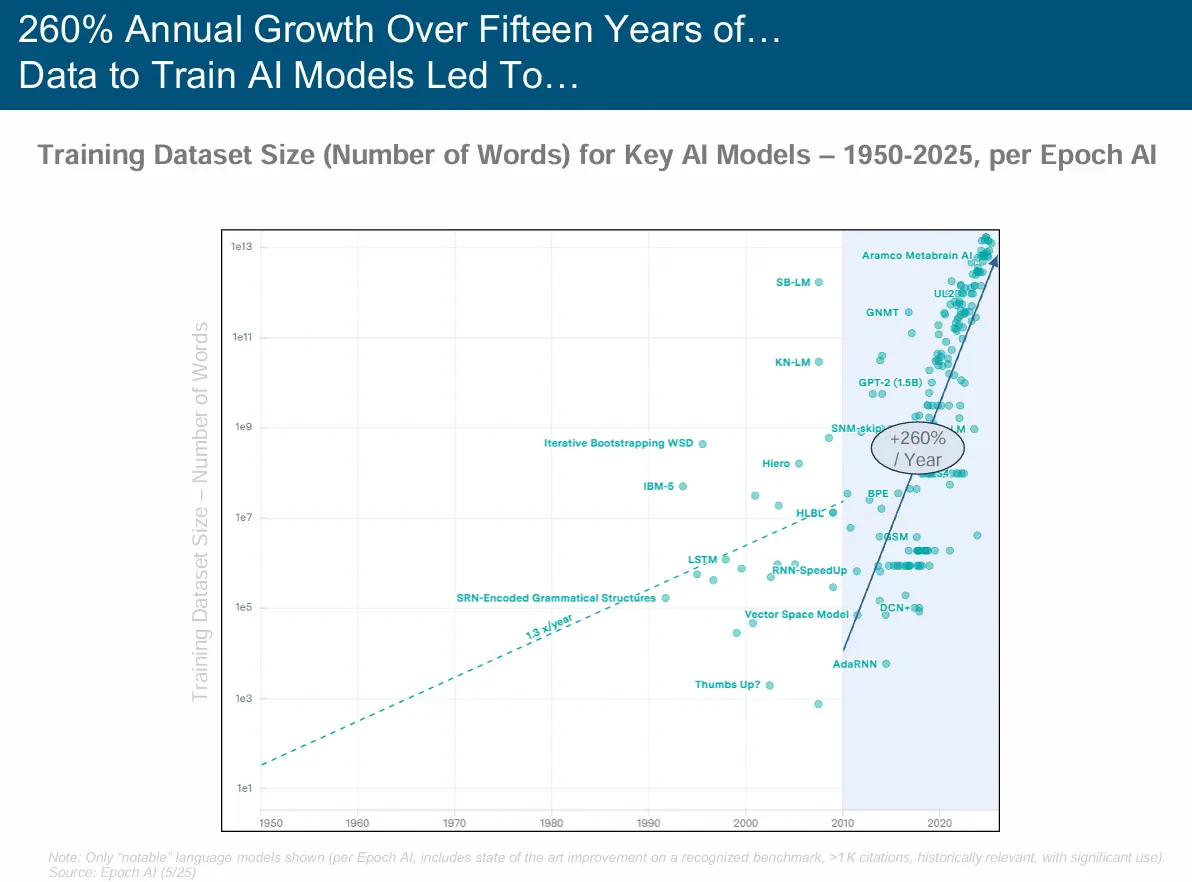

与算力并行,训练AI模型所用的数据量(以词数衡量)同样经历了年均约260%的增长(近十余年趋势)。

例如,在2010年前后,先进模型的训练数据量尚在$10^8$(一亿)单词级别,而到2025年,顶尖模型如Aramco MetaBrain AI已使用接近$10^{13}$(十万亿)单词的数据集,绝对值跃升了惊人的五个数量级!

强大AI模型的涌现: 新发布的大规模AI模型(训练算力超过10^23 FLOP*)数量正以年均167%的速度增长(近四年数据)。 预计到2024年,年新增大型AI模型数量将达到约100个,远超2017年的2个。这包括来自xAI、Anthropic、Meta、NVIDIA、Mistral等众多机构的贡献。(数据来源:Epoch AI, 截至4/25)

*注:“大规模AI模型”通常指训练算力达到或超过10^23 FLOPs的模型。

AI算法的改进使得“有效算力”大幅提升,即用更少的原始算力达成同等甚至更好的性能。 算法进步带来的有效算力年均增长率高达约200%。 以2014年LSTM为基准1,到2022年的Chinchilla模型,仅算法进步就带来了约220万倍的有效算力提升。(数据来源:Epoch AI, 截至3/24)

训练AI模型的算力投入激增: 用于训练顶尖AI模型的算力(FLOPs)投入,在过去十余年间(约2010-2025年)以年均约360%的速度增长。 从1950年代的约10^2 FLOPs,到预计2024/25年Grok 3的约10^26 FLOPs,增长幅度跨越数十个数量级。(数据来源:Epoch AI, 截至5/25)

这些核心要素的协同、指数级增长,共同构成了AI技术进步的强大引擎。 三、AI的时代定位:新计算范式与经济增长新引擎 从更宏观的视角看,AI的崛起标志着一个新的计算时代的到来,并预示着对全球经济的深远影响。 AI时代——计算的新纪元: 回顾计算发展史,从大型机(~1MM+单位)到个人电脑(~300MM+单位),再到移动互联网(~4B+单位),每一次范式转换都伴随着设备/用户数量的量级提升。 “AI时代”预计将涉及数百亿量级的AI设备/单元,远超以往任何时代。其基础设施也从CPU主导,演进到大数据/云计算,再到当前以GPU为核心的AI计算。(数据来源:Morgan Stanley, 截至10/23) 技术进步驱动经济的长期复利: 纵观千年历史,技术进步(如印刷术、蒸汽机、电力、互联网)始终是全球GDP增长的核心驱动力,通过“更好、更快、更便宜”的解决方案实现复利效应。 全球GDP从1800年前的不足1万亿美元,增长到20世纪初的约5万亿美元,再到21世纪初接近100万亿美元。AI正被视为驱动下一轮全球经济增长的关键技术拐点。(数据来源:Maddison Project, Our World in Data)

根据NVIDIA公开数据,从2005年几乎为零的基数起,开发者数量在2018年达到约100万,此后出现显著加速增长。到2025年,预计将达到600万开发者,实现了**7年内增长6倍(+6x)**的显著跃升。

而谷歌Gemini生态的开发者数量增长也很快,且规模庞大。2024年5月到2025年5月间,使用Gemini构建应用的全球开发者数量已超过700万,较前一年增长5倍。

可能有用户会疑惑,为什么 Google 能在短短一年内就吸引到 700 万开发者。其实从二者的生态差异中,我们也可以猜测原因:NVIDIA 的开发者生态以 CUDA、GPU 编程和模型训练为核心,更多面向专业的 AI 研究者和工程开发者,门槛高,偏向底层。而 Google 的 Gemini 平台则定位于云端大模型服务,通过 API、插件、SDK 等形式提供给 Web、移动和办公场景开发者,入门门槛更低、接入路径更多元。