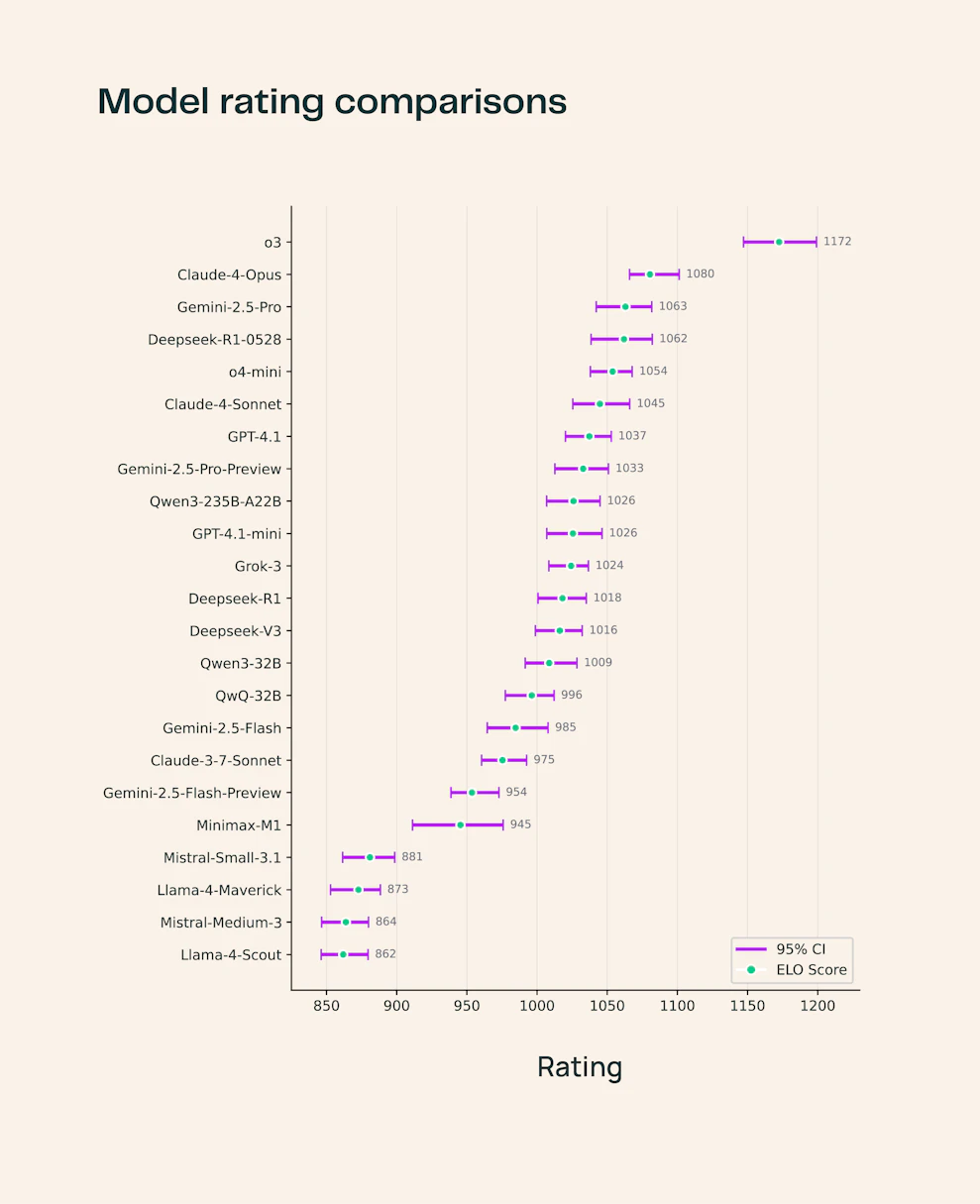

Ai2发布全新评测基准SciArena:为科学文献任务而生的大模型评测新基准,o3大幅领先所有大模型

科学文献的爆炸式增长,使得研究者日益难以全面掌握和整合新知识。基础模型(Foundation Models)正越来越多地被应用于支撑该领域的知识发现与信息整合,但如何全面、动态、细致地评测这些模型在开放性科学任务上的能力,却一直是学界未解的难题。传统通用类评测基准往往静态有限、颗粒度粗、更新滞后,难以满足科学研究领域的评测诉求。

为此,Ai2发布了一个全新评测平台——SciArena,用以帮助我们来测试大模型在科研领域的能力。这个评测系统使用了“人类众包对比评测”的理念,更结合科学问题的独特复杂性,构建了开放、透明且可迭代的模型评测生态。本文将对SciArena的核心机制、亮点创新、初步成果及其带来的未来挑战进行解读。