加载中...

加载中...

Follow DataLearner WeChat for the latest AI updates

百川智能是前搜狗创始人王小川创立的一个大模型创业公司,主要的目标是提供大模型底座来提供各种服务。虽然成立很晚(在2023年4月份成立),但是三个月后便发布开源了Baichuan系列开源模型,并上架了Baichun-53B的大模型聊天服务。这些模型受到了广泛的关注和很高的平均。而2个月后,百川智能再次开源第二代baichuan系列大模型,其能力提升明显。

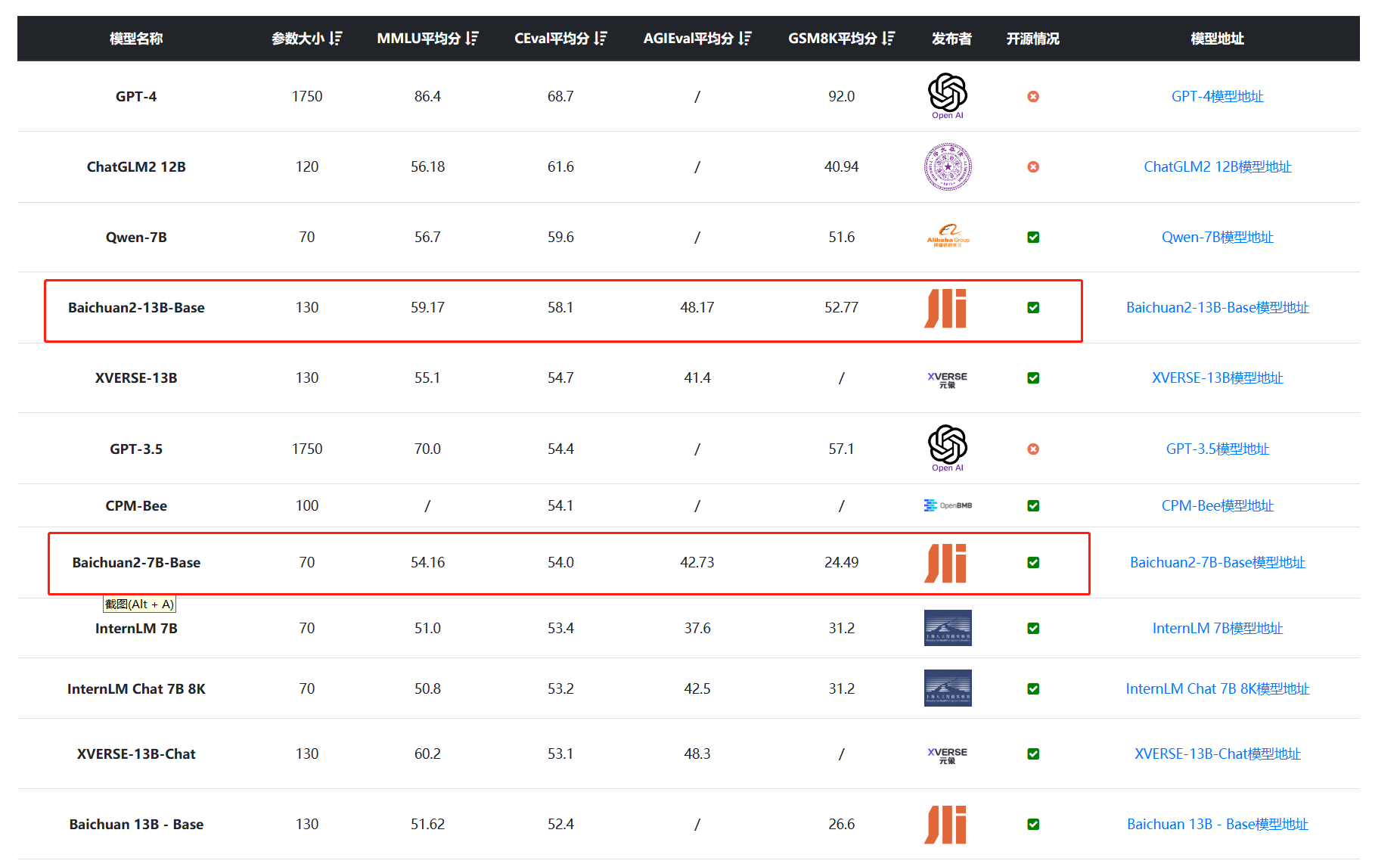

Baichuan2系列模型在各项评测中提升明显:

Baichuan2系列开源模型包含2个参数规模的版本,分别是7B和13B,但是官方开源的模型包含6个:

可以看到,官方开源的模型版本很丰富,包含基础模型Baichuan2-7B-Base/Baichuan2-13B-Base,这是在2.6万亿tokens的高质量数据集上预训练得到的。而在这2个模型基础上,Baichuan还针对对话进行对齐和微调得到了Baichuan2-7B-Chat/Baichuan2-13B-Chat两个聊天优化大模型,此外,还针对模型的显存占用问题发布了2个量化版本的模型,可以在更低的显存资源上运行。

总结一下,Baichuan2系列模型的特点如下:

本次官方还提供了一个技术报告,详细描述了Baichuan2系列模型的训练细节。

关于Baichuan 2的训练数据集和处理方式,可以概括以下几点:

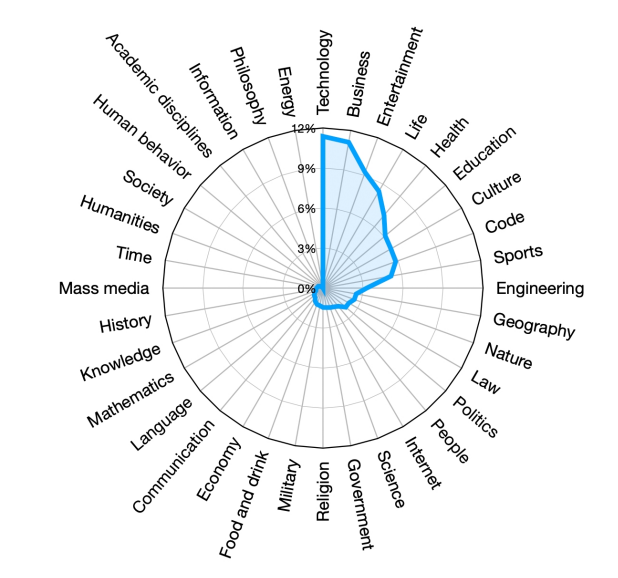

Baichuan2大模型训练数据集组成

可以看出,Baichuan 2在训练数据的选取、处理和采样方面进行了精心设计,旨在构建一个高质量、高覆盖率的多语种预训练语料库。这为模型性能的提升奠定了数据基础。

在原有的技术文档中,Baichuan解释了Baichuan2的训练过程和一些训练细节设置,我们总结如下:

以下是修正后的段落:

好的,我将详细总结论文2.2到2.7章节中Baichuan 2的模型架构和训练细节,并简单解释每一步的设计动机:

Baichuan2模型与其它模型的词汇对比:

可以看到,baichuan2的词汇表非常丰富!

模型结构 Baichuan 2采用了SwiGLU激活函数并对Transformer块的输入使用了Layer Normalization,以提高模型的稳健性和效率。具体如下:

LayerNorm

优化器

Baichuan 2使用AdamW优化器进行训练,并采用了BFloat16混合精度来提高训练的稳定性和效率。

混合精度

NormHead

Max-z loss

分布式训练

推理优化

总体来看,Baichuan 2在各个方面都进行了精心设计,这些优化策略提升了模型训练效率、稳定性以及最终性能。

Baichuan 2模型在RLHF训练过程中首先对Critic模型进行了20个training steps的预热。随后,Critic和actor模型都通过标准的PPO算法进行了更新。整个训练过程中,使用了0.5的梯度裁剪、5e-6的恒定学习率和0.1的PPO裁剪阈值。此外,设置了从0.2递减至0.005的KL惩罚系数,并进行了350次的训练迭代,最终得到了Baichuan 2-7B-Chat和Baichuan 2-13B-Chat两个模型。

以下是Baichuan 2模型的训练细节总结:

这是根据3.4小节的内容制作的训练细节表格。如果您需要更多的详细信息或其他部分的概述,请告诉我。

Baichuan 2的模型对齐方式包括两个主要组成部分:监督微调(Supervised Fine-Tuning, SFT)和基于人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF)。在监督微调阶段,使用人类标注员对从各种数据源收集的提示进行标注,每个提示都根据其是否有助于或无害于关键原则进行标记。接着,通过RLHF方法进一步改进结果。此外,还设计了一个三层分类系统,包括6个主要类别、30个次要类别和超过200个三级类别,以确保从用户的角度全面覆盖所有类型的用户需求。

Baichuan2给出了非常详细的评测结果,在传统的MMLU、C-Eval、GMS8K等的理解可以参考DataLearner大模型综合评测排行:https://www.datalearner.com/ai-models/llm-evaluation

在代码方面的评测也可以参考DataLearner大模型编程排行:https://www.datalearner.com/ai-models/llm-coding-evaluation

论文的一些具体有意思的对比我们也可以看看。

Baichuan2在医疗和法律领域的评测结果:

Baichuan2在数学和编程能力的评测结果对比:

话不多说,模型资源(包括下载地址、开源协议等)参考DataLearner模型信息卡,评测结果也可以参考DataLearner评测排名收集结果:

而Baichuan2模型所需的硬件资源(显存需求)如下:

可以看到,量化后的模型显存占用极低,Baichuan2-13B的4bit量化仅需8.6GB。

量化后的性能如下:

可以看到,区别并不明显~