AI大模型学习

原创AI博客

大模型技术资讯

大模型评测排行

大模型评测排行榜

大模型数学推理能力排行榜

大模型代码编程能力排行榜

大模型图片编辑能力排行榜

LMSys ChatBot Arena排行榜

Berkeley大模型工具使用能力排行榜

大模型综合能力排行榜(旧)

大模型编程能力排行榜(旧)

OpenLLMLeaderboard中国站

AI大模型大全

最新大模型列表

大模型部署教程

大模型对比工具

大模型评测基准

大模型评测基准

SWE Bench Verified

ARC-AGI-2

AIME 2025

FrontierMath-Tier4

MMMU

AI Agents列表

AI资源仓库

AI领域与任务

AI研究机构

AI数据集

AI开源工具

数据推荐

国产AI大模型生态全览

AI模型概览图

AI模型月报

AI基础大模型

AI工具导航

AI大模型工具导航网站

在线聊天大模型列表

BPR: Bayesian Personalized Ranking from Implicit Feedback

Vanessa He

Conference on Uncertainty in Artificial Intelligence

2009-12

3888

2017/02/27 21:06:29

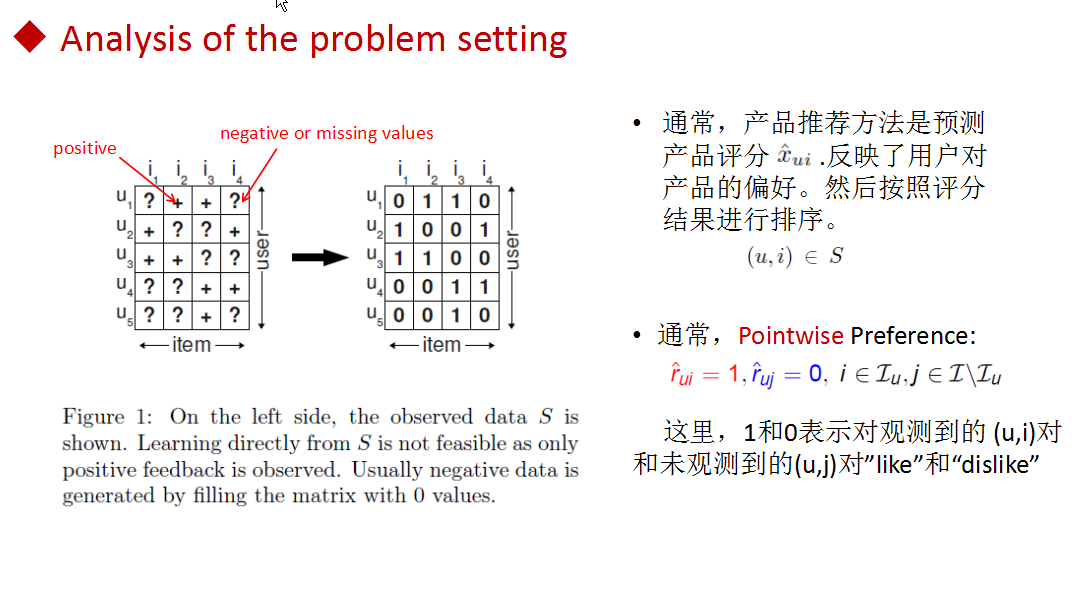

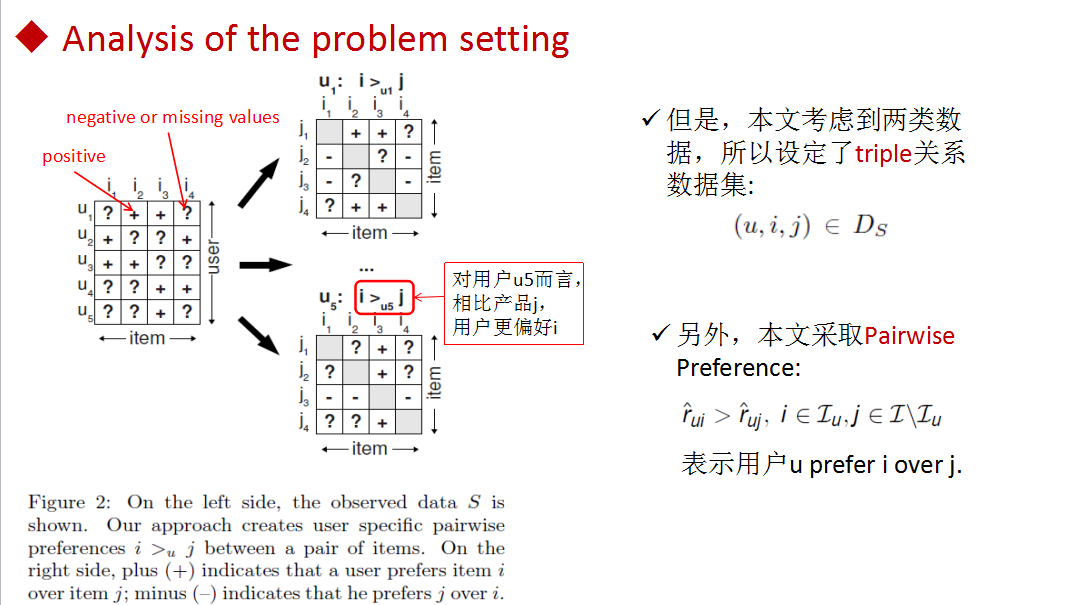

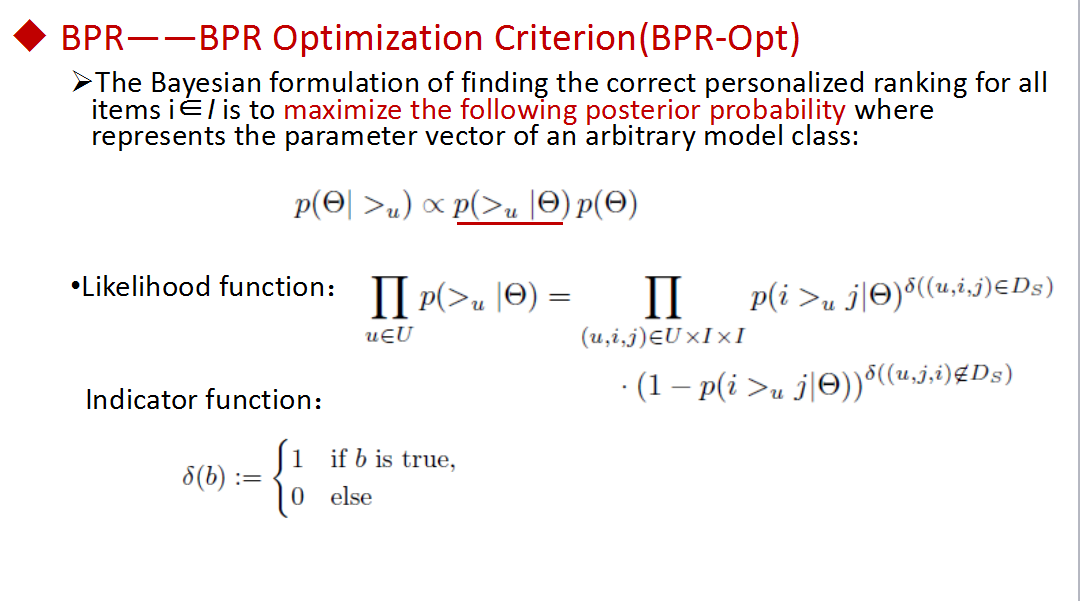

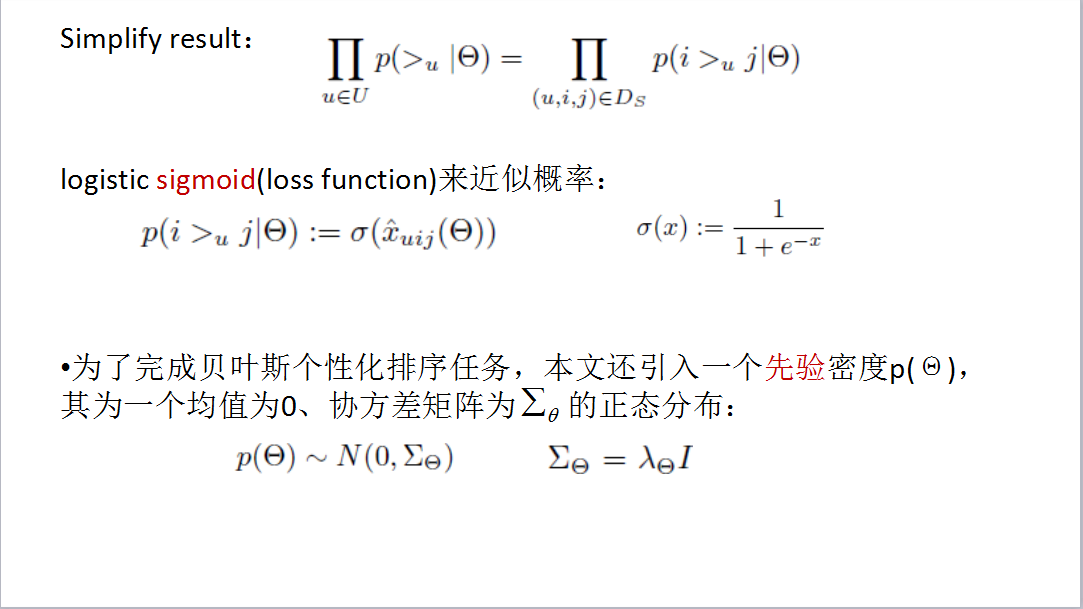

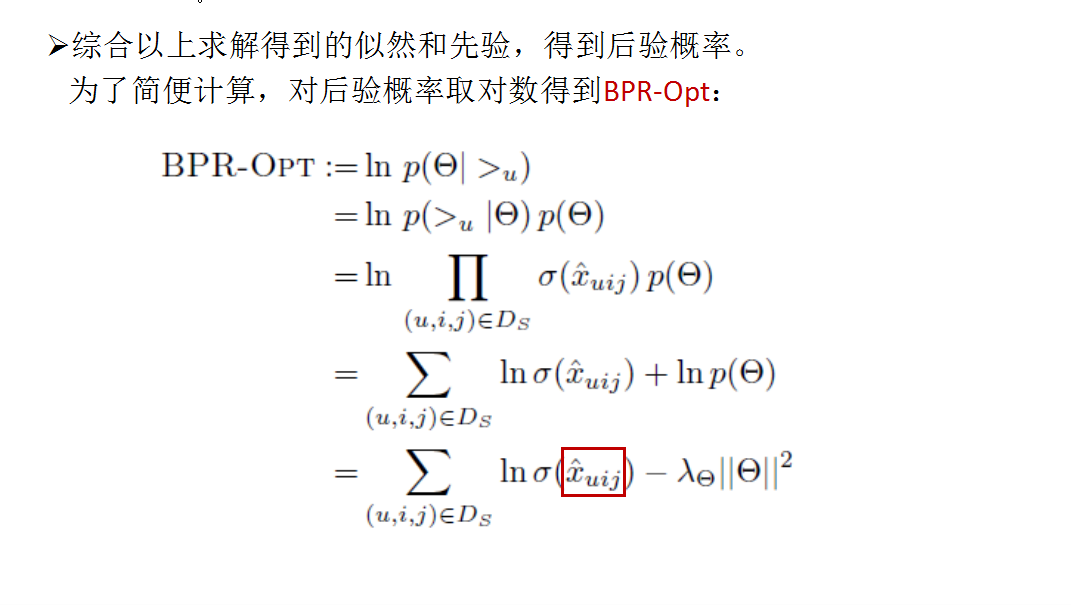

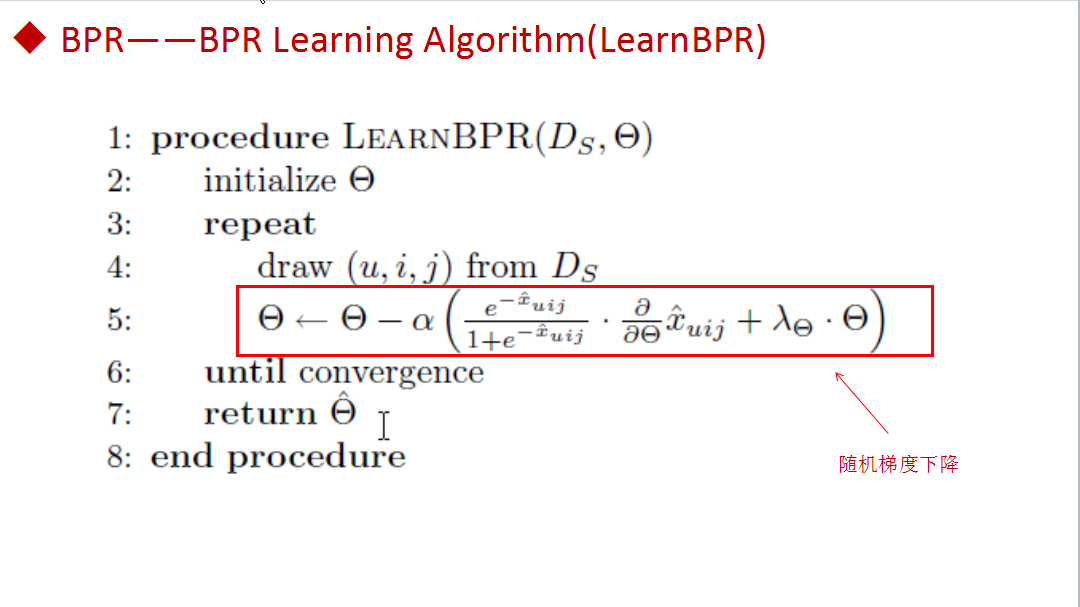

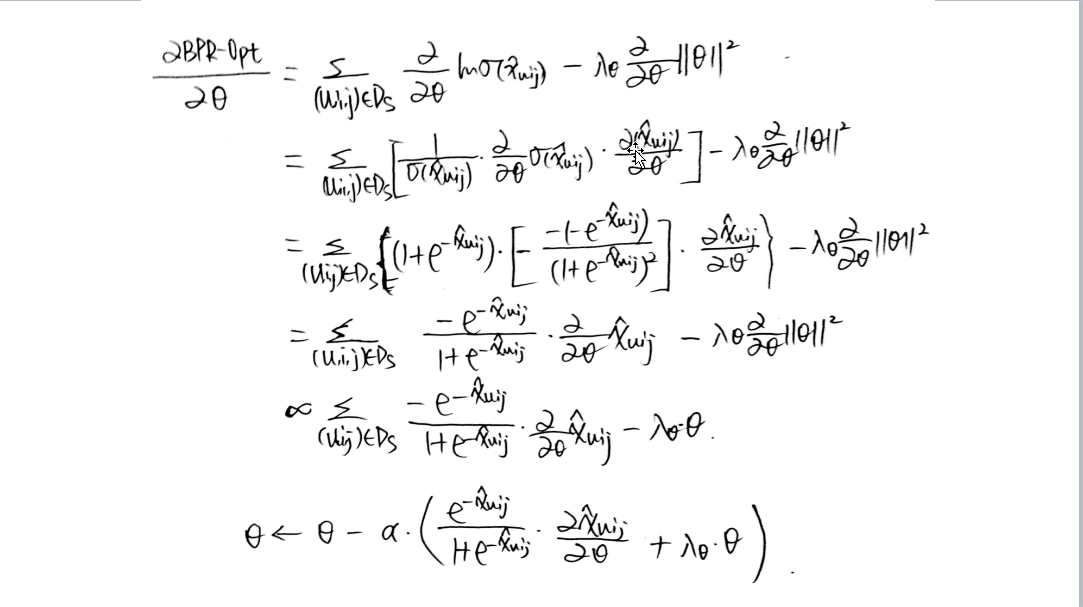

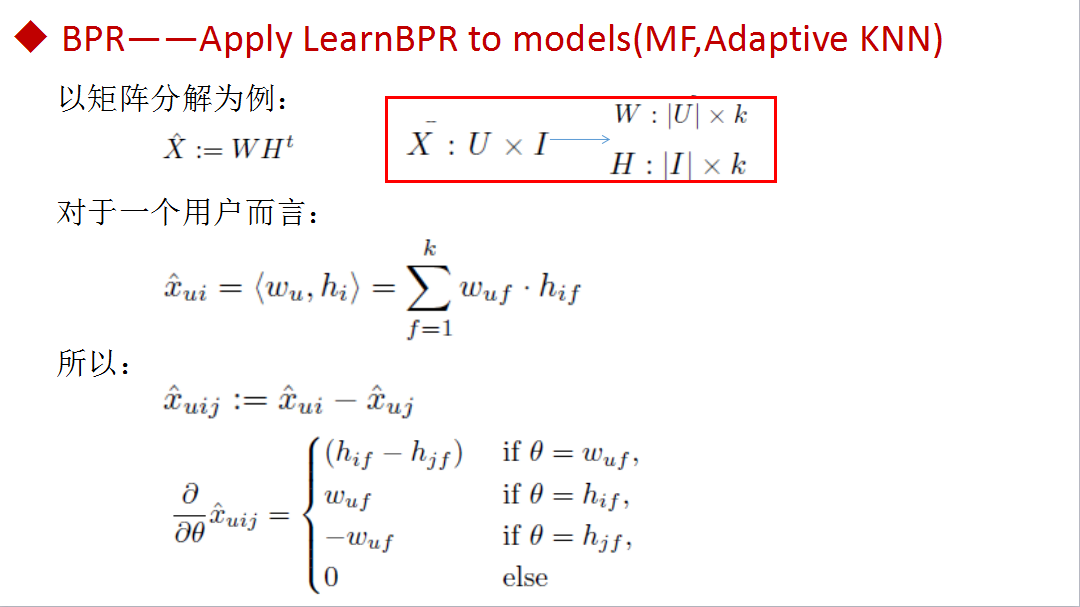

PPT解释:贝叶斯方法找到所有产品的个性化排序结果就是通过最大化后验概率(如上图所示),其中,Θ表示二元关系模型(如矩阵分解模型)中的参数向量;>_u表示,用户u的隐偏好结构。那么,结合所有用户的概率函数如上图所示;δ是指示函数(如上图所示)。  PPT解释:所以,结合所有用户的概率函数可被简化如图,另外,定义了用户u比产品j更偏好i的概率,其中,σ是logistic sigmoid函数,这里,x_uij(Θ)是模型参数向量Θ的任意一个实值函数,主要是描述用户u与产品i和j之间的关系。 至此,我们一直在讨论似然函数,但是为了完成贝叶斯个性化排序任务,论文还引入了先验密度p(Θ),其是一个均值为0、协方差矩阵为∑_Θ的正态分布。   PPT解释:由于BPR-Opt是可微分的,因此梯度下降的方法是解决最大化问题的显然选择。通常梯度下降方法分为完全梯度下降和随机梯度下降。但是,就本文的三元训练数据而言,在每一次更新上计算完全梯度是不可行的,另外,用完全梯度下降优化BPR-Opt会在训练对上产生偏斜,从而导致收敛变慢。因此选择随机梯度下降的方法来处理问题。 这又会遇到一个问题,典型的user−wise或者item−wise随机梯度下降方法具有较差的收敛效果,因为对于同一个user-item对(u,i)而言,由于产品j的数量较多,连续更新也就较为麻烦。为了解决以上问,本文提出了LearnBPR的算法。 梯度推导如下:   PPT解释:通常,MF和learned KNN都尝试对用户与产品间的隐藏偏好建模,他们都是预测用户产品对(u,l)的真实值x_ul。本文的优化是一个三元关系(u,i,j)。用户u对产品i的预测评分x_ui可被表示为X:U×I,通过对X进行矩阵分解,目标矩阵可被分解成两个低秩矩阵W:|U|×k和H:|I|×k的乘积。 其中,w_u表示用户u的特征向量。h_i表示产品i的特征向量。矩阵模型参数θ={W,H}。 通常,通过SVD实现X的最佳近似,但是,这一方法存在过拟合的问题,因此,很多其他的矩阵分解方法被提出,如正则化的最小二乘优化、非负分解、最大边际分解等。本文中为了评估用户对产品偏好的排序问题,提出了LearnBPR的算法。

赏

支付宝扫码打赏

如果文章对您有帮助,欢迎打赏鼓励作者

Back to Top