General Language Model

模型发布时间: 2021-03-18

模型发布机构: 清华大学

模型所属类型: 自然语言处理

GLM是清华大学知识工程小组发布的一个自然语言处理领域的预训练大模型。模型的参数最高达到100亿(注:这是发布的数据,2022年8月,该模型已经发展到1300亿参数!)

以下部分是该模型的摘要内容

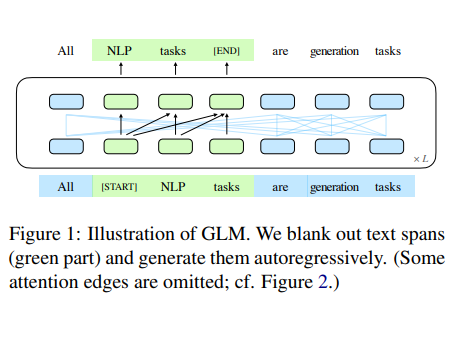

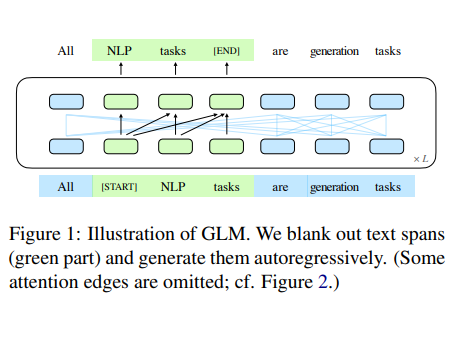

已经有各种类型的预训练架构,包括自动编码模型(如BERT),自回归模型(如GPT),以及编码器-解码器模型(如T5)。然而,没有一个预训练框架对包括自然语言理解(NLU)、无条件生成和有条件生成在内的三个主要类别的所有任务表现最好。GLM是一个基于自回归空白填充的通用语言模型。通过增加二维位置编码和允许任意顺序预测跨度来改进空白填充预训练,这使得NLU任务上的性能比BERT和T5有所提高。同时,GLM可以通过改变空白的数量和长度对不同类型的任务进行预训练。在横跨NLU、条件和无条件生成的广泛任务上,GLM在相同的模型大小和数据下优于BERT、T5和GPT,并以1.25倍于BERT Large的参数从单一预训练模型中获得了最佳性能,证明了其对不同下游任务的普适性。

重要的是,该模型是开源的,最小的1.1亿参数版本,到最高的100亿的预训练结果都是公开可以下载的。需要注意的是,GLM提供了不同的版本,包括一个中文版本的100亿参数预训练结果。