Tsinghua-ERNIE - Enhanced Language Representation with Informative Entities

模型详细情况和参数

Tsinghua-ERNIE

- 模型全称

- Enhanced Language Representation with Informative Entities

- 模型简称

- Tsinghua-ERNIE

- 模型类型

- 基础大模型

- 发布日期

- 2019-05-17

- 预训练文件大小

- 0.218

- 是否支持中文(中文优化)

- 是

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 1.14

- 模型代码开源协议

- MIT License

- 预训练结果开源商用情况

- MIT License - 免费商用授权

- 模型GitHub链接

- https://github.com/thunlp/ERNIE

- 模型HuggingFace链接

- 暂无

- 在线演示地址

- 暂无

- 基础模型

- 无基础模型

- 发布机构

Enhanced Language Representation with Informative Entities 简介

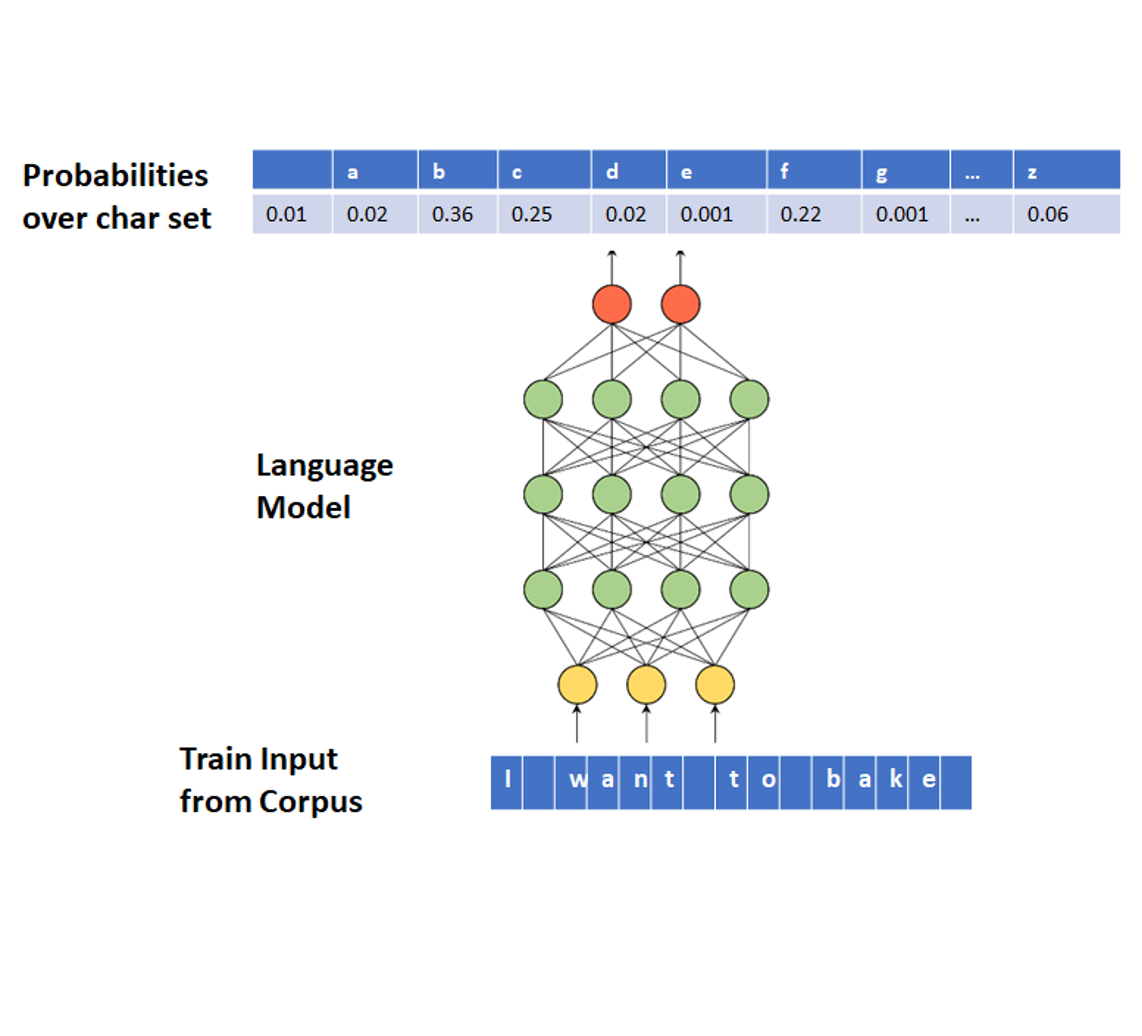

神经语言表示模型,如在大规模语料库上预训练的BERT,可以很好地从纯文本中捕捉到丰富的语义模式,并进行微调以持续改进各种NLP任务的性能。然而,现有的预训练语言模型很少考虑将知识图谱(KG)纳入其中,KG可以提供丰富的结构化知识事实以实现更好的语言理解。我们认为,KG中的信息实体可以增强语言表示的外部知识。在本文中,我们利用大规模文本语料库和KG训练了一个增强语言表示模型(ERNIE),可以同时充分利用词汇、句法和知识信息。实验结果表明,ERNIE在各种知识驱动任务上取得了显著的改进,同时在其他常见NLP任务上与最先进的模型BERT相当。

预训练结果下载地址: https://cloud.tsinghua.edu.cn/f/a763616323f946fd8ff6/

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

Tsinghua-ERNIE所属的领域

Tsinghua-ERNIE相关的任务