LLaMA-2-7B-32K - LLaMA-2-7B-32K

模型详细情况和参数

LLaMA-2-7B-32K

- 模型全称

- LLaMA-2-7B-32K

- 模型简称

- LLaMA-2-7B-32K

- 模型类型

- 基础大模型

- 发布日期

- 2023-07-28

- 预训练文件大小

- 13.3GB

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 32K

- 模型参数数量(亿)

- 70.0

- 模型代码开源协议

- Apache 2.0

- 预训练结果开源商用情况

- 免费商用授权 - 免费商用授权

- 模型GitHub链接

- 暂无

- 模型HuggingFace链接

- https://huggingface.co/togethercomputer/LLaMA-2-7B-32K

- 在线演示地址

- 暂无

- 基础模型

-

LLaMA2

查看详情 - 发布机构

LLaMA-2-7B-32K 简介

Together AI在其博客中宣布了LLaMA-2-7B-32K的发布,这是一个32K上下文模型,使用位置插值和Together AI的数据配方和系统优化构建,包括FlashAttention-2。该模型可以针对目标长上下文任务进行微调,如多文档理解、摘要和问答,并在32K上下文中进行推理和微调,速度提升了3倍。

在过去的几个月中,我们见证了开源生态系统LLMs的快速进步,从触发“LLaMA时刻”的原始LLaMA模型,到RedPajama、MPT、Falcon等努力,以及最近的LLaMA-2发布,开源模型一直在迎头赶上闭源模型。我们相信,开源模型即将的机会是将开放模型的上下文长度扩展到32K-128K的范围,与最先进的闭源模型相匹配。我们已经看到了一些令人兴奋的努力,如MPT-7B-8K和LLongMA-2(8K)。

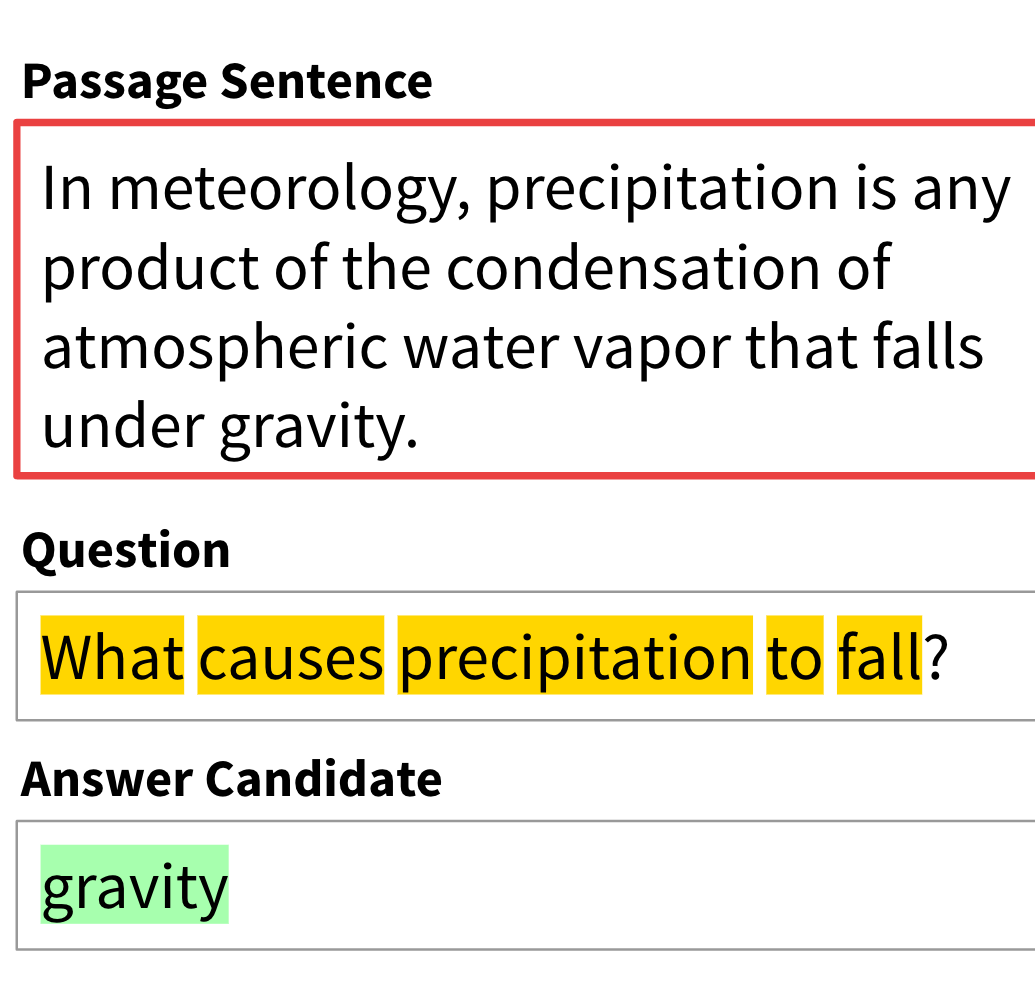

LLaMA-2-7B-32K:我们将LLaMA-2-7B的长上下文扩展到32K,使用Meta的插值和持续预训练配方。我们分享了我们当前的数据配方,包括长上下文预训练和指令调整数据的混合。

构建自己的长上下文模型的示例:我们分享了如何微调LLaMA-2-7B-32K来构建特定应用的两个示例,包括书籍摘要和长上下文问题回答。

软件支持:我们更新了推理和训练堆栈,以允许使用最近发布的FlashAttention-2和一系列其他优化进行高效的推理和微调,使用32K上下文。这允许用户创建自己的32K上下文模型并进行高效的推理。

尝试一下:

- 前往Together API并运行LLaMA-2-7B-32K进行推理。

- 使用OpenChatKit对LLaMA-2-7B-32K进行微调,为您自己的长上下文应用创建一个32K模型。

- 前往HuggingFace并尝试LLaMA-2-7B-32K。

长上下文模型已经对文档理解、摘要和检索增强生成至关重要。我们很高兴能与开源社区分享这项工作,并朝着更好、更长上下文模型的持续进步迈进。

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

LLaMA-2-7B-32K所属的领域

LLaMA-2-7B-32K相关的任务