Raven 14B - Raven 14B

模型详细情况和参数

Raven 14B

- 模型全称

- Raven 14B

- 模型简称

- Raven 14B

- 模型类型

- 聊天大模型

- 发布日期

- 2022-10-20

- 预训练文件大小

- 28.3GB

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 2K

- 模型参数数量(亿)

- 140.0

- 模型代码开源协议

- Apache 2.0

- 预训练结果开源商用情况

- Apache 2.0 - 免费商用授权

- 模型GitHub链接

- https://github.com/BlinkDL/RWKV-LM

- 模型HuggingFace链接

- https://huggingface.co/spaces/BlinkDL/ChatRWKV-gradio

- 在线演示地址

- 暂无

- 基础模型

- 无基础模型

- 发布机构

Raven 14B 简介

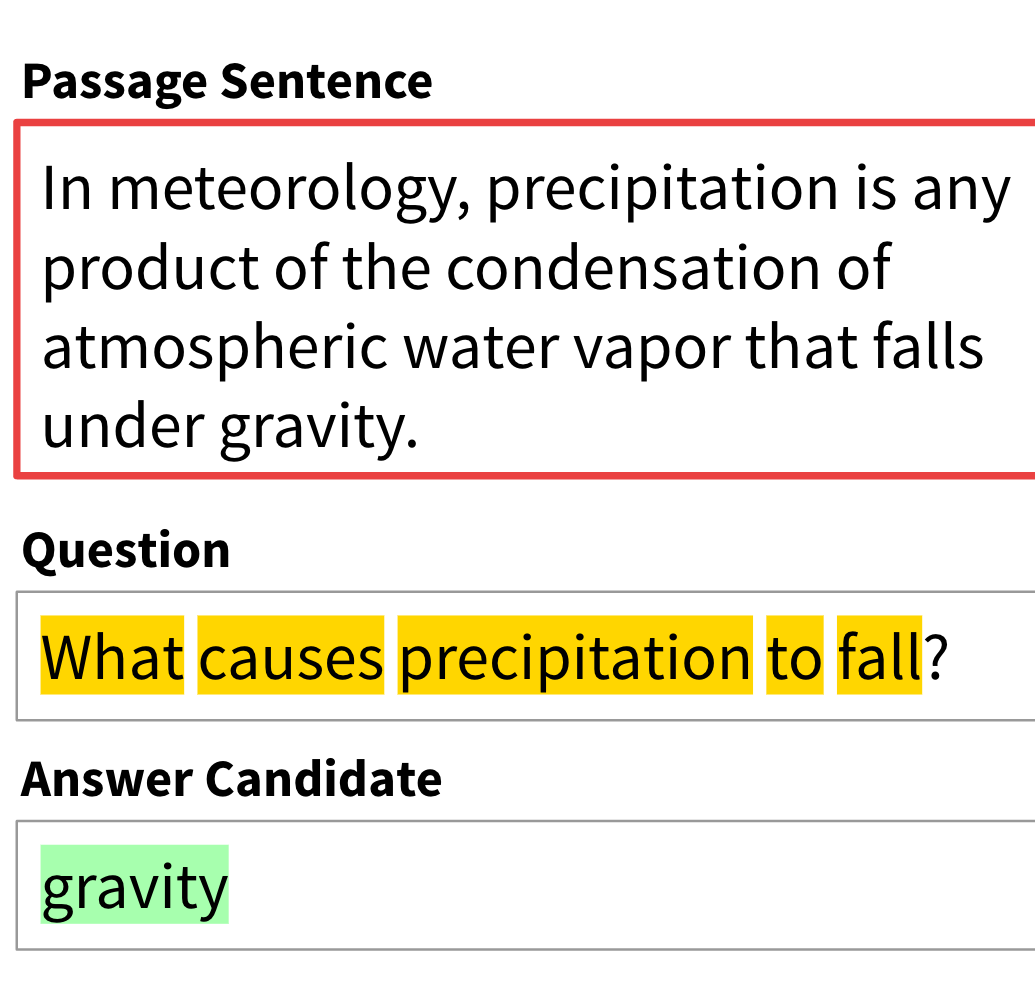

Raven 14B是一个可并行训练的RNN预训练大模型,其基础模型名称为RWKV,名称来源于模型的4个参数。

RWKV模型是一个有着Transformer水平的大语言模型,但是它是一个RNN架构。不需要注意力层。

尽管transformer模型是当今大模型的主要架构,然而,注意力机制的处理能力随着要处理的序列长度呈二次增长。这有效地限制了模型的输入大小(或“上下文长度”)。此外,由于注意力机制,在生成文本时,我们需要将所有先前标记的注意力向量保存在内存中。这比仅存储单个状态的RNN需要更多的内存。

为此,香港大学物理系毕业的彭博提出了RWKV模型,RWKV将RNN和Transformer的最佳特性结合在一起。在训练期间,我们使用变换器类型的架构公式,这允许大规模并行化(带有一种随标记数量呈线性增长的注意力)。在推断期间,我们使用等效的公式,它的工作方式类似于带有状态的RNN。这使我们可以兼顾两者的优点。

因此,我们基本上拥有一个像变压器一样训练的模型,只不过长的上下文长度不会花费太多代价。在推断期间,我们需要的内存少得多,并且可以隐式地处理“无限”上下文长度(尽管在实践中,模型可能难以推广到比训练期间看到的更长的上下文长度)。

Raven 14B是一种RWKV架构的预训练大模型,基于Pile数据训练。其中,它的层数为40层,维度是5120维。其中,Raven系列模型是基于Alpaca、CodeAlpaca、Guanaco、GPT4All、ShareGPT等模型微调的RWKV架构的模型。

Raven 14B模型在LM-Sys的匿名测评中获得了第六名的成绩,仅次于Koala-13B,好于Oasst-Pythia-12B(2023年5月第二周结果)。

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

Raven 14B所属的领域

Raven 14B相关的任务