好东西!Transformer入门神作手把手按行实现Transformer教程The Annotated Transformer2022版本来袭

2,126 阅读

The Annotated Transfomer是哈佛大学的研究人员于2018年发布的Transformer新手入门教程。这个教程从最基础的理论开始,手把手教你按照最简单的python代码实现Transformer,一经推出就广受好评。2022年,这个入门教程有了新的版本。

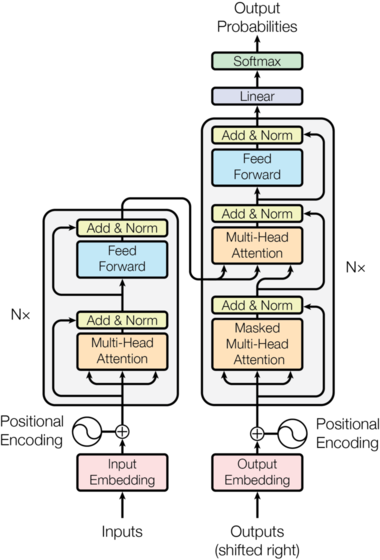

自从2017年,谷歌发出Attention is All You Need论文之后,Transformer架构席卷整个深度学习圈。除了在翻译质量上取得重大改进外,它还为许多其他NLP任务提供了新的架构。论文本身写得很清楚,但传统的观点是很难正确实施。

为此,哈佛大学NLP小组的Associate Professor——Alexander以逐行实现的形式呈现了Attention is All You Need论文的“注释”版本。他已经重新排序并删除了原始论文中的一些部分,并在全文中添加了评论。本文档本身就是一个notebook,应该是一个完全可用的实现。总共有400行库代码,可以在4个GPU上每秒处理27000个tokens。

这些代码需要安装PyTorch。完整的notebook也可以在github或GoogleColab上免费使用GPU。

请注意,这只是研究人员和感兴趣的开发人员的起点。这里的代码主要基于哈佛大学的OpenNMT包。

博客地址: GitHub地址: