重磅!ChatGLM2-6B免费商用了~

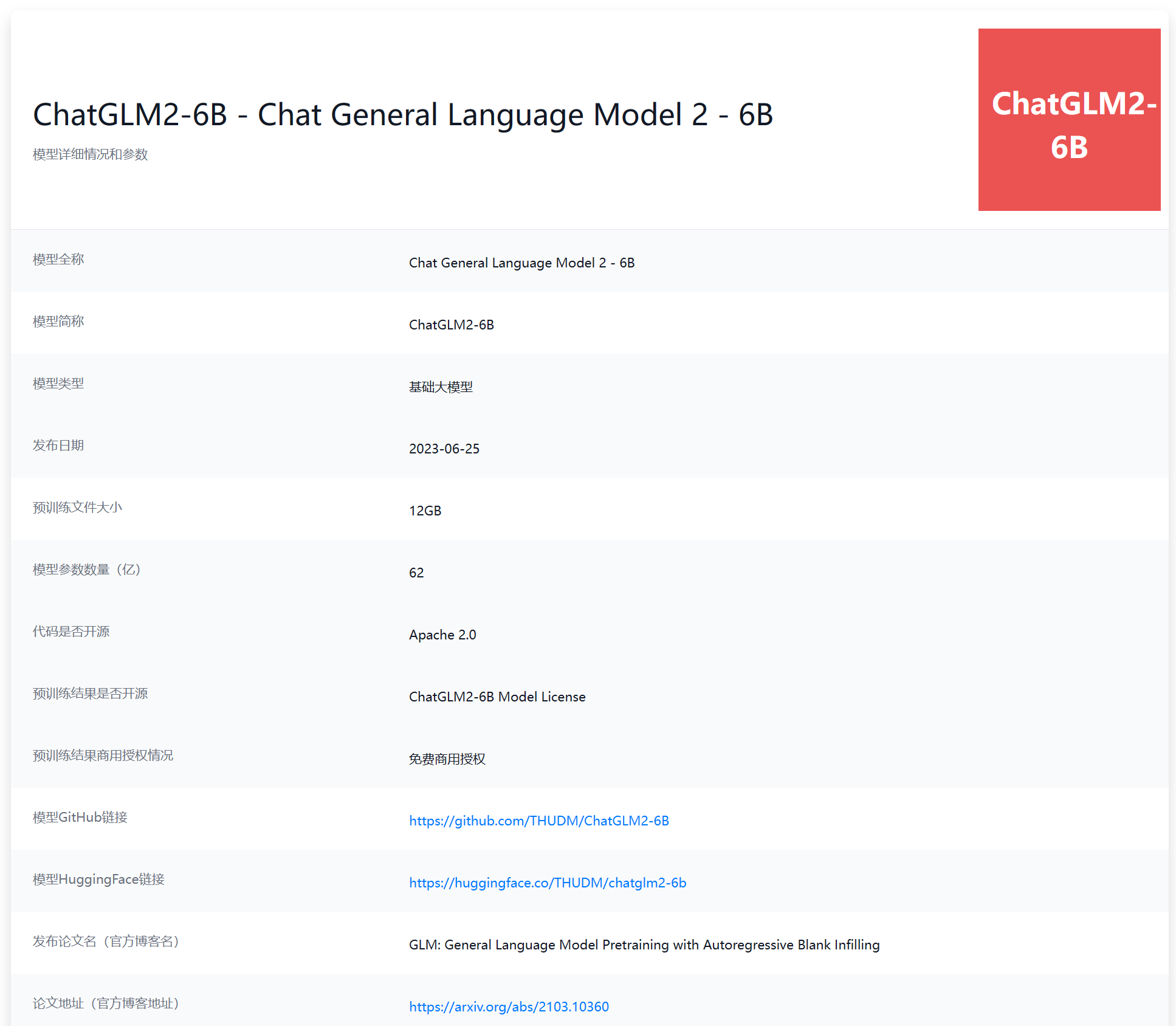

ChatGLM-6B是国产开源大模型领域最强大的的大语言模型。因其优秀的效果和较低的资源占用在国内引起了很多的关注。2023年6月25日,清华大学KEG和数据挖掘小组(THUDM)发布了第二代ChatGLM2-6B。

在七月初,ChatGLM-6B免费商用之后,ChatGLM2-6B宣布免费商用了!

相比较第一代ChatGLM模型,第二代的ChatGLM2-6B的主要升级包括:

ChatGLM2-6B升级1:基座模型升级,性能更加强大

第二代的ChatGLM2-6B的基座模型使用了GLM模型的混合目标函数,在1.4万亿中英文tokens数据集上训练,并做了模型对齐。而测试显示,第二代的ChatGLM2-6B比第一代模型有了很大提升,在各项任务中的提升幅度如下:

| 评测任务 | 任务类型 | ChatGLM-6B得分 | ChatGLM2-6B得分 | 提升幅度 | | ------------ | ------------ | ------------ | | MMLU | 英文语言理解 | 40.63 | 47.86 | ↑ 23% | | CEval | 中文大语言模型评估 | 38.9 | 51.7 | ↑ 33% | | GSM8K | 数学(英文版) | 4.82 | 32.37 | ↑ 571% | | BBH |大语言模型的BIG-Bench Hard任务 | 18.73 | 33.68 | ↑ 60% |