LLaMA2 7B一样的性能但是由15倍的推理速度!Deci开源DeciLM-6B和DeciLM-6B-Instruct,发布一天上榜HuggingFace Trending

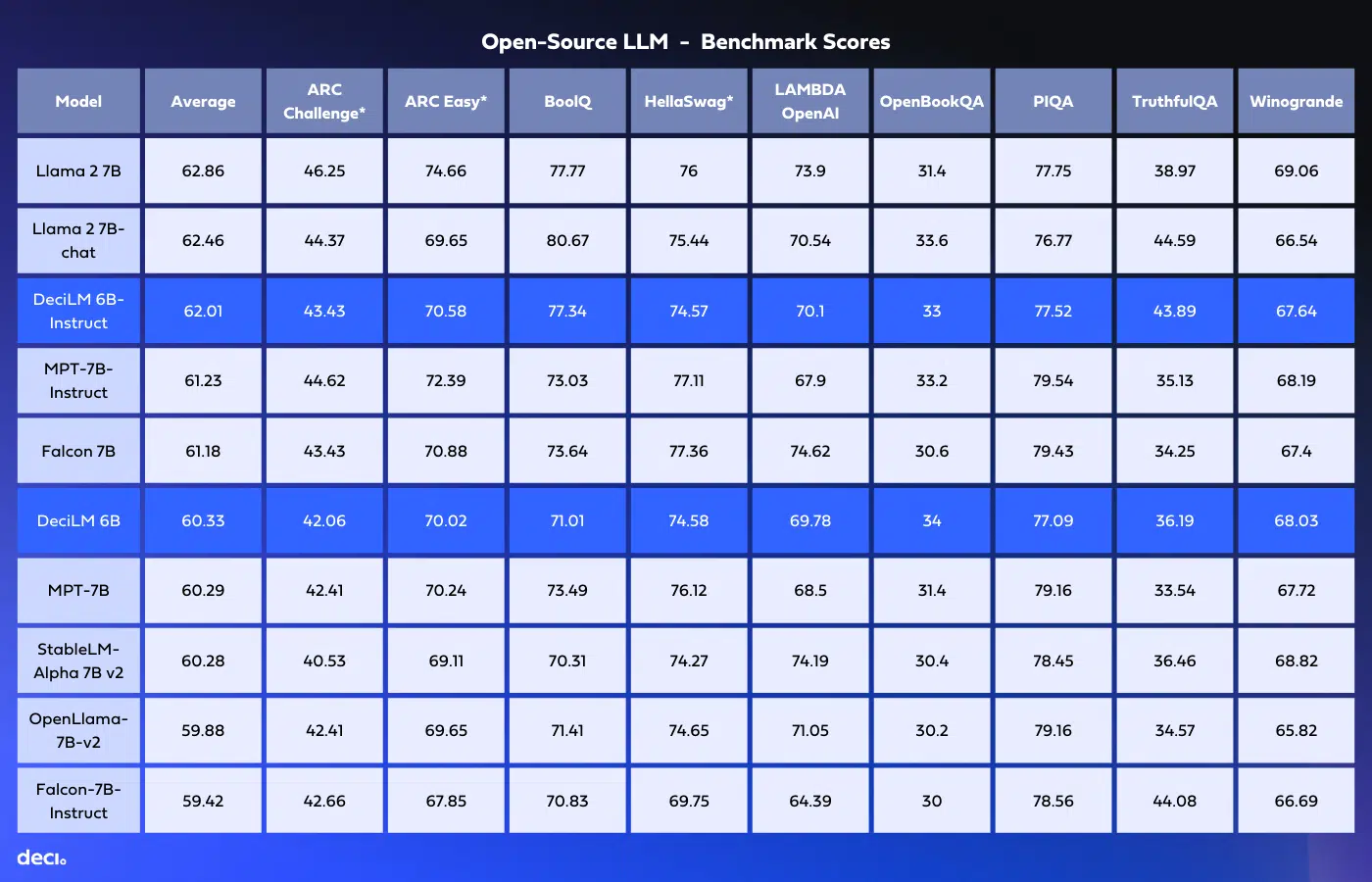

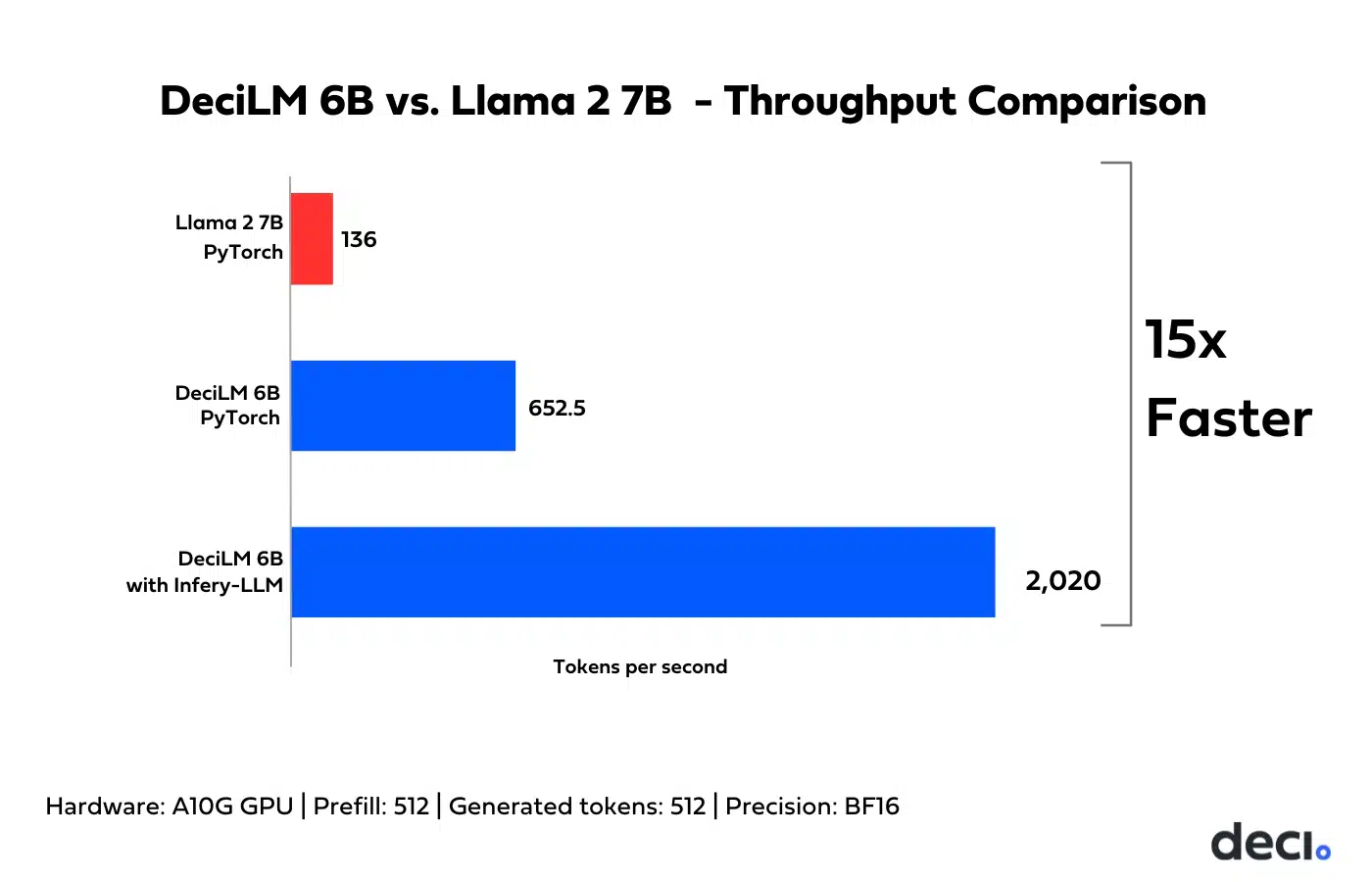

随着大型语言模型(LLMs)的不断发展,它们在训练和推理方面的计算需求已经呈指数级增长。这一趋势不仅带来了高昂的成本和能源消耗,还引入了模型部署和可伸缩性方面的障碍。为此,DeciLM开源了2个全新的DeciLM-6B和DeciLM-6B-Instruct大模型,参数比LLaMA2 7B略低,性能相当,但是推理速度却超过LLaMA2 7B的15倍。

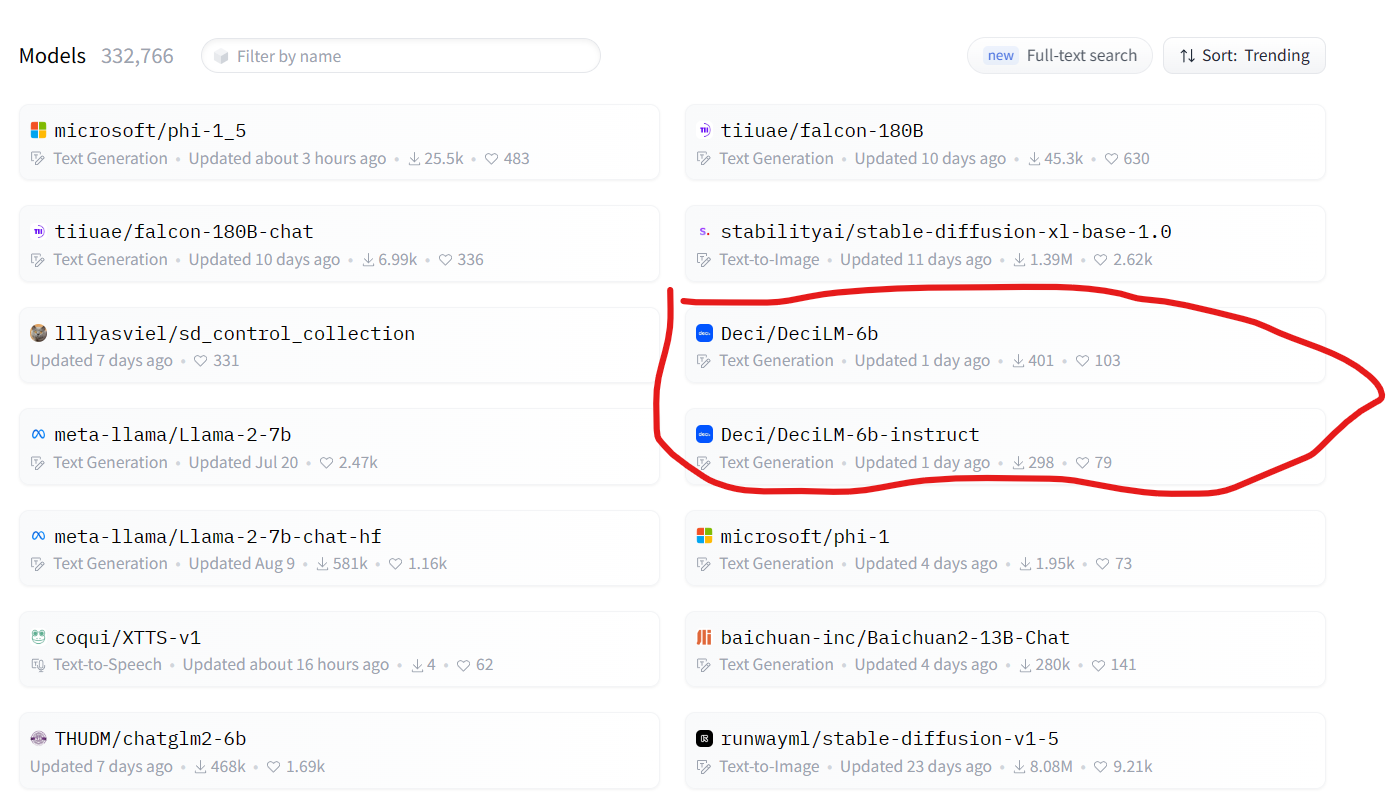

这2个模型一发布就上榜HuggingFace的趋势榜,可以说引起了很多的关注。DataLearner目前已经上架了DeciLM 6B的模型信息卡地址,参考如下: