SWE-bench Verified:提升 AI 模型在软件工程任务评估中的可靠性

在人工智能领域,随着大型语言模型(LLMs)在各类任务中的表现不断提升,评估这些模型的实际能力变得尤为重要。尤其是在软件工程领域,AI 模型是否能够准确地解决真实的编程问题,是衡量其真正应用潜力的关键。而在这方面,OpenAI 推出的 SWE-bench Verified 基准测试,旨在提供一个更加可靠和精确的评估工具,帮助开发者和研究者全面了解 AI 模型在处理软件工程任务时的能力。

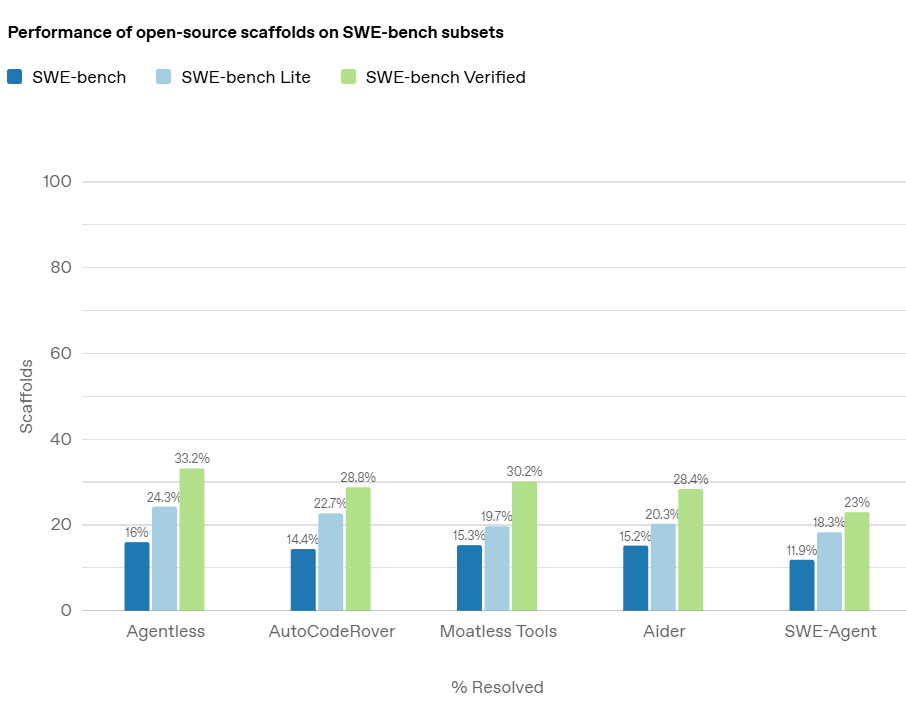

SWE-bench Verified 是对原始 SWE-bench 测试集的优化版本,它通过人工验证和改进,解决了原测试集中存在的一些关键问题。这一新的测试集不仅提升了评估的准确性,也为 AI 评估体系的透明性和可靠性注入了新的动力。

大模型在SWE-Bench Verified排行榜的得分可以参考DataLearnerAI的网站:https://www.datalearner.com/benchmarks/swe-bench%20verified