大模型多模态评测基准MMMU介绍

887 阅读

大模型多模态评测基准MMMU(大规模多学科多模态理解和推理基准)是一项旨在评估多模态人工智能模型在复杂跨学科任务中综合能力的测试工具。

1. 设计背景与目标

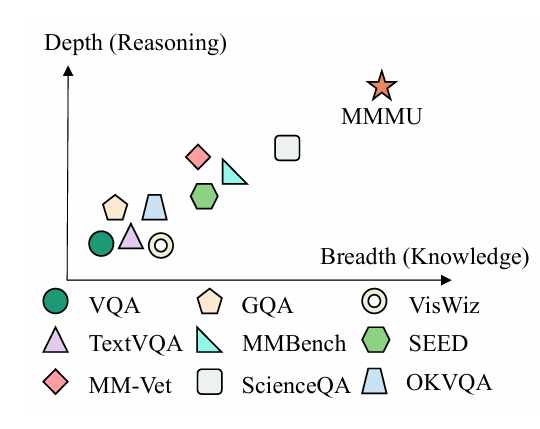

MMMU的提出源于现有多模态基准(如VQA、OK-VQA等)的局限性,这些基准往往局限于常识性任务或单一学科,难以评估模型对专业领域知识和深度推理的能力。MMMU的目标是模拟大学水平的跨学科考试场景,要求模型具备人类专家级的图文理解和推理能力,从而推动多模态模型向更接近通用人工智能(AGI)的方向发展。