重磅!阿里开源媲美GPT-4o的图片生成和编辑大模型Qwen Image,中文渲染能力很强,还有精确的文字控制,免费开源!

Qwen Image大模型是阿里千问团队开源的高质量图片生成和编辑的大模型。该模型在2025年8月5日发布,其核心并非又一个单纯追求图像美学或真实感的模型,而是直指一个长期存在的行业痛点:在图像中进行复杂、精准、尤其是高保真的多语言文本渲染。

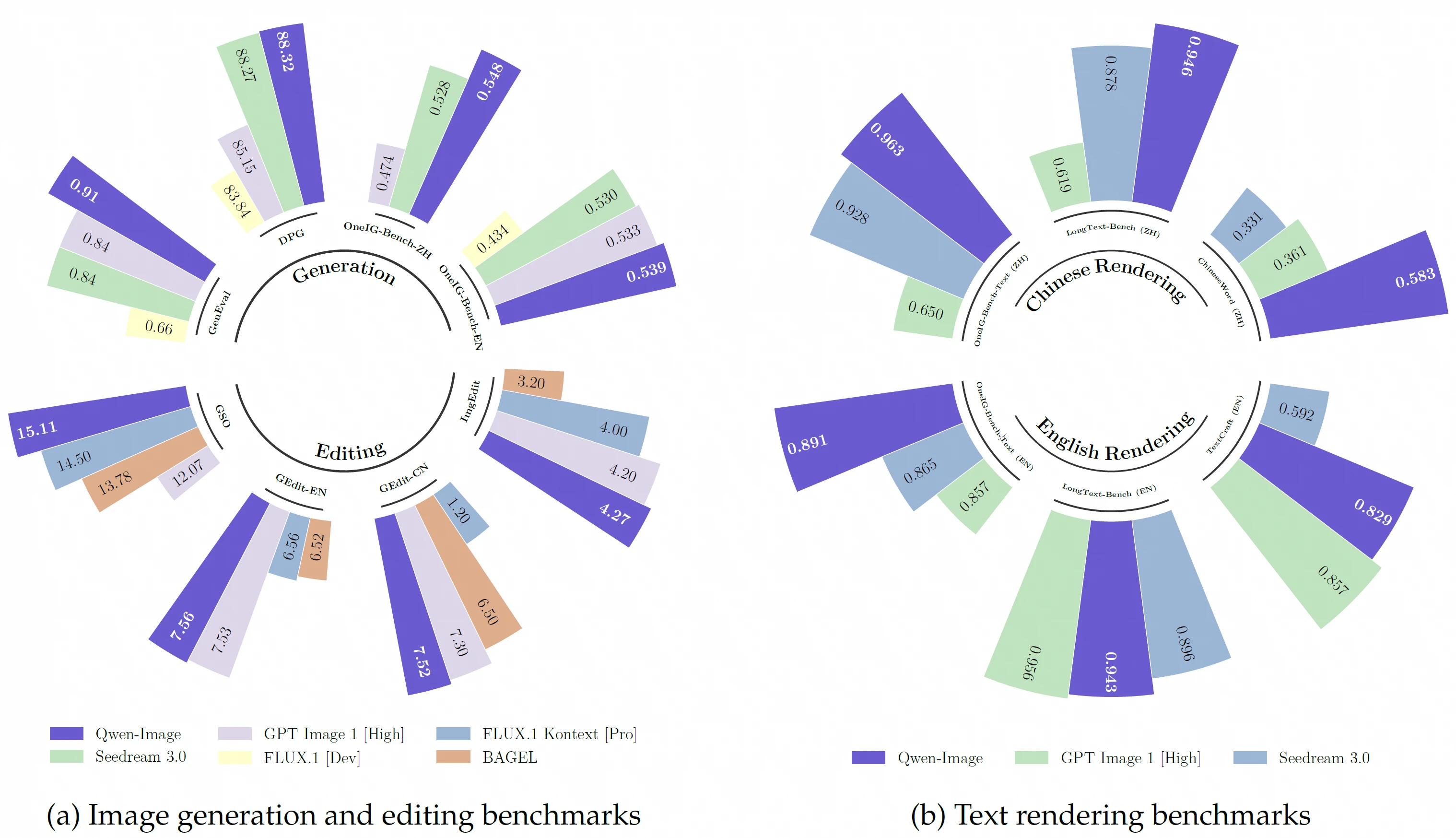

重要的是,这个模型以Apache 2.0协议开源,其图像生成的质量也非常优秀,官方给出的技术报告和初步评测数据显示,Qwen-Image在通用图像生成与编辑能力上对标顶级模型的同时,在中文文本渲染这一关键垂类上实现了SOTA(State-of-the-Art)级别的表现。

关于模型的开源地址、在线演示地址等其它信息参考DataLearnerAI的模型信息卡地址:https://www.datalearner.com/ai-models/pretrained-models/qwen-image