直接使用大模型通过界面来操作电脑和浏览器:谷歌发布Gemini 2.5 Computer Use 模型,重塑 AI 与界面交互能力,实测优秀~

就在昨天,2025年10月7日,Google DeepMind 正式发布其最新模型——Gemini 2.5 Computer Use。该模型基于 Gemini 2.5 Pro 的视觉理解与推理能力,新增了“界面交互(UI 控制)”能力,能够在浏览器或移动端界面上像人类那样点击、输入、滚动、选择控件等操作。

Gemini 2.5 Computer Use在多项 UI 自动化基准测试上,以更低延迟和更高准确率 大幅领先于现有同类产品。

本文将介绍一下这个模型,同时要给出用这个模型操作DataLearnerAI网站的实例,结果很不错~

- 一、为什么我们需要一个可以基于UI界面操作的大模型AI Agent

- 二、Gemini 2.5 Computer Use 模型不仅速度快,而且各方面水平都很好

- 三、Gemini 2.5 Computer Use实测:去DataLearnerAI网站上比较DeepSeek-R1模型和Kimi K2模型

- 四、Gemini 2.5 Computer Use模型最大的价值是从视觉分析到自主执行的智能闭环

- 视觉 + 上下文理解:识别界面元素结构

- 多步操作串联 + 状态回环感知

- 高阶交互行为:拖拽、排序、筛选、登录、验证

- 五、Gemini 2.5 Computer Use的安全控制机制

- 六、Gemini 2.5 Computer Use总结以及在线体验地址

一、为什么我们需要一个可以基于UI界面操作的大模型AI Agent

当前大模型的计算机使用主要依赖接口:你可以让模型调用接口完成上传图片、提交表单、查数据库等。

但许多现实任务,如提交网页表单、操作后台管理系统或控制移动 App,本质上都依赖图形界面(GUI),而非 API 调用。

这造成了一个长期痛点:

模型能理解任务,却无法完成最后的点击。

尽管已有部分模型尝试界面控制,它们常常受限于特定页面结构、动作库有限、上下文理解不准确、出错时恢复能力脆弱。常见问题包括:表单自动填写失败、复杂下拉菜单无法适配、异常情形不能自我纠错。

Gemini 2.5 Computer Use 模型的推出,正是为了填补这一空白。它构建在 Gemini 2.5 Pro 的视觉和推理基础上,专为 UI 交互优化,解决了代理在真实世界任务中的“最后一公里”问题。不同于以往版本的被动响应,这款模型主动“观察”截图、分析历史动作,并生成精确指令,形成闭环迭代。结果?代理不再是哑巴助手,而是能自主适应变化的智能操作者,大幅减少人为干预,推动 AI 从辅助工具向全能伙伴的跃进。

二、Gemini 2.5 Computer Use 模型不仅速度快,而且各方面水平都很好

在性能上,Gemini 2.5 Computer Use 模型展现出无可匹敌的领先。它在多个权威基准测试中脱颖而出,包括 Online-Mind2Web、WebVoyager 和 AndroidWorld,这些测试涵盖了从网页导航到移动控制的复杂任务。

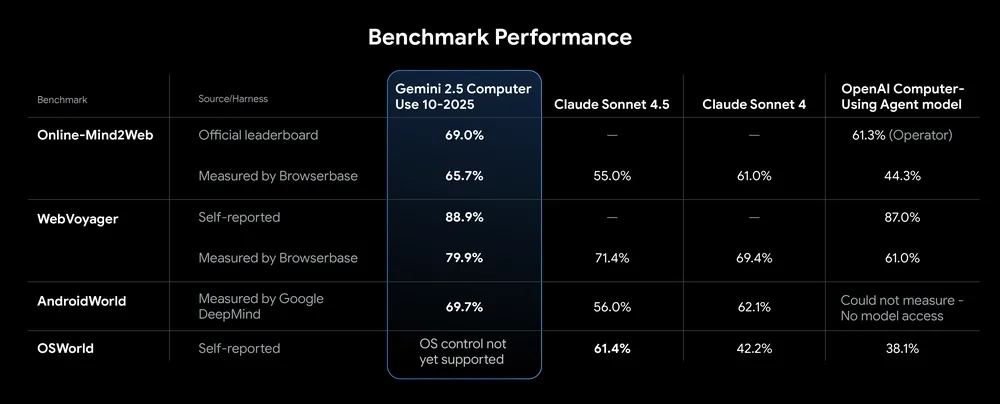

下图展示了Gemini 2.5 Computer Use模型与当前最强模型在计算机使用方面的评测结果:

可以看到,Gemini 2.5 Computer Use模型各方面表现都很强,都明显由于其它模型:

- 在 Online-Mind2Web、WebVoyager 和 AndroidWorld 基准上,该模型均夺得第一名。

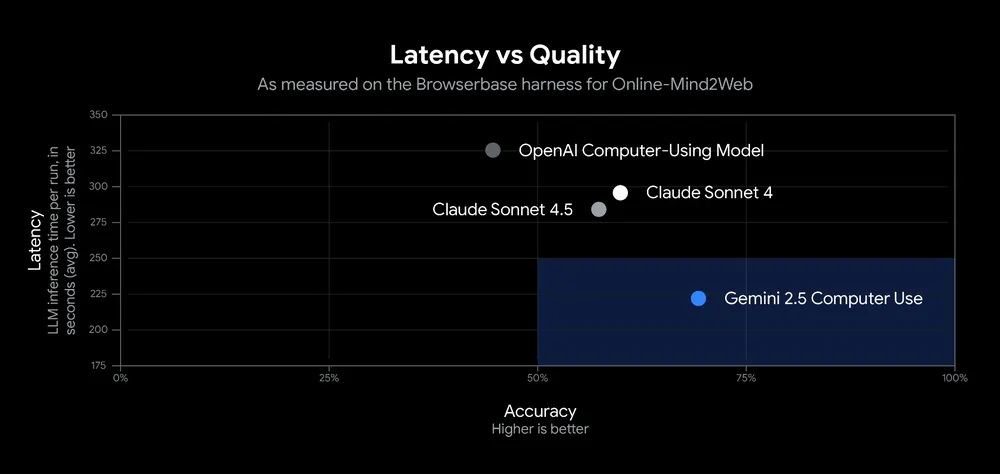

- 在 Browserbase 的整合测评中,它在浏览器控制任务中的 准确率超过 70%,而延迟却保持在极低水平(典型任务从截图输入到动作输出的平均延迟仅约 225 ms)。

- 在延迟-准确率散点图中,它位于低延迟与高准确率象限的极端位置:几乎没有其他模型能同时兼顾这两项指标。

来自早期合作方的反馈也认为Gemini 2.5 Computer Use模型非常不错: - Poke.com 表示其流程速度比“次优方案”快 50%; - Autotab 报告其在最难评测中的表现比竞品高出 18%; - Google 内部支付平台团队 引入该模型后,曾造成 25% 的 UI 测试失败率中的那部分脆弱流程中,有 60% 的执行失败能被模型自动恢复,节省了大量人工干预。

从数据来看,Gemini 2.5 Computer Use 在多个维度都取得了 显著提升:延迟减少、准确率提升、任务成功率增强、错误恢复能力增强。这些量化指标足以支撑其在 UI 控制领域的领先地位。

三、Gemini 2.5 Computer Use实测:去DataLearnerAI网站上比较DeepSeek-R1模型和Kimi K2模型

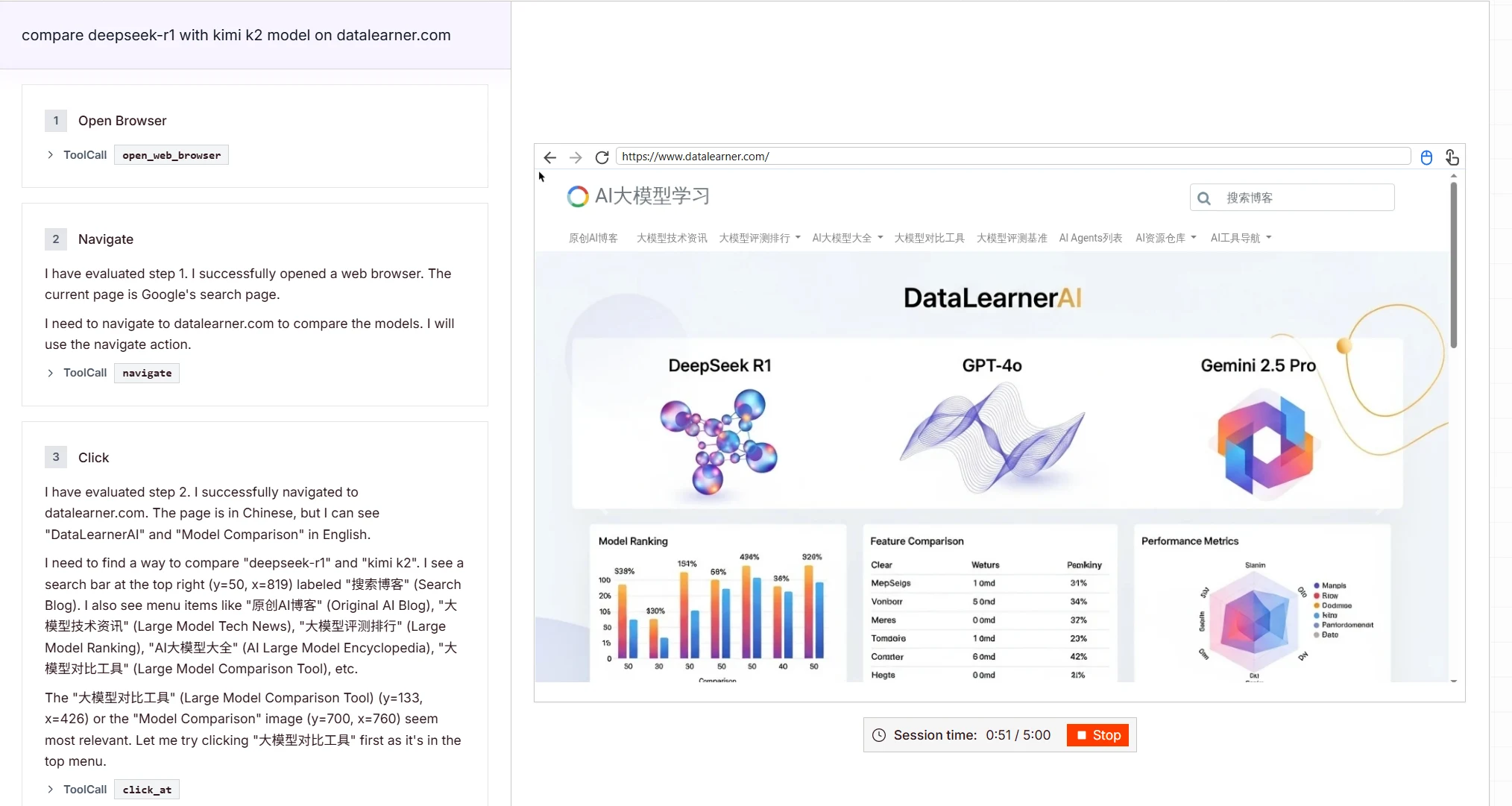

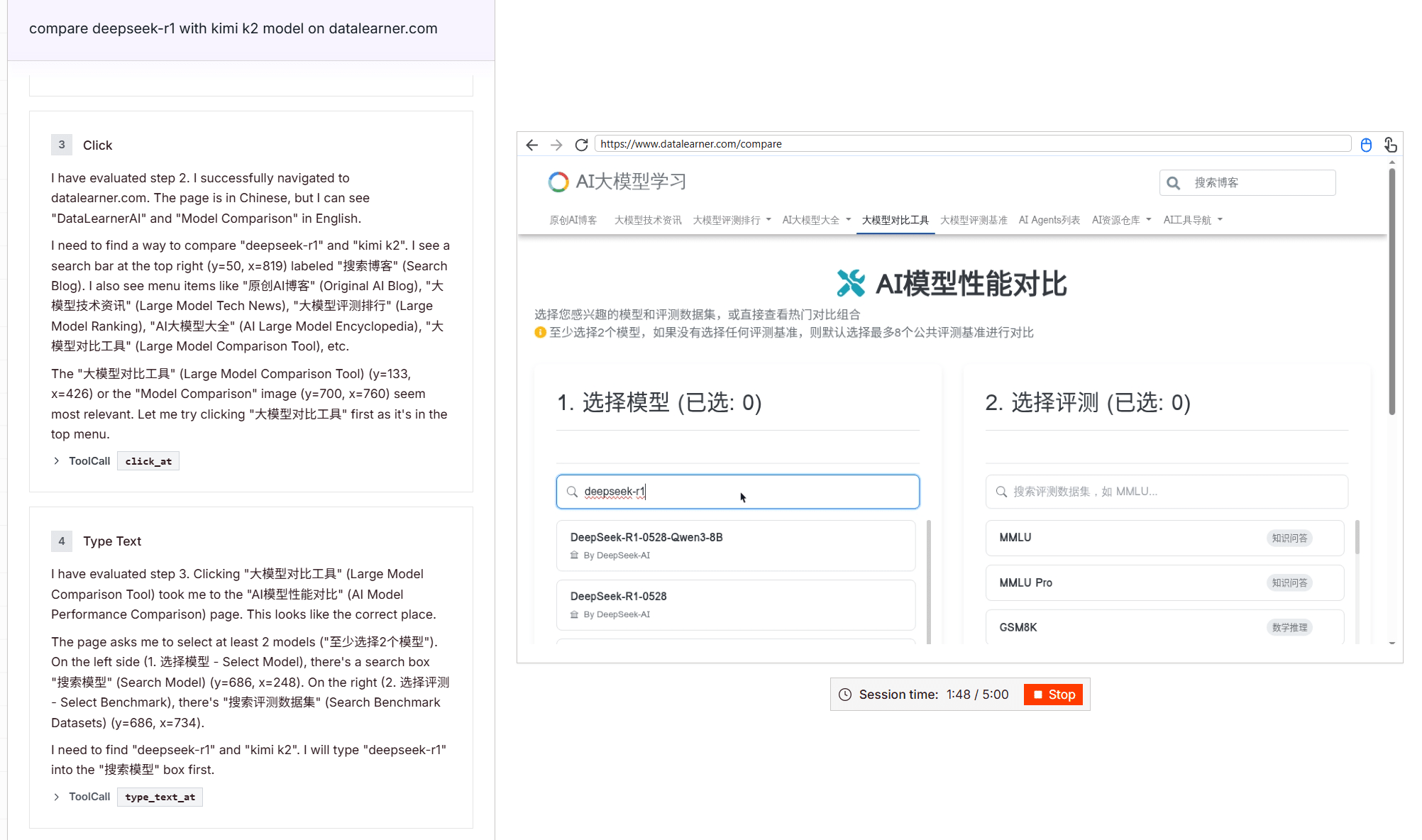

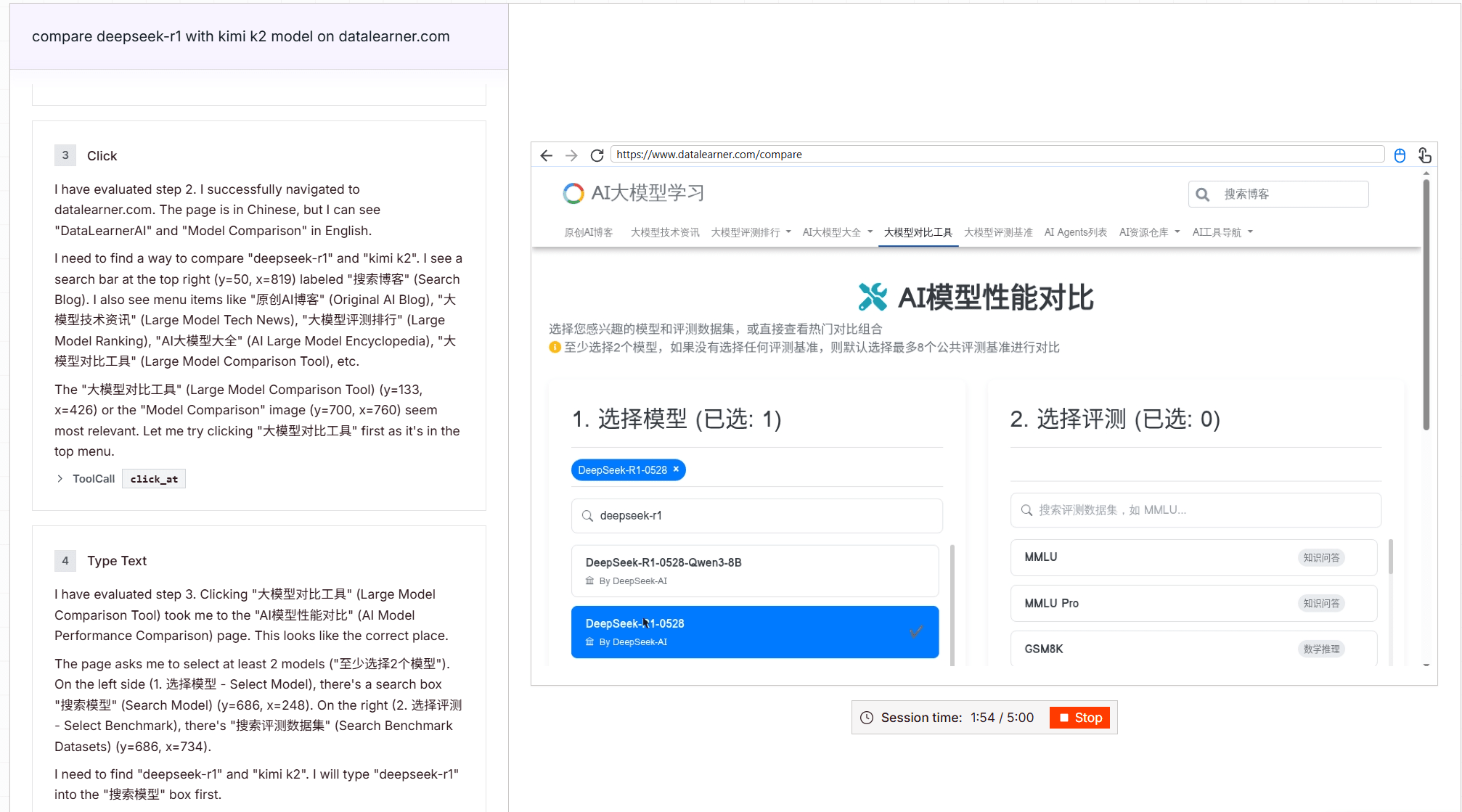

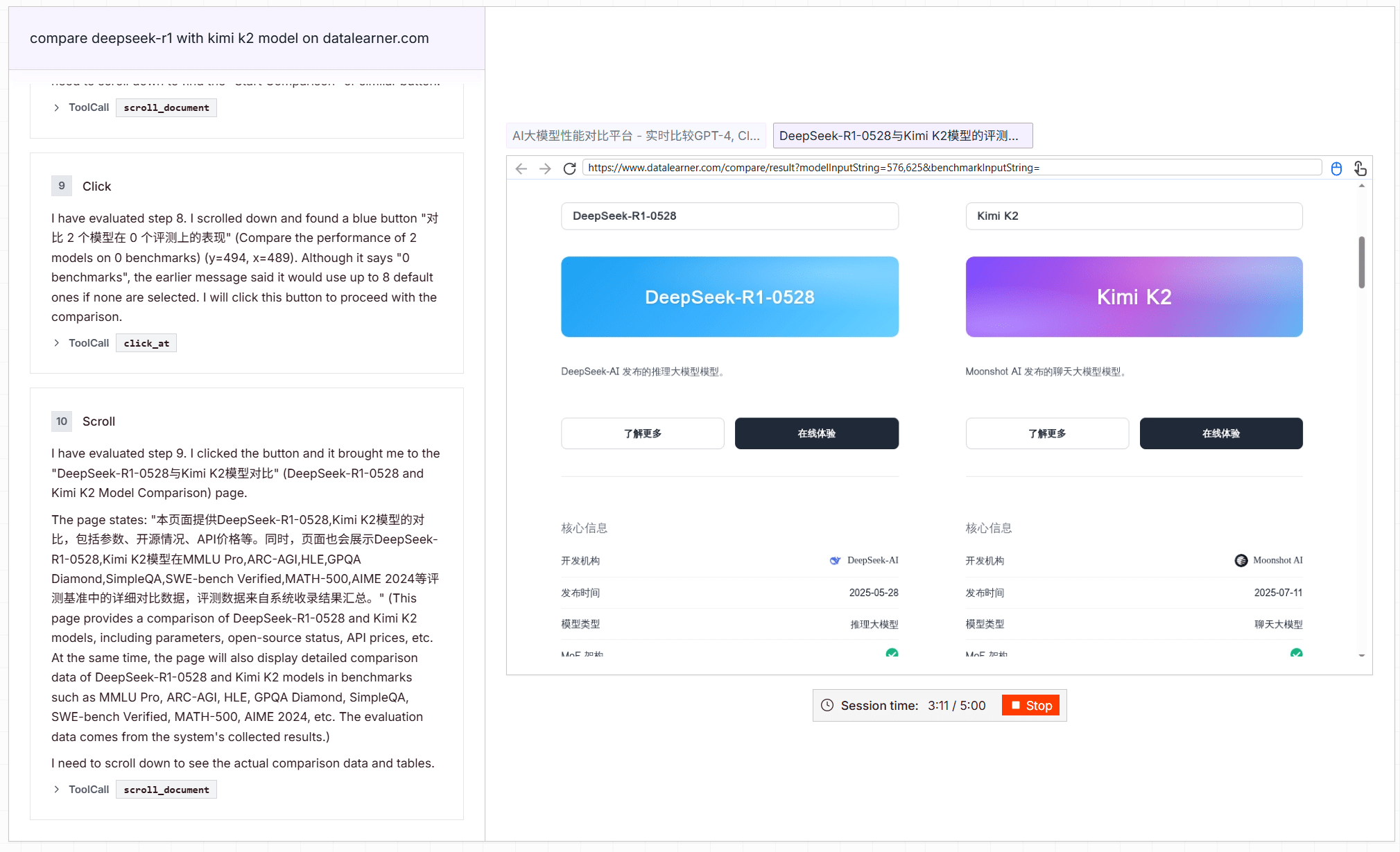

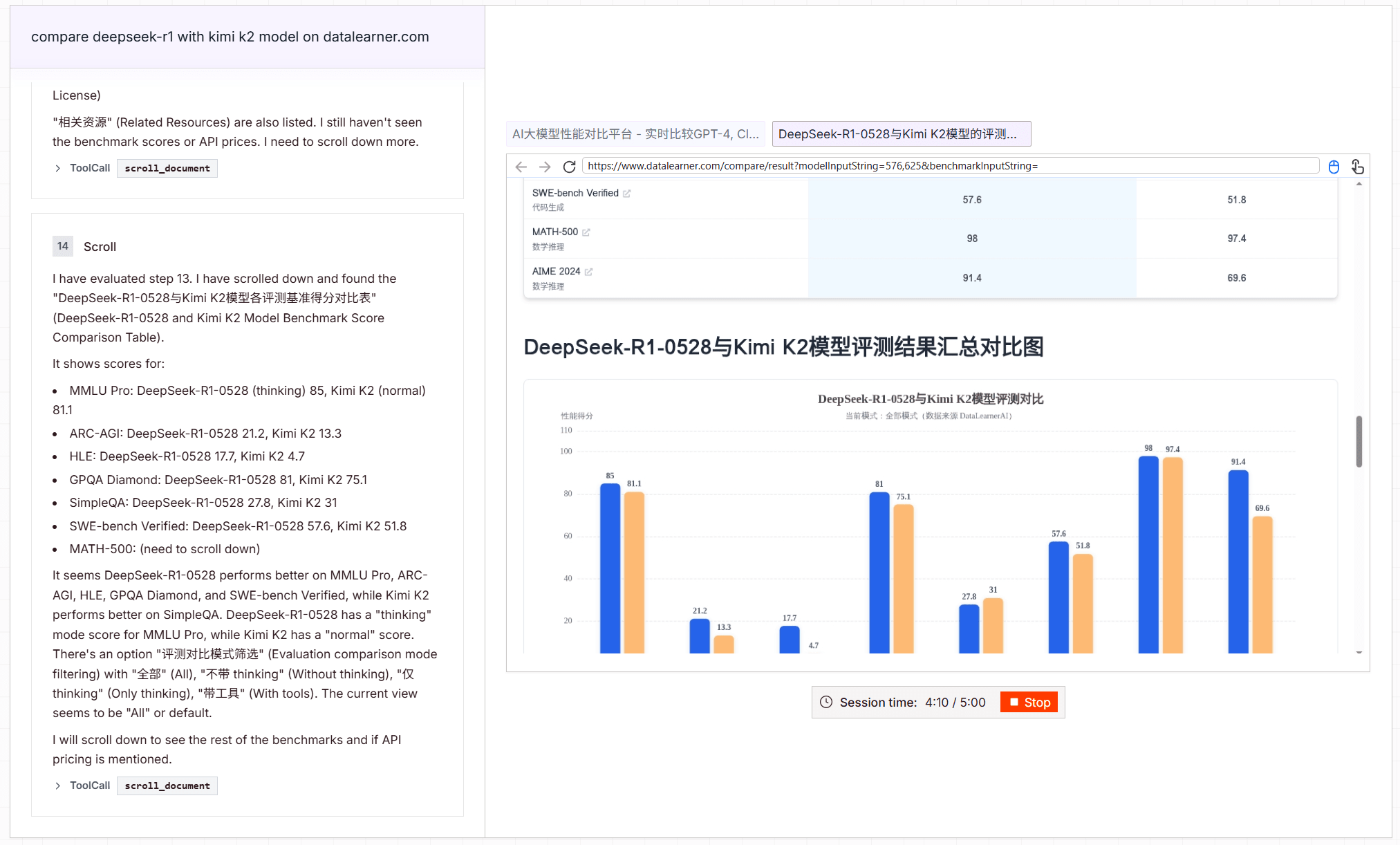

当前,Browserbase提供了一个Gemini 2.5 Computer Use的体验地址,我们测试了一下,在对话框中输入:

compare deepseek-r1 with kimi k2 model on datalearner.com,也就是用datalearner.com对比下过程最强的2个大模型DeepSeek-R1模型和Kimi K2。

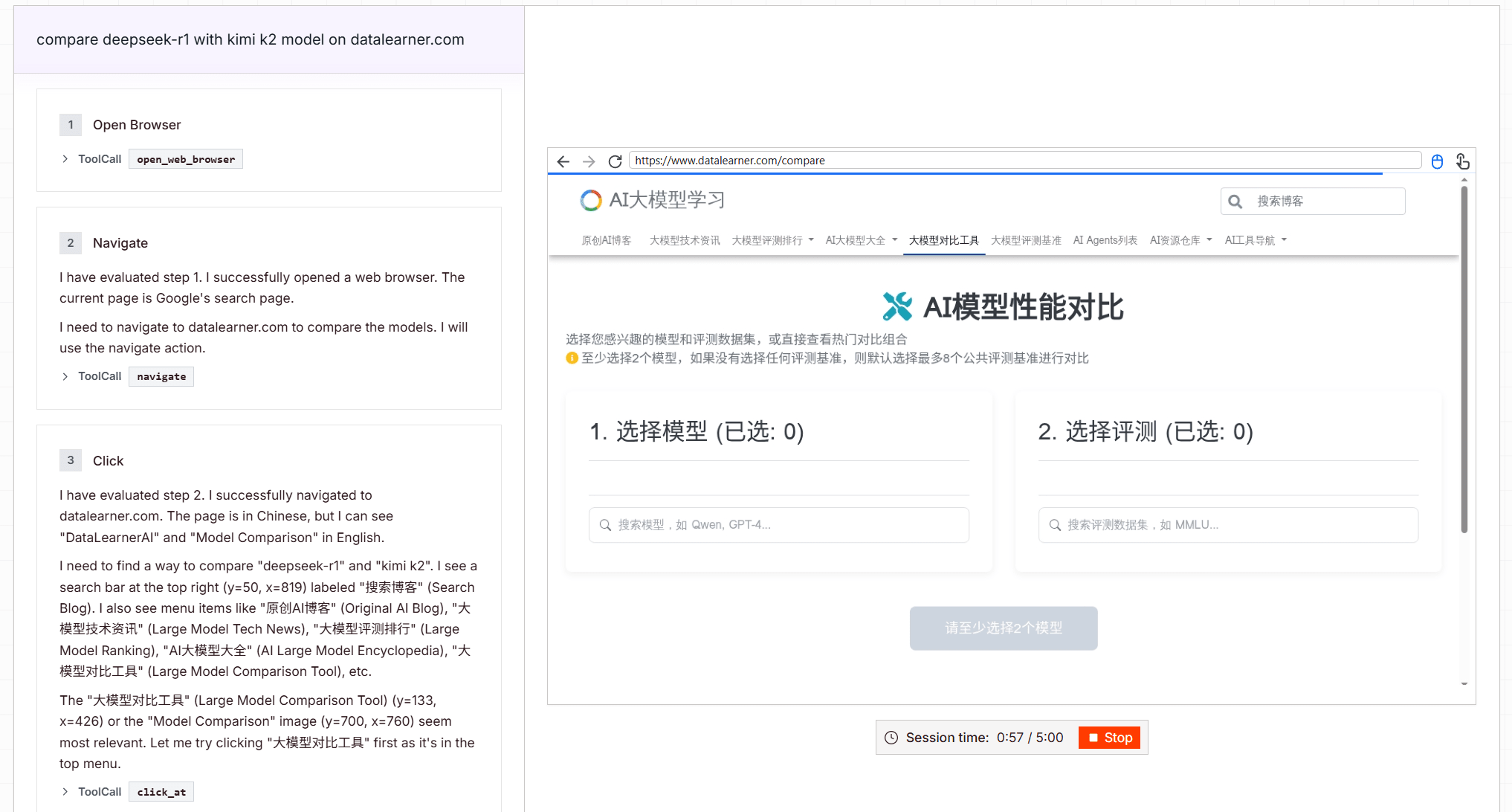

Gemini 2.5 Computer Use成功完成了我们的任务,主要过程截图如下:

上面的例子可以看出来Gemini 2.5 Computer Use模型是可以准确理解意图并进行操作的。显然,Gemini 2.5 Computer Use不太可能训练过我们DataLearnerAI的大模型对比工具功能(因为它才上线几个月),但是理解准确性还是不错的。

不过,整个过程用了5分钟,的确是有点慢!

四、Gemini 2.5 Computer Use模型最大的价值是从视觉分析到自主执行的智能闭环

Gemini 2.5 Computer Use 模型的核心在于其“计算机使用”工具(computer_use)。它接收用户请求、当前环境截图和近期动作历史作为输入,然后输出 UI 操作指令,如点击、输入或滚动。这些指令支持自定义函数扩展,甚至可排除敏感操作,确保灵活性。

Gemini 2.5 Computer Use模型最高支持 32K输入 和32K的输出长度,足以处理复杂多步任务,而其视觉推理能力让它能“读懂”屏幕元素,就像人类浏览网页一样。

具体来说包括:

视觉 + 上下文理解:识别界面元素结构

该模型能够从界面截图中识别按钮、输入框、下拉框、滑块、选单、页签等常用控件。它不仅识别控件的位置,还能理解控件的语义(比如“提交”、“登录”、“下一步”)。

这意味着:当页面复杂、有多个层级、控件标识文本不规则时,它仍能准确定位目标操作对象。举例:用户请求“在某个网盘页面点击‘上传’按钮”,模型可在视觉上确定哪个图标最可能是上传控件,并进行点击。

多步操作串联 + 状态回环感知

模型不是一次性操作,而是基于循环机制:每一步执行后拿到新的界面截图、URL 与历史动作,继续推理下一步。

这带来的好处是:即便中间页面跳转、加载延迟、异步刷新、错误弹窗出现,模型也能识别“当前状态 vs 预期状态”的差异,重新修正操作路径。这种反馈—修正—继续执行的闭环控制,是在复杂场景下稳定执行的关键。举例:如果点击“下一步”后出现验证码弹窗,模型能判断当前任务被阻断,可能触发用户确认或选择绕过策略。

高阶交互行为:拖拽、排序、筛选、登录、验证

除了点击与输入,Gemini 2.5 Computer Use模型还支持更加复杂的 UI 操作,例如:

- 拖拽与元素重排序:在可视化编辑画布、看板、图表界面中,模型可拖动组件、重新排列布局;

- 滤选与筛选控件:在下拉列表、复选框、滑块中做条件筛选;

- 登录与会话维持:模型可以模拟登录流程、填写账户/密码、处理验证码(在用户确认或授权的条件下)并保持会话状态连续;

- 高安全场景的确认策略:对于高风险操作(如支付、账户修改、权限变更等),模型可请求 用户确认 或开发者设定的安全策略。

五、Gemini 2.5 Computer Use的安全控制机制

为防范风险,Google 在模型层面与运行时均加入安全机制:

- 逐步安全服务(per-step safety):每个动作在客户端执行前,由一个独立服务校验其风险;

- 开发者策略指令:开发者可在策略层面指定某类操作必须询问用户确认 或 被拒绝(如绕过 CAPTCHA、控制设备、执行系统级操作等);

- 训练阶段内置安全策略:让模型本身“学习”拒绝高风险行为、识别 prompt 注入、避免滥用。

这些机制共同保证:即便模型能“动”界面,也不会越过权限边界或未经授权操作。

六、Gemini 2.5 Computer Use总结以及在线体验地址

目前,Gemini 2.5 Computer Use 已进入公共预览(Public Preview),开发者可通过 Gemini API 在 Google AI Studio 或 Vertex AI 中使用。

此外,在 Chrome 浏览器环境中,可在 Browserbase 提供的 Demo 环境中测试 Agent 行为效果。

总体而言,Gemini 2.5 Computer Use 模型 是 Google 在 UI 控制领域的一次重大突破。它使得 AI Agent 真正具备“看得见界面、能动界面、能恢复故障”的能力。这对于自动化办公、AI 助手、软件测试、工作流集成等应用有巨大潜力。

关于Gemini 2.5 Computer Use模型的其它信息和在线体验地址可以参考DataLearnerAI大模型信息卡地址:https://www.datalearner.com/ai-models/pretrained-models/gemini-2-5-computer-use-preview-10-2025