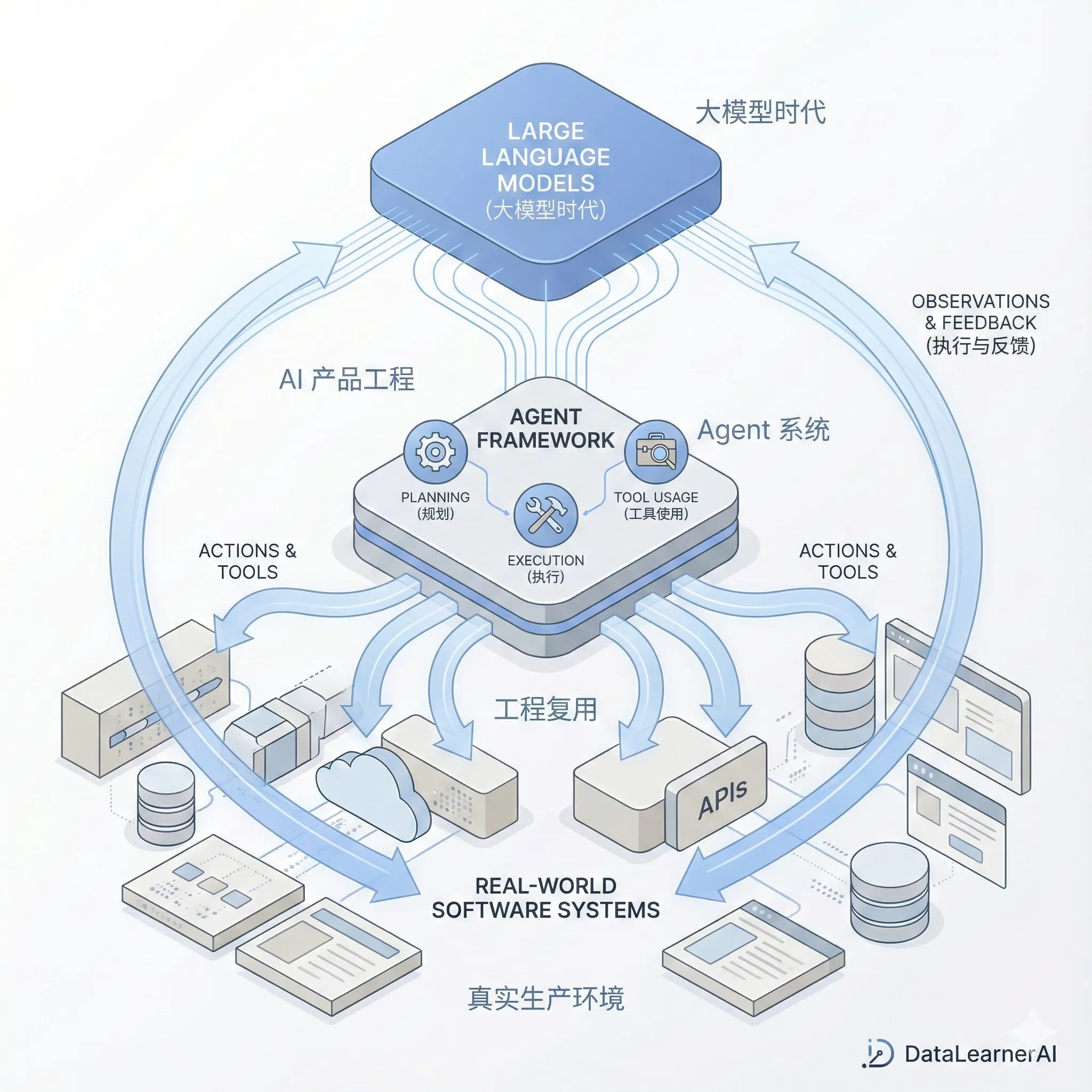

在大模型时代,AI 产品为什么更难复用?AI Agent产品应该如何开发?来自 Manus 的3个工程实践经验

最近,Manus 团队成员 Ivan Leo 在个人博客中发布了一篇题为 Three Lessons I’ve Learned at Manus 的文章,对自己在 Manus 工作期间的经历进行了系统回顾。

Manus 是一款面向真实生产环境的 AI Agent 产品。在极短时间内,这个团队完成了从早期产品形态到大规模商业化的跨越。根据作者在文中的描述,Manus 在 不到 8 个月的时间里实现了超过 1 亿美元的 ARR,这在当前 AI 应用层中属于极端少见的增长曲线。

Ivan Leo 本人并非外部观察者,而是一线工程成员。他加入 Manus 的时间 ,但在这段高度压缩的时间里,已经深度参与了多个关键功能的设计、实现与落地,包括用户触达功能、支付系统集成以及 API 与内部连接器相关的维护工作。