阶跃星辰StepFun开源激活参数只有11B的Step-3.5-Flash模型,但是评测结果和Kimi K2.5、Qwen3-Max-Thinking差不多,最高推理速度可以达到350tokens/s!

Stepfun AI(阶跃星辰)正式发布了其最新开源基础模型Step-3.5-Flash。这款模型以“快速、锐利、可靠的agentic智能”为核心设计,采用稀疏混合专家(Sparse MoE)架构,总参数量196B,但每token仅激活11B参数,实现高效推理的同时保持前沿级性能。它支持256K超长上下文、多token并行预测(MTP-3),推理速度可达100-300 token/s,甚至在编码任务中峰值350 token/s。

作为一款专为智能体(Agent)场景优化的开源模型,Step-3.5-Flash一发布便在多个agentic和编码基准上表现出色,有很多人测试反馈速度非常美好,前端也不错。

对比当前国内顶级闭源模型Moonshot Kimi K2.5(以下简称Kimi K2.5)和阿里通义Qwen3-Max-Thinking,Step-3.5-Flash在多项任务上接近或超越,但在资源占用和推理速度方面占据绝对优势。

Stepfun-Flash-3.5 vs Kimi-k2.5 vs Qwen3-Max模型核心特性对比

先看一下这三个模型的基本参数,参数量方面Stepfun-Flash-3.5最少,其他2个都是万亿参数规模,Stepfun-Flash-3.5只有1/5,激活参数方面也很少,只有11B。上下文长度256K,这一点Qwen3-Max-Thinking的100万还是有优势的:

Step-3.5-Flash的最大亮点在于高效agentic设计:它内置“Think-and-Act”协同、工具调用优化、多代理编排,以及边缘-云协同能力,支持本地部署(INT4量化后可在消费级硬件运行)。

关于三个模型更多的参数对比参考DataLearnerAI的大模型参数对比工具:https://www.datalearner.com/specs-compare/stepfun-flash-3-5/kimi-k2-5/qwen3-max

Stepfun-Flash-3.5 vs Kimi-k2.5 vs Qwen3-Max基准性能对比

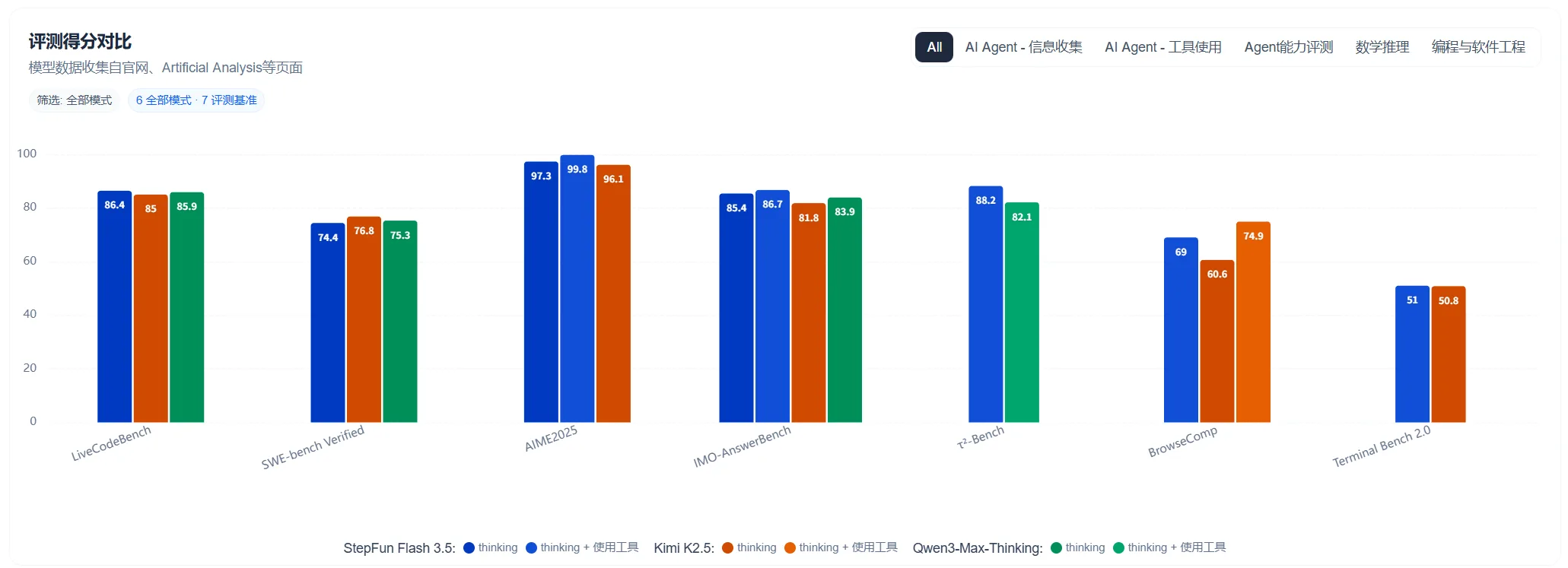

Step-3.5-Flash官方提供了多维度基准对比,这里我们主要对比前不久刚发布的另外2个过程大模型,分别是开源的Kimi K2.5和闭源的Qwen3-Max-Thinking:

简单来说,这三个模型的评测结果差距很小:

- 编码与agentic领域:Step-3.5-Flash在SWE-bench Verified达到74.4%,仅略低于Kimi K2.5的76.8%,但远高于Qwen3-Max的69.6%。在Terminal-Bench 2.0上微弱领先Kimi,显示出更强的终端操作和长链agent能力。同时,在τ²-Bench上大幅领先Kimi Thinking变体,证明其工具调用和多代理协同更高效。

- 数学与推理领域:Step-3.5-Flash在AIME、IMOAnswerBench等高中/国际数学竞赛基准上全面领先Kimi K2.5,显示出极强的逻辑推理能力(支持PaCoRe等增强后接近满分)。

- 其他agent亮点:Step-3.5-Flash在xbench-DeepSearch等深度研究任务上表现突出,支持多代理循环规划、搜索与合成,适合复杂投资分析、科研等场景。

不过,Step-3.5-Flash的优势很明显:活跃参数仅11B,推理成本比另外两个低很多。

Step-3.5-Flash总结

其实,最近开源模型发展很快,性能提升也很明显,但是动不动就万亿参数规模或者DeepSeek的6700多亿参数规模,成本实在是太高。本次Step-3.5-Flash最大的价值就是参数量不过,评测结果不错,成本很低。如果实测和评测差不太多,那基本上这个模型一定具有非常高的吸引力了。

关于 Step-3.5-Flash 更多信息参考DataLearnerAI模型信息卡:https://www.datalearner.com/ai-models/pretrained-models/stepfun-flash-3-5