CodeLlama-70B-Python - CodeLlama-70B-Python

模型详细情况和参数

CodeLlama-70B-Python

- 模型全称

- CodeLlama-70B-Python

- 模型简称

- CodeLlama-70B-Python

- 模型类型

- 编程大模型

- 发布日期

- 2024-01-30

- 预训练文件大小

- 140GB

- 是否支持中文(中文优化)

- 否

- 最高支持的上下文长度

- 100K

- 模型参数数量(亿)

- 700.0

- 模型代码开源协议

- Llama 2 Community License Agreement

- 预训练结果开源商用情况

- Llama 2 Community License Agreement - 免费商用授权

- 模型HuggingFace链接

- https://huggingface.co/codellama/CodeLlama-70b-hf

- 在线演示地址

- 暂无

- 基础模型

- 无基础模型

- 发布机构

CodeLlama-70B-Python 简介

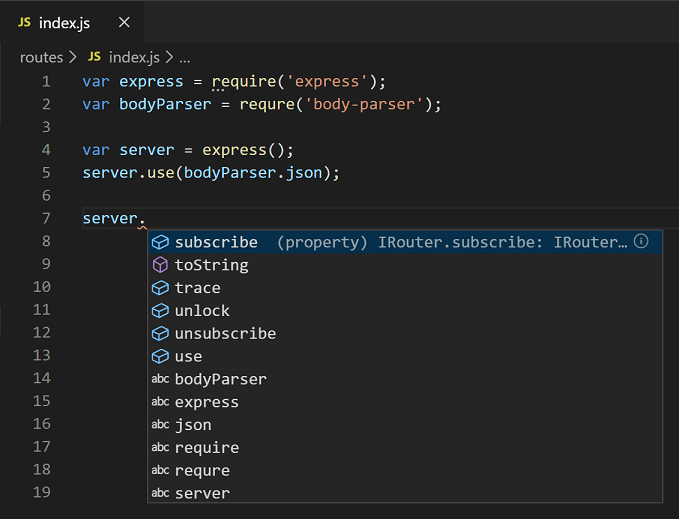

CodeLLaMA是基于Llama 2基础模型继续训练和微调得到的代码专用语言模型。相比完全从头训练,继承Llama 2的预训练带来明显提升。关于CodeLlama系列模型的介绍参考: https://www.datalearner.com/blog/1051692893755811

CodeLlama系列最早是在2023年8月份发布的。但是不包含700亿参数规模的大模型。在2024年1月30日,MetaAI开源了700亿参数规模版本的CodeLlama-70B,包含三个版本:

| CodeLlama-70B模型版本 | 模型简介 | DataLearner模型信息卡地址 |

|---|---|---|

| CodeLlama-70B-Base | CodeLlama-70B最基础的版本,支持不同的编程语言。 | 点击访问CodeLlama-70B-Base的模型信息卡 |

| CodeLlama-70B-Python | 针对Python编程语言优化的版本。 | 点击访问CodeLlama-70B-Python的模型信息卡地址 |

| CodeLlama-70B-Instruct | 指令优化的编程大模型,可以识别用户的文本指令生成代码。 | 点击访问CodeLlama-70B-Instruct模型信息卡 |

这里说的CodeLlama-70B-Python就是其中针对Python优化的版本。相比较基础版本的CodeLlama-70B-Base,它在更多的Python数据集上预训练。需要注意的是,基础版本的CodeLlama-70B-Base和CodeLlama-70B-Python都是代码补全大模型,没有对指令的优化。

CodeLlama系列模型的代码表现很好,本次开源的CodeLlama-70B系列提升更加明显,其中,基础版本的CodeLlama-70B-Base在HumanEval@1得分53.0分,指令优化版本最高得分67.8,超过了GPT-4论文中的得分(GPT论文分数67分,但是在微软的论文中测试结果是82分)。

根据官网的论文介绍,CodeLLaMA的特点如下:

- 通过长序列微调(long context fine-tuning),CodeLLaMA系列模型支持高达10万个tokens的输入文本,明显优于只支持4K的Llama 2。在非常长的代码文件中仍表现稳定。

- 在Python代码生成基准测试数据集如HumanEval和MBPP上取得最先进的成绩,尤其是与开源模型相比,基本是最强的。同时也在多语言数据集MultiPL-E上表现强劲。

- CodeLLaMA-Instruct通过自监督生成的代码数据进行指令细调,明显提高了模型的安全性、有用性和遵循指令的能力。

- 采用开源和允许商业用途的许可,可以让更多研究人员和企业基于CodeLLaMA进行创新,推动整个技术领域的进步。

欢迎大家关注DataLearner官方微信,接受最新的AI模型和技术推送

CodeLlama-70B-Python所属的领域

CodeLlama-70B-Python相关的任务