MetaAI官宣开源编程大模型CodeLLaMA!基于LLaMA2微调!超越OpenAI的Codex,最高支持10万tokens输入!

-----------2024年1月30日更新----------------- CodeLlama系列最早是在2023年8月份发布的。但是不包含700亿参数规模的大模型。在2024年1月30日,MetaAI开源了700亿参数规模版本的CodeLlama-70B,包含三个版本:

加载中...

| CodeLlama-70B模型版本 | 模型简介 | DataLearner模型信息卡地址 |

|---|

| CodeLlama-70B-Base | CodeLlama-70B最基础的版本,支持不同的编程语言。 | https://www.datalearner.com/ai-models/pretrained-models/CodeLlama-70B-Base |

| CodeLlama-70B-Python | 针对Python编程语言优化的版本。 | https://www.datalearner.com/ai-models/pretrained-models/CodeLlama-70B-Python |

| CodeLlama-70B-Instruct | 指令优化的编程大模型,可以识别用户的文本指令生成代码。 | https://www.datalearner.com/ai-models/pretrained-models/CodeLlama-70B-Instruct |

其中CodeLlama-70B-Instruct在HumanEval@ 1评分67.8,超过了GPT-4官方论文的成绩,详情可以参考上述模型信息卡地址内容。

据DataLearnerAI收集的大模型代码评测结果,我们可以看到CodeLlama-70B-Instruct成绩非常优秀。超过了了Gemini Pro:

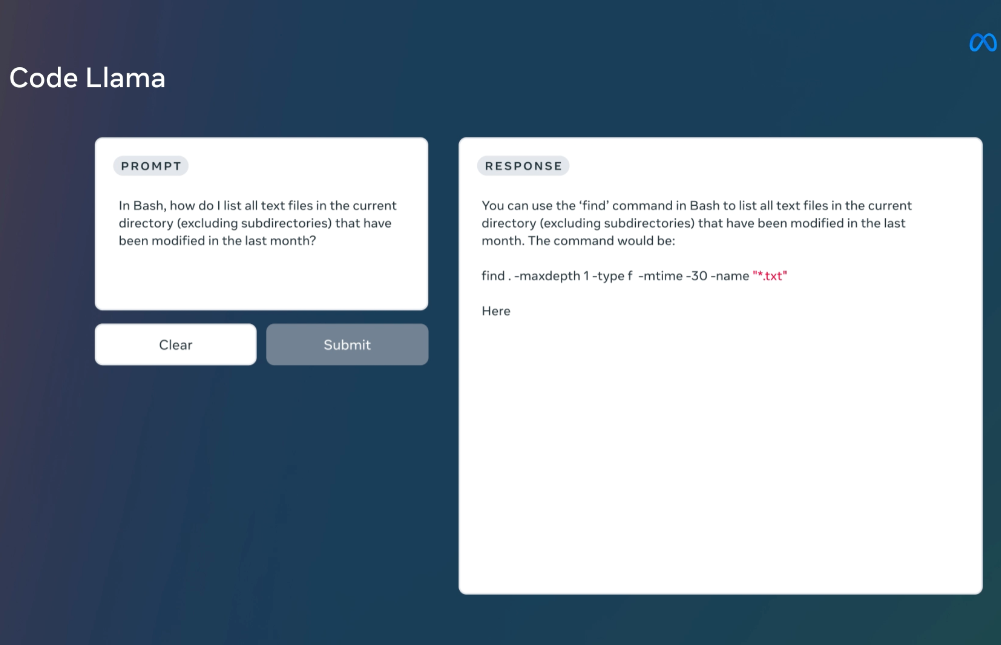

MetaAI发布的LLaMA系列开源大语言模型已经是开源大模型领域最重要的力量了。相当多的所谓开源大模型都是基于这个模型微调得到。在上个月,LLaMA2发布,吸引了全球非常多的关注,也有相当多的后续模型基于LLaMA2进行优化。而今天MetaAI再次开源全新的编程大模型——CodeLLaMA系列,这是MetaAI第一次发布编程大模型,本次发布的CodeLLaMA共有9个版本,分别是CodeLLaMA系列、针对Python优化的CodeLLaMA-Python系列和针对指令优化的CodeLLaMA-Instruct系列,每一个版本都包含3个参数版本,分别是7B、13B和34B。

Llama 2作为一个通用语言模型表现强劲,但直接应用到代码任务上还有进一步优化的空间。基于Llama 2进行代码专用的训练和调优,可以充分发挥其潜力。为此,MetaAI发布了CodeLLaMA系列。

CodeLLaMA是基于Llama 2基础模型继续训练和微调得到的代码专用语言模型。相比完全从头训练,继承Llama 2的预训练带来明显提升。

根据官网的论文介绍,CodeLLaMA的特点如下:

MetaAI发布的CodeLLaMA共包含3个版本9个模型,具体如下:

具体来说:

三个版本都提供了7B、13B和34B参数量的选择。 所以用户可以根据实际使用场景和参数量预算选择不同的版本。CodeLLaMA系列覆盖了从通用到专业、从基础到细调的不同需求。

如前所述,CodeLLaMA是在LLaMA2基础上微调得到。具体来说,CodeLLaMA系列是在原有LLaMA2基础上增加了5000亿tokens的数据集微调得到,这5000亿tokens数据中85%是代码数据,与代码有关的自然语言处理部分8%,数据集大小895GB。

而CodeLLaMA-Python系列则是在CodeLLaMA系列基础上继续增加1000亿tokens数据集微调得到。其中Python代码占75%。这部分数据集磁盘空间79GB。

MetaAI在多个测试中做了评测,主要结果如下:

总体来说,CodeLLaMA系列模型在公开可用的代码生成语言模型中取得了领先的效果。而且可以看到它比Codex和PaLM-Coder的表现都要好!

CodeLLaMA系列与LLaMA2的开源协议完全一样,可以免费商用授权。不过目前没有把预训练结果放到HuggingFace上,而是要去官网申请,申请速度也很快。

具体的代码地址和其它信息参考DataLearner模型信息卡:

| - |

| - |

| PaLM-Coder | 540B | 35.9% | - | 88.4% | 47.0% | - | - |

| PaLM 2-S | - | 37.6% | - | 88.4% | 50.0% | - | - |

| StarCoder Base | 15.5B | 30.4% | - | - | 49.0% | - | - |

| StarCoder Python | 15.5B | 33.6% | - | - | 52.7% | - | - |

| StarCoder Prompted | 15.5B | 40.8% | - | - | 49.5% | - | - |

| Llama 2 | 7B | 12.2% | 25.2% | 44.4% | 20.8% | 41.8% | 65.5% |

| Llama 2 | 13B | 20.1% | 34.8% | 61.2% | 27.6% | 48.1% | 69.5% |

| Llama 2 | 34B | 22.6% | 47.0% | 79.5% | 33.8% | 56.9% | 77.6% |

| Llama 2 | 70B | 30.5% | 59.4% | 87.0% | 45.4% | 66.2% | 83.1% |

| Code Llama | 7B | 33.5% | 59.6% | 85.9% | 41.4% | 66.7% | 82.5% |

| Code Llama | 13B | 36.0% | 69.4% | 89.8% | 47.0% | 71.7% | 87.1% |

| Code Llama | 34B | 48.8% | 76.8% | 93.0% | 55.0% | 76.2% | 86.6% |

| Code Llama - Python | 7B | 38.4% | 70.3% | 90.6% | 47.6% | 70.3% | 84.8% |

| Code Llama - Python | 13B | 43.3% | 77.4% | 94.1% | 49.0% | 74.0% | 87.6% |

| Code Llama - Python | 34B | 53.7% | 82.8% | 94.7% | 56.2% | 76.4% | 88.2% |

| Code Llama - Instruct | 7B | 34.8% | 64.3% | 88.1% | 44.4% | 65.4% | 76.8% |

| Code Llama - Instruct | 13B | 42.7% | 71.6% | 91.6% | 49.4% | 71.2% | 84.1% |

| Code Llama - Instruct | 34B | 41.5% | 77.2% | 93.5% | 57.0% | 74.6% | 85.4% |

| 从表格可以看出: |

| CodeLLaMA-Python-34B | https://www.datalearner.com/ai-models/pretrained-models/CodeLLaMA-Python-34B |

| CodeLLaMA-Instruct-7B | https://www.datalearner.com/ai-models/pretrained-models/CodeLLaMA-Instruct-7B |

| CodeLLaMA-Instruct-13B | https://www.datalearner.com/ai-models/pretrained-models/CodeLLaMA-Instruct-13B |

| CodeLLaMA-Instruct-34B | https://www.datalearner.com/ai-models/pretrained-models/CodeLLaMA-Instruct-34B |