分解机(Factorization Machine, FM)模型简介以及如何使用SGD、ALS和MCMC求解分解机

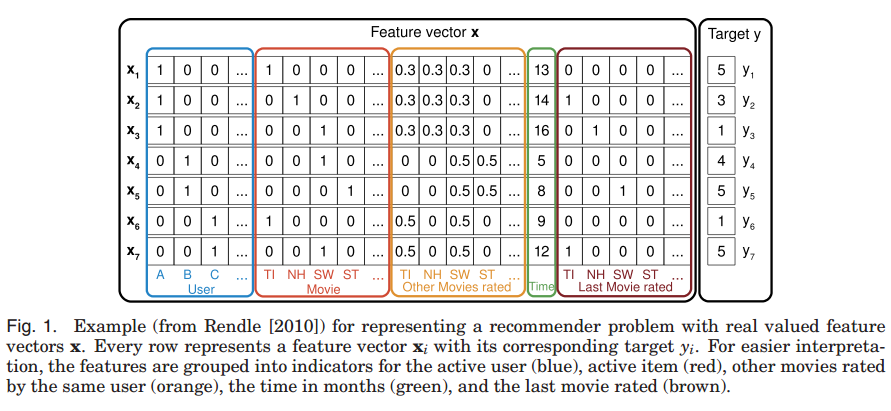

因子分解法在很多预测问题上都有很好的准确性。但是分解模型运用在一个新的问题上并不是一个简单的事情。目前有很多的分解模型,最流行的应该是矩阵分解(Matrix Factorization, MF)。这是预测两个分类变量之间关系的模型。类似的,张量分解(Tensor Factorization,TF)是矩阵分解的扩展,它可以预测多个分类变量之间的关系,张量分解有很多例子,如Tucker Decomposition,Parallel Factor Analysis以及Pairwise Interaction Tensor Factorization等。除了分类变量,还有如SVD++、STE、FPMC、BPTF等等可以用来处理非分类的变量(这些模型都可以去原文找到对应的,基本上做矩阵分解的人应该都知道类似的原理大约是什么样子的)。作者列举了这么多方法的原因就是想说明,针对新的问题,我们总是需要设计新的模型来求解,这是很耗费时间的。因此,作者提出了一个新的模型,即分解机模型(Factorization Machine, FM),这是一个通用的方法,它可以通过特征工程来模仿大多数分解模型。据此,作者还提出了一个和LIBSVM很相似的通用的工具——LIBFM来帮助大家解决因子分解法的模型的应用。