开源大语言模型再次大幅进步:微软团队开源的第二代WizardLM2系列在MT-Bench得分上超过一众闭源模型,得分仅次于GPT-4最新版

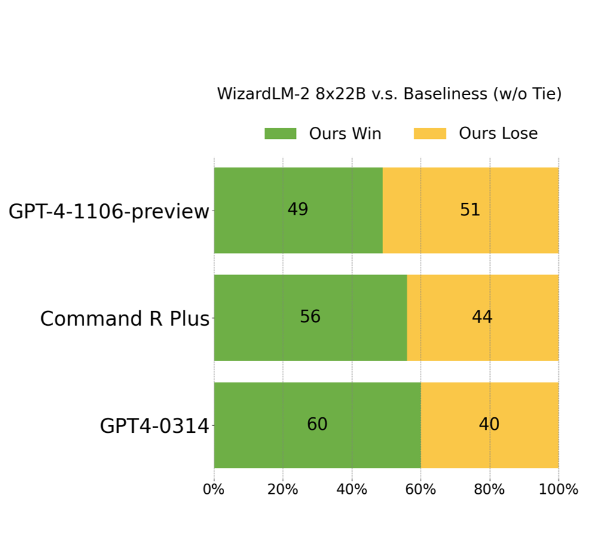

开源大模型是促进大模型技术发展最重要的技术力量之一。此次,微软以Apache 2.0开源协议开源了一个在ChatArena匿名投票评测上打败GPT-4早期版本的模型,即WizardLM-2。这是一系列模型,其中最大的版本是基于Mixtral-8×22B开源模型进行后训练得到的模型。MT-Bench得分8.96,超过了GPT-4-0314。

加载中...

开源大模型是促进大模型技术发展最重要的技术力量之一。此次,微软以Apache 2.0开源协议开源了一个在ChatArena匿名投票评测上打败GPT-4早期版本的模型,即WizardLM-2。这是一系列模型,其中最大的版本是基于Mixtral-8×22B开源模型进行后训练得到的模型。MT-Bench得分8.96,超过了GPT-4-0314。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

WizardLM最早是由北京大学的童鞋开源的成果。是基于Evol-Instruct方法得到的指令数据集进行微调得到的。Evol-Instruct是一种用来生成复杂的多样化指令数据集的方法。给定初始的指令数据集,通过一步步的改写的阿斗更加复杂和多样的指令数据,这样的数据用于大模型的微调可以极大提高模型的能力。

WizardLM系列包含很多个模型,而本次开源的WizardLM系列则是第二代。其能力的提升也非常明显,而基座模型也换成了当前最强的三个开源模型,分别是Mixtral-8×22B、Llama2-70B和Mistral 7B。

由于当前作者没有开放论文,暂不清楚第二代模型和第一代模型的方法上的具体差别。不过,作者提到,WizardLM2系列模型在复杂的对话、多语言、推理和agent等能力上都有非常多的进步。

在2024年4月初,CohereAI开源的Command R+是第一个在ChatArena上打败早期GPT-4版本的开源大模型,不过它不可以商用(参考:开源模型进展迅猛!最新开源不可商用模型Command R+在大模型匿名投票得分上已经超过GPT-4-Turbo!)。

而微软开源的WizardLM-2系列则是以更加友好的开源协议开源的新一代的大语言模型。目前WizardLM-2系列包含3个版本:

可以看到,WizardLM-2是基于当前最优秀的开源模型进行后训练(post-training)得到的模型。

根据描述,WizardLM-2 8x22B是WizardLM-2系列中最先进的模型,在复杂任务处理上最强。WizardLM-2 70B模型则是在推理能力上到了top-tie水平,由于这个模型比前者的显存要求降低了一半,因此是性价比更高的模型。

而WizardLM-2 7B模型则是最快的,但是能力上超过了许多700亿参数的开源模型。

目前,官方还没有公布详细的评测结果。主要公布了MT-Bench以及人工评估的结果。

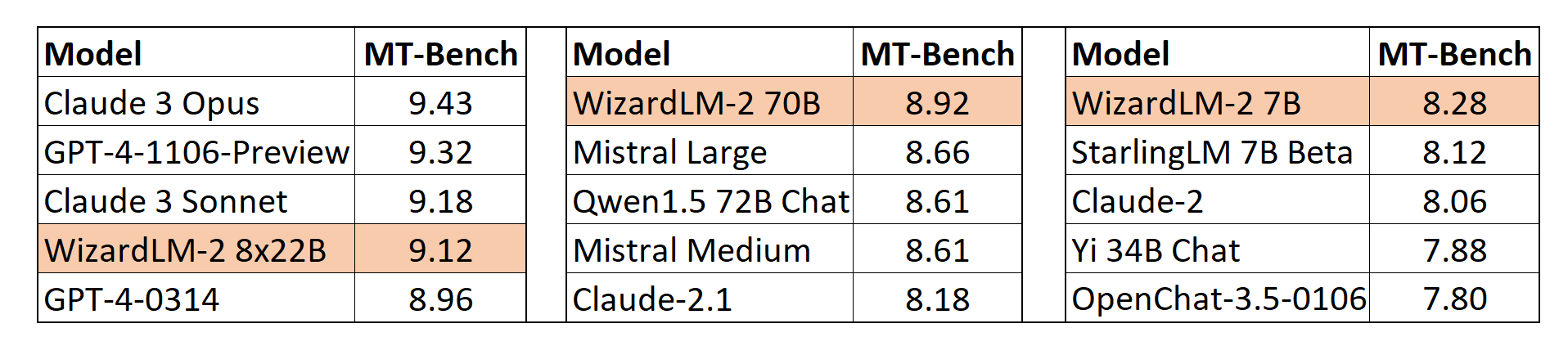

其中MT-Bench是一个非常有挑战性的多轮对话评测数据集,也是由LM-SYS推出的。在MT-Bench的评测结果上,WizardLM-2 8x22B得分9.12分,仅次于GPT-4和Claude-3,超过了GPT-4-0314的得分!也是唯一一个超过了9分的开源大模型。

而WizardLM-2 70B则也是超过了众多700亿参数的模型,包括开源的Qwen1.5-72B以及闭源的Mistral-Large和Claude-2.1。Wizard-7B则是目前最强的70亿参数模型,得分8.28。

根据DataLearnerAI收集的全球大模型评测结果,WizardLM-2 7B模型在MT-Bench得分上接近Qwen1.5-32B,非常厉害。

就在WizardLM-2开源几个小时后,官方删除了所有信息,后来作者澄清是发布过程没有做投毒测试,所以撤回。等到走完所有流程,就会再次发布。

需要注意的是,本次开源WizardLM-2系列的三个模型中,基于MistralAI开源的2个模型进行微调得到的WizardLM-2 8x22B和WizardLM-2 7B开源协议是Apache2.0,非常友好。而WizardLM-2 70B由于是基于MetaAI开源的Llama2-70B进行微调的,开源协议为Llama2的开源协议,其中最重要的一个是,Meta公司说,它们的模型遵从贸易合规:

Your use of the Llama Materials must comply with applicable laws and regulations (including trade compliance laws and regulations) and adhere to the Acceptable Use Policy for the Llama Materials (available at https://ai.meta.com/llama/use-policy), which is hereby incorporated by reference into this Agreement.

这意味着并不是所有公司都可以使用,所以国内应该很多公司都无法使用!