开源模型进展迅猛!最新开源不可商用模型Command R+在大模型匿名投票得分上已经超过GPT-4-Turbo!

开源大语言模型经过一年多的发展,终于有一个模型可以在权威榜单上击败GPT-4的较早的版本,这就是CohereAI企业开源的Command R+。这是一个开源但是不允许商用的模型,参数规模达到1040亿,也是目前为止开源参数规模最大的一个模型。

加载中...

GPT-4是当之无愧的全球最强的大语言模型,尽管最近的Claude3-Opus在部分场景被认为是超过了GPT-4的表现,但是作为一个一年前发布、两年前完成的模型,GPT-4是大模型最强代表。

开源模型虽然经过一年多的发展,但是在各个评测和反馈中,总体上还是落后于闭源商业模型。至于超过GPT-4的开源模型,还没有出现。但是,在今天刚公布的LM-SYS的大模型匿名评测竞技场得分上,CohereAI的Command R+模型已经超过了GPT-4-0314和GPT-4-0613两个早期版本的GPT-4。

Command R+是由CohereAI开源并发布的一个大语言模型,包含了1040亿参数,是目前开源的大模型中参数数量最高的一类。发布于2024年4月4日,与最近爆火的MoE架构模型不同,Command R+是一个完完全全的1000亿参数规模的大模型。

Command R+发布的时候,CohereAI并没有和其它模型一样强调它在MMLU、GSM8K等评测基准上的表现,也没有公布常规的评测得分。他们更加强调的是这个模型是针对企业级大模型应用场景,如检索增强生成(Retrieval Augmented Generation,RAG)和工具使用等。

RAG全称是检索增强生成,是一种让大模型基于检索结果生成答案的技术。它在解决超长上下文、私域知识访问、减少幻觉的方面都有非常好的潜力,是企业大模型应用最重要的方向之一。CohereAI强调Command R+特别针对检索增强生成训练,可以提供行内的索引生成以降低幻觉,提高检索增强的准确性。

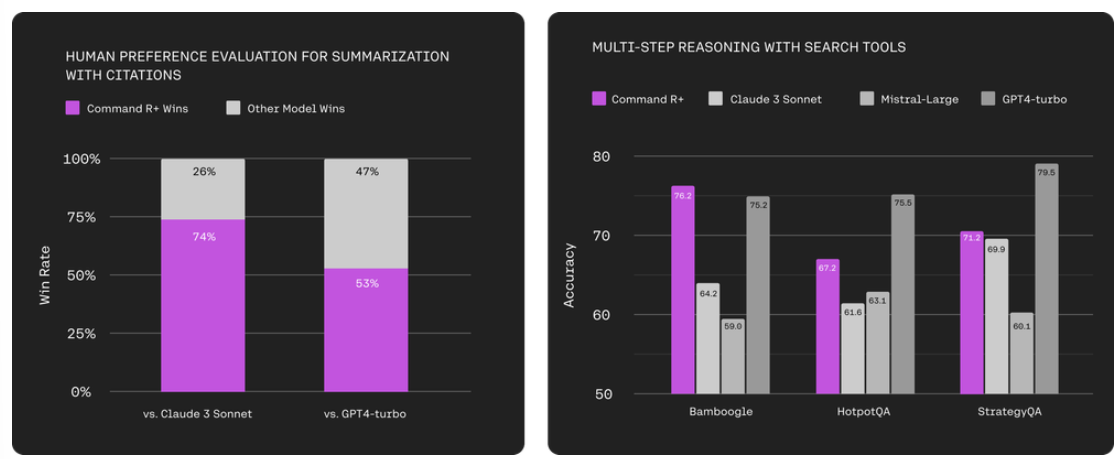

下图是Command R+与Claude 3 Sonnet和GPT-4-Turbo的模型在文本摘要和推理能力的对比

其中,前者是基于人工评价的摘要总结,重要的是考虑原始文本的引用。后者则是使用搜索工具做推理的准确性,基于大模型驱动的多步骤ReAct智能体在访问相同的搜索工具:即维基百科(HotpotQA)和互联网(Bamboogle和StrategyQA检索)时的准确性。

结果显示Command R+在RAG的表现是超过了Claude 3 Sonnet以及Mistral-Large,比GPT-4-Turbo略差。需要注意的是,前者不是当前市场上主流的公开评测,而是CohereAI自己收集的并采用人工评估的一个测试结果。主要针对文本的流畅程度、引用的指令以及有用性进行评估。数据集包含250个高度多样化的文本和复杂的摘要指令。

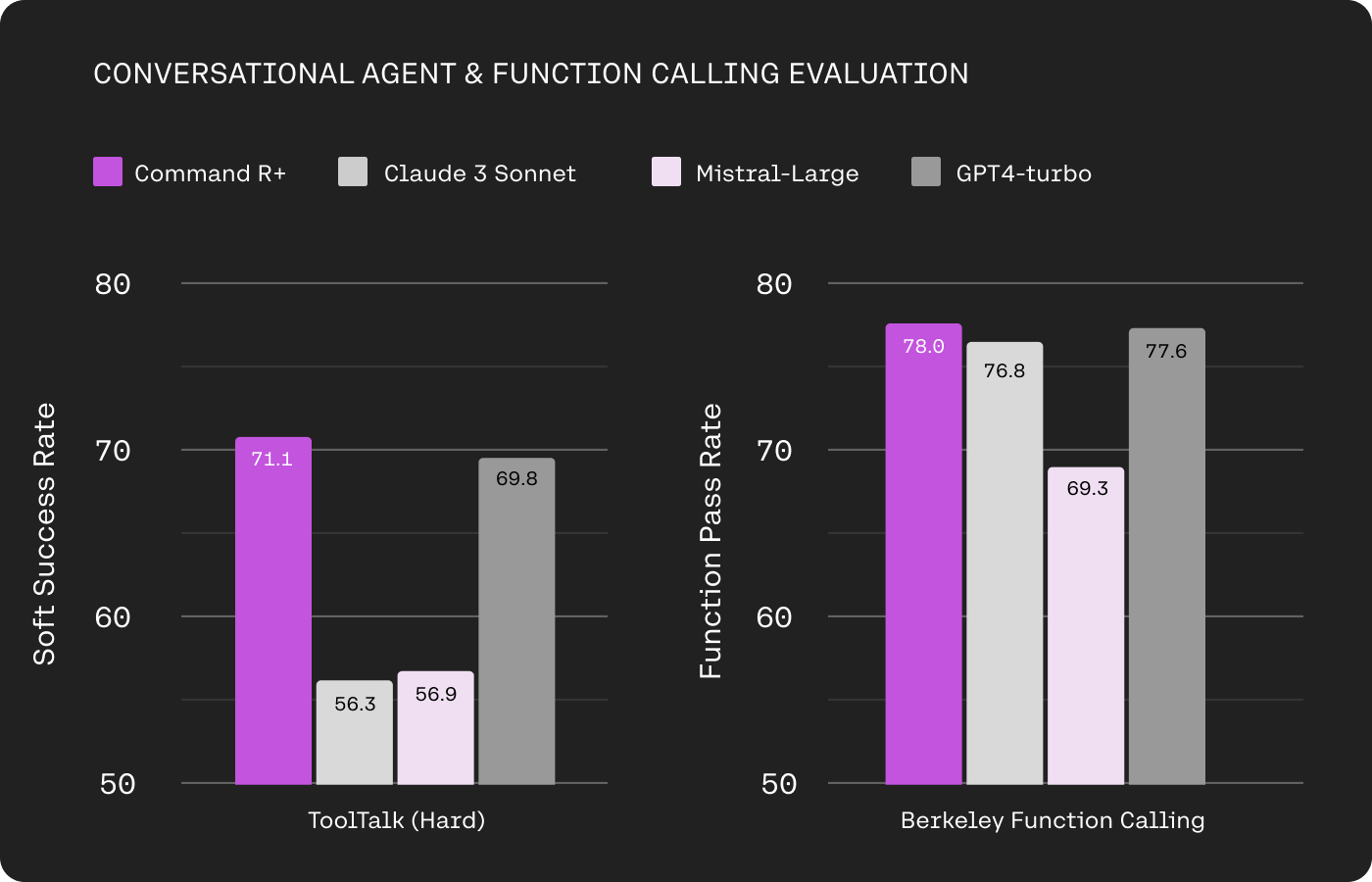

除了RAG能力外,Command R+在工具使用上也非常出色。首先,Command R+支持多步骤工具使用,意味着模型可以联合多个工具,并设计多个步骤来完成复杂的任务。甚至在调用工具出错的时候,Command R+还能自我更正并尝试其它途径。CohereAI在不同的工具使用能力数据集上做了评测:

这里的第一个评测是来自微软的大模型工具使用能力评测基准,ToolTalk,里面定义了28个工具。通过模拟用户对话测试大模型工具的使用能力(关于ToolTalk的详细情况参考: ToolTalk:微软发布的一个用以评测大语言模型工具使用能力的评测工具和评测数据集 )。这里可以看到,Command R+在工具使用能力上远超Claude 3 Sonnet和Mistral Large,也是略好于GPT-4-Turbo。

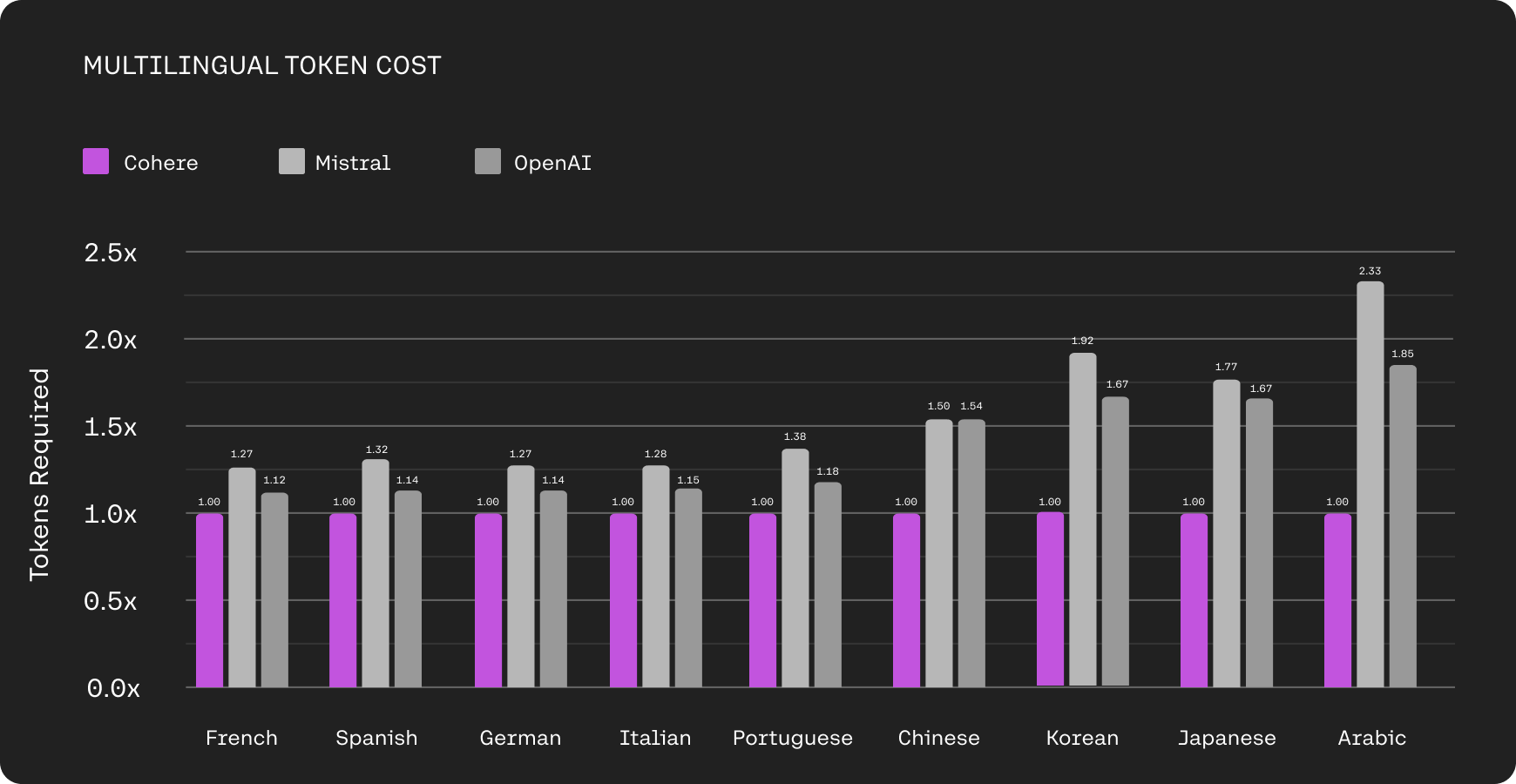

Command R+模型支持10种全球主要的语言,包括英语、法语、西班牙语、意大利语、德语、葡萄牙语、日语、韩语、阿拉伯语和中文。CohereAI强调,Command R+模型不仅在这10种语言上表现很好,在非拉丁语言的压缩上也很不错。

以中文为例,OpenAI的tokenizer产生的tokens数量是Command R+的1.54倍,这意味着,Command R+可以用更少的tokens来表示中文,有更高的tokens压缩比。

高tokens压缩比意味着模型能够用更少的tokens表达相同的语义内容,换言之,大模型可以表现出更高的表达效率。

这种优势主要来自于:

较高的tokens压缩比通常被视为更好的语言模型的一个特征:

从这些分析看,Command R+多语言能力很优秀。

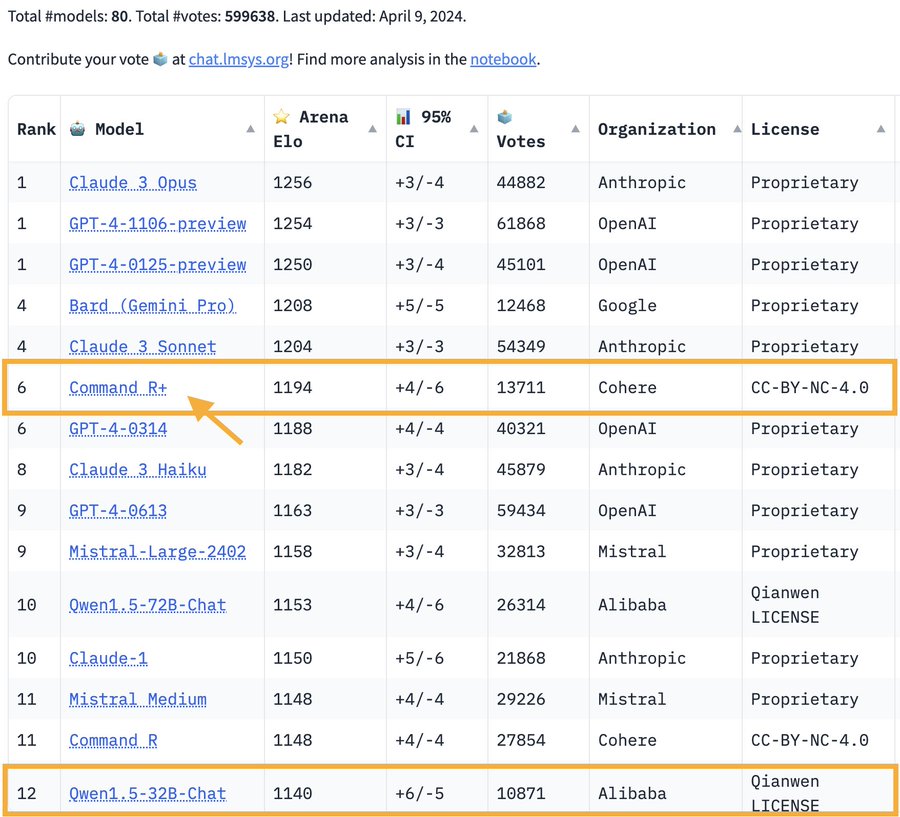

大模型匿名竞技场Chatbot Arena是由LM-SYS推出的一个大模型匿名投票评测系统。即用户可以通过发送一个问题获得多个模型的回复。用户可以根据回复结果进行投票以获得大家在不同问题上对不同模型答案的偏好。以此来测试模型之间的好坏。这是一种众包评分系统。

上图是最新一期的投票结果。可以看到,推出1周后,Command R+模型获得了1.3万次的投票,Arena Elo得分1194,是目前开源模型中得分最高的模型,总排行第6!而阿里的Qwen1.5-72B模型则是开源领域第二强的模型。Command R+也是开源模型中唯一一个超过了GPT-4两个早期版本的模型。

不过需要注意的是,ChatbotArena的数据来自全球不同网友的匿名评测结果。这种评测的问题大多数都是相对不那么复杂的应用或者测试。因此,虽然Chatbot Arena的评测结果非常接近大家平时使用模型的感受,但是它很难代表在复杂的场景中的应用。即使如此,Command R+作为第一个在这种评测超过GPT-4早期版本的模型,也是非常值得期待开源模型未来的表现!

虽然Command R+模型在Chatbot Arena中获得了非常好的结果。但是它并不是一个可以免费商用的模型,CohereAI开源了Command R+的预训练结果,但没有授权免费商用。

原因是CohereAI与各家云服务厂商合作提供了SaaS接口调用服务,希望通过这种方式获得影响力、开源贡献的同时,可以获得收入以支持公司的进一步发展。而这方面看,Qwen1.5-72B则更加友好,它允许免费商用,表现也不错。

Command R系列目前有2个模型,除了本文前面介绍的Command R+外,在2024年3月份,CohereAI还开源了一个350亿参数的Command R模型,该模型在Chatbot-Arena得分1148,与Mistral Medium一样,排名第11。

Command R+的开源下载地址和其它信息参考DataLearnerAI模型信息卡:https://www.datalearner.com/ai-models/pretrained-models/c4ai-command-r-plus

Command R的开源下载地址和其它信息参考DataLearnerAI模型信息卡:https://www.datalearner.com/ai-models/pretrained-models/c4ai-command-r-v01

关于CohereAI企业的介绍参考:https://www.datalearner.com/ai-organizations/cohere-ai