大模型速度、效果与价格的完美结合?xAI发布Grok 4 Fast:性能接近Grok 4,成本降 98%,生成速度翻倍!

xAI 正式发布 Grok 4 Fast —— 一款以 极致性价比与前沿性能 为核心卖点的新一代推理模型。相比前代产品,它不仅在推理准确率上几乎与旗舰模型Grok 4等持平,还凭借 40%更高的推理效率 和 高达98%的成本降低,将高质量智能推理真正带入大众用户和企业应用场景。

在当前 AI 模型竞逐的关键节点,Grok 4 Fast 的出现无疑是一场 革命性突破:它让“小而强”的模型不再是折衷,而是成为现实的最佳解。

Grok 4 Fast最高支持200万tokens上下文,一个模型支持推理和非推理两种模式。Grok 4 Fast也是一个多模态大模型,支持文本和图片的输入,目前只支持文本的输出。

为什么需要 Grok 4 Fast:解决推理的“成本悖论”

在过去几年里,大型语言模型的升级路径几乎都围绕着“更大、更强”展开。参数量、训练数据和推理深度不断增长,性能确实提升了,但代价也同样惊人:高昂的计算成本、庞大的延迟,以及对用户端不可忽视的价格压力。

Grok 3 Mini 尝试过提供轻量化替代方案,但在复杂推理任务中仍存在明显差距。Grok 4 则是旗舰级选择,表现顶尖,却意味着昂贵的成本和较高的门槛。

Grok 4 Fast 正是为打破这一“性能与成本的悖论”而生。 它通过大规模强化学习策略,最大化了所谓的“智能密度”——即在相同的推理步骤中产生更高质量的思维链,从而用更少的计算实现更优的结果。

换句话说:同样的题,别人要写两页草稿才能解出来,Grok 4 Fast 只需要半页,却正确率相同。

Grok 4 Fast的核心亮点:效果几乎与Grok 4持平,但是推理tokens减少40%

从公开测试数据来看,Grok 4 Fast 的竞争力几乎可以用“压倒性”来形容。主要是其价格太低,速度太快,但是效果很好。

Grok 4 Fast的评测结果几乎持平Grok 4

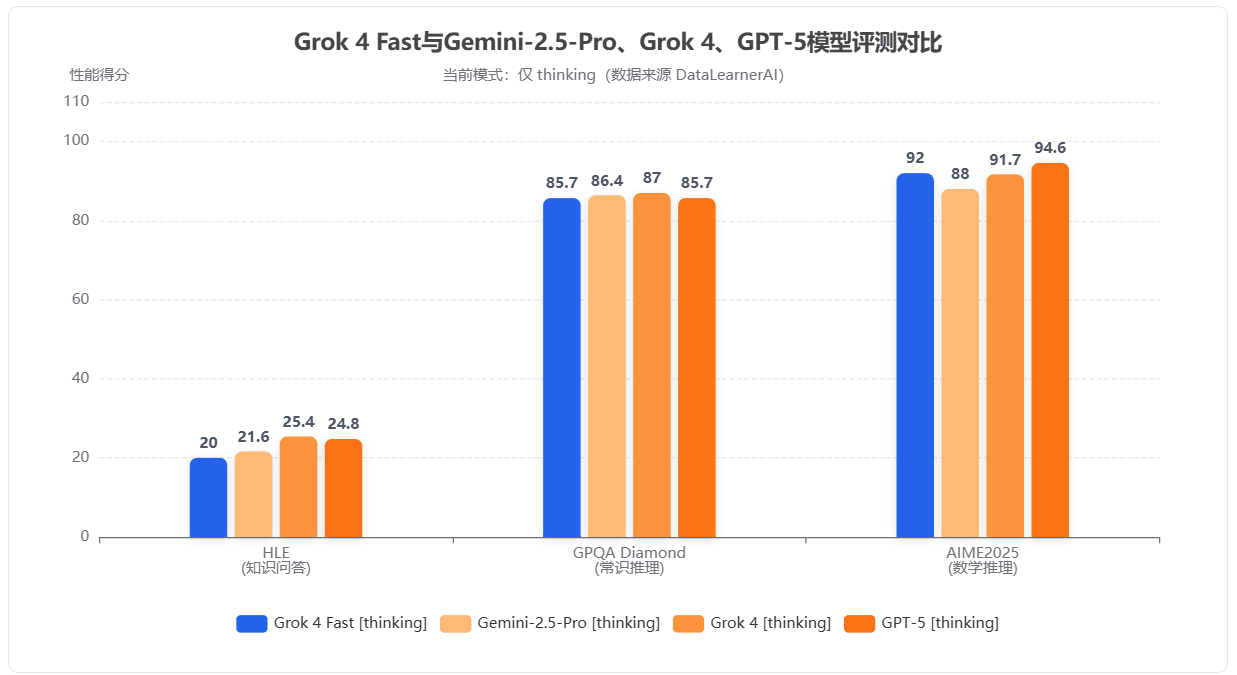

首先我们看一下Grok 4 Fast在不同评测集的效果。

与当前主流的Fast版本模型不同,当前大多数模型的Fast版本都是量化或者更小参数规模版本。因此性能损失都是比较明显的。然而,Grok 4 Fast似乎不太一样。它在某些测试结果上,甚至好于Grok 4的结果。在 AIME 2025 数学竞赛数据集上,它取得 92.0% 的正确率,超过了 Grok 3 Mini 的 83.0%,略高于旗舰 Grok 4(91.7%)。而且其它评测与主流模型相比也基本没有差别。

Grok 4 Fast的推理速度比Grok 4提升5倍多

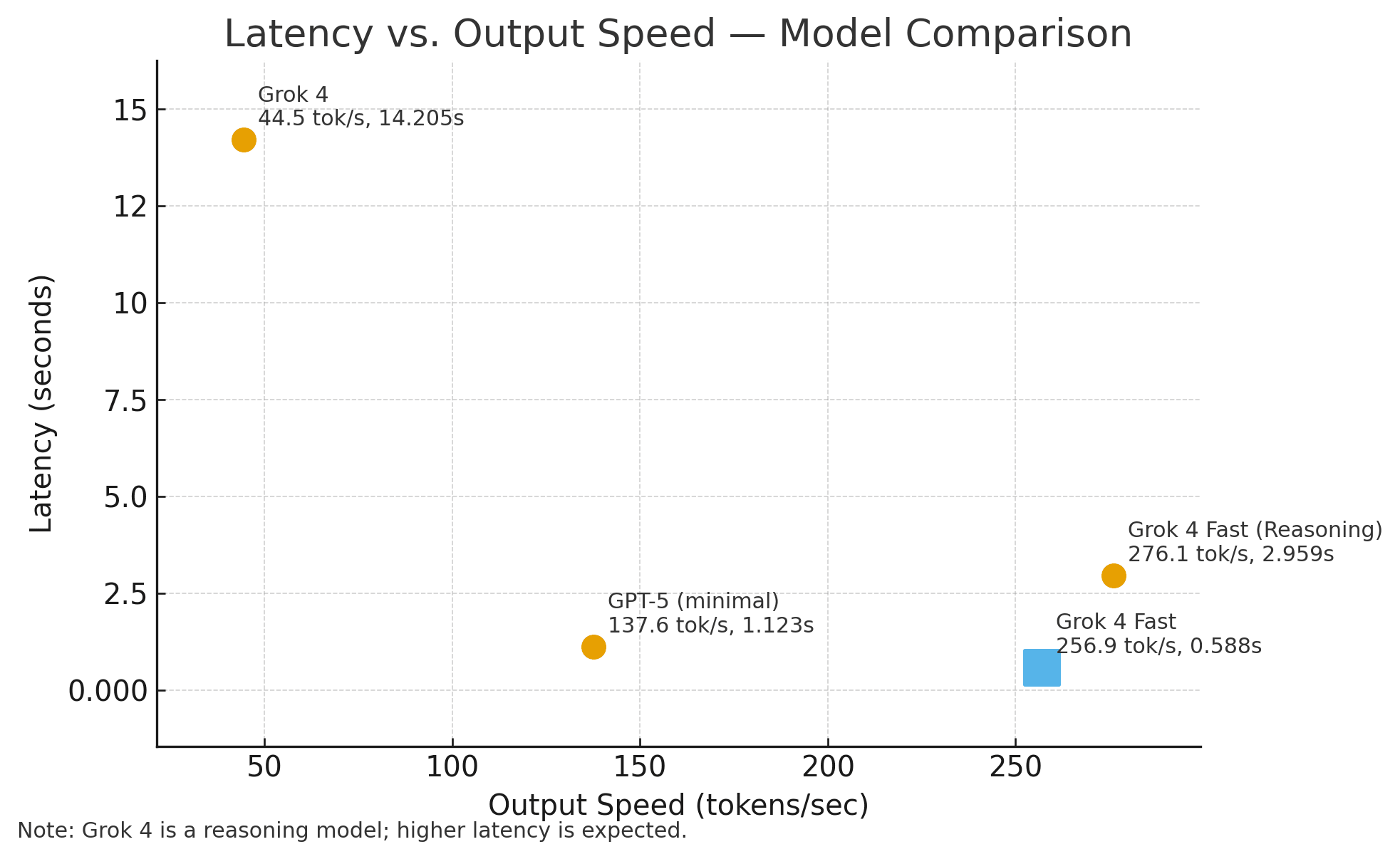

但是,上述评测结果不是最重要的,最重要的是Grok 4 Fast模型的推理速度和价格。首先,我们看一下推理速度对比:

该数据来自Artificial Analysis。从上图我们可以看到,Grok 4 Fast在响应延迟(Latency)上表现出色,首字符时延仅0.588秒左右。而其输出速度(OutputSpeed)极快,达到了250 tokens/y以上,远超Grok 4和GPT-5。这个速度实在是让人惊喜!而Grok 4的推理速度只有44 tokens/s左右。

除了推理速度外,Grok 4 Fast也强调了其“智能密度”,即Grok 4 Fast可以以更少的tokens数获得相同的效果。如下图所示:

根据官方的数据,Grok 4 Fast可以使用比Grok 4少40%的tokens数获得差不多水平的结果!这样的知识密度不管是对价格还是推理速度来说都非常有益!

Grok 4 Fast接口价格下调90%以上

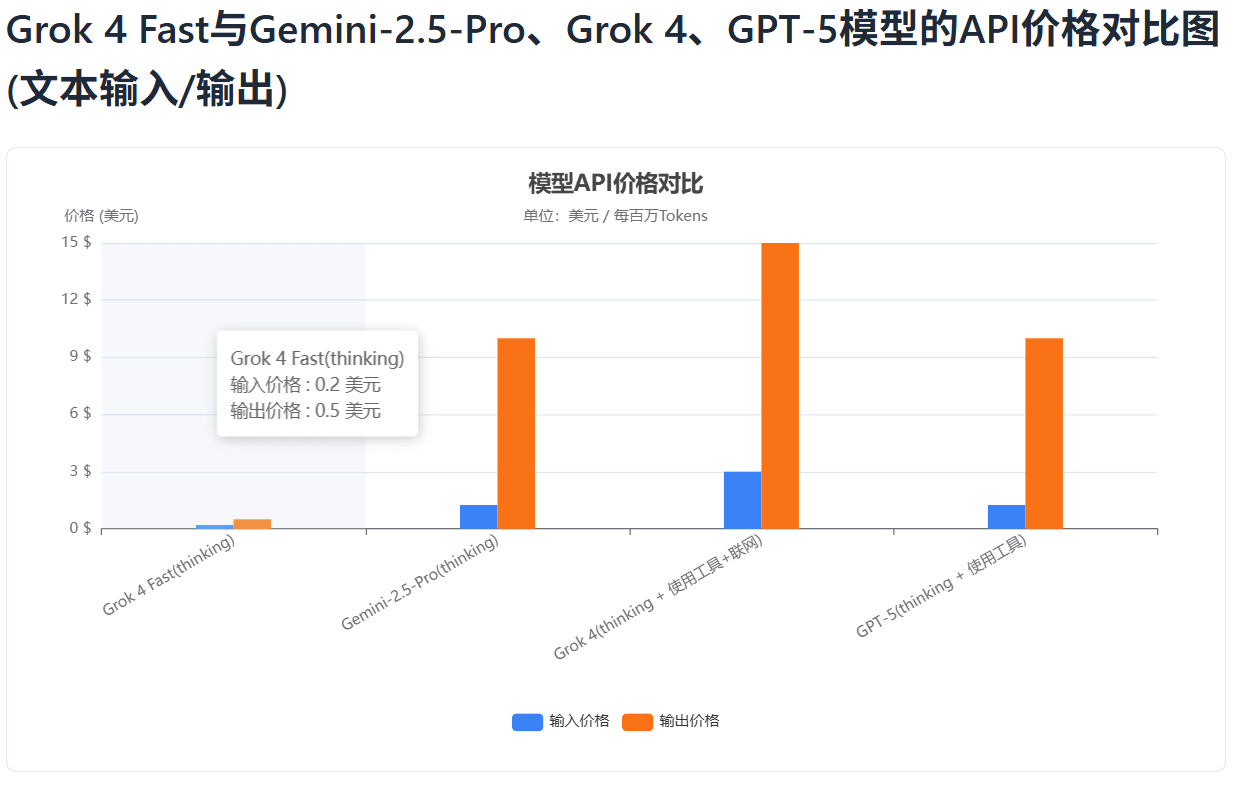

此外,xAI还将Grok 4 Fast价格下调了90%以上,如下图所示,我们展示了Grok 4 Fast价格相比主流最强模型的对比:

与 Grok 4 相比,Grok 4 Fast 在定价上实现了断层式下调:

- 输入价格:从 $3.00 / 1M tokens 直降到 $0.20 / 1M tokens,降幅超过 93%。

- 输出价格:从 $15.00 / 1M tokens 下降到 $0.50 / 1M tokens,降幅高达 96.7%。

而根据独立机构 Artificial Analysis 的评测,Grok 4 Fast 在 智能价格比(price-to-intelligence ratio) 上实现了业界最佳表现——与 Grok 4 相比,同等性能的价格下降幅度高达98%。

更直观地说:如果把达到同样智能水平的运行成本定为 100 美元,Grok 4 Fast 只需要 2 美元。

Grok 4 Fast的原生搜索能力

Grok 4 Fast 是首批经过端到端工具使用强化学习训练的模型之一,能自主决定何时调用浏览器或代码执行工具。

它的搜索能力尤其突出:

- 在 BrowseComp 中文测试集 上正确率达到 51.2%,远超前代 Grok 4 的 45.0%。

- 在 X 平台多跳搜索测试(X Browse) 中达到了 58.0%,领先于几乎所有同级别对手。

具体案例:当被问到“Path of Exile 2 升到满级需要多少经验值”时,Grok 4 Fast 会自动检索 Reddit、Wiki、PoE2 数据库,综合信息后给出 4,250,334,444 点经验 的精确结果。

这意味着,它不仅能“知道答案”,还能“找到答案”。

一个看似“反常”的定价细节:为什么Grok 4 Fast输出价只有输入价的2.5倍?

在行业里早已形成一种“默认”:大模型的输出价格,通常是输入价格的 5–10 倍,这并不只是“想多赚”,而是由技术开销与商业治理共同决定的。而 Grok 4 Fast 把这个倍数拉到了 2.5 倍——这并不常见,也很值得单拎出来讨论:它既可能反映了底层技术路径的变化,也可能传递出清晰的商业策略信号。

当前大模型的主流技术架构的输出是自回归生成,每产出 1 个 token,都要跑一遍完整前向计算,并依赖前文上下文;而输入多为一次性并行编码。结果是生成阶段的并行度更低、时延更高、算力利用更难做满。因此输出价格会贵很多。

Grok 4 Fast 把输出/输入倍数压到 ≈2.5,明显低于行业常态。这就有意思了。我们可以做两个层面的合理猜测(不代表官方结论):

技术猜测:把“每个输出 token 的隐性后台成本”降下来了

- 更高“智能密度”:通过强化学习与工具使用策略的优化,在保证质量的前提下减少无效思考与反复试探,让生成端少走弯路。均摊下来,每个输出 token 背后的平均算力与等待开销更低。

- 统一架构与系统优化:把“推理/非推理”合并到同一套权重,由系统提示“调档”,减少模式切换损耗;叠加高效注意力内核、KV 管理、混合精度/量化、投机解码等工程手段,进一步提升生成阶段的吞吐/功耗比。

- 缓存定价与负载塑形:单列缓存输入 $0.05/1M,鼓励复用长上下文,降低“无意义重复读写”的比例,从系统层面对输出阶段的资源占用进行“前置减压”。

商业猜测:用“低倍数”去重塑谁来用、用来做什么

- 主动拥抱生成密集型场景:报告、代码、搜索摘要、客服对话等高输出占比任务,更能从 2.5× 结构中获益——账单更可预期,迁移意愿更强。

- 规模经济闭环:结构性低倍数有助于提升总体调用量与资源利用率,规模上来后单位成本再下降,形成“低倍数—高使用—更高效率—可持续低价”的正循环。

- 差异化定位:在多数竞品仍维持 5–10× 的背景下,2.5× 本身就是产品信号:我们让生成更亲民,并且工程上跑得动。

当然,并不是所有这些策略都是单位输出token成本的降低,可能是综合原因。

如何使用 Grok 4 Fast:免费开放

Grok 4 Fast 已经面向所有用户全面开放。

-

普通用户:

- 可直接在 grok.com、iOS App、Android App 上体验。

- 在 Fast 模式和 Auto 模式下,搜索与问答性能显著提升。

- 与以往不同,这一次 免费用户也能使用最新模型,此前Grok 4最早普通用户不能使用,后来是每12个小时5次。

此外,OpenRouter上线了免费的接口服务,可以直接访问:https://openrouter.ai/x-ai/grok-4-fast:free 获取。不过,这个接口达到速度似乎只有150 tokens/s。

关于Grok 4 Fast更多的信息以及详细的评测结果参考:https://www.datalearner.com/ai-models/pretrained-models/Grok-4-Fast

Grok 4 Fast和其它模型的对比可以参考DataLearnerAI大模型对比工具:https://www.datalearner.com/compare/result?modelInputString=677,611,626,578&benchmarkInputString=&mode=thinking-only