DeepSeek官网模型疑似更新为DeepSeek最新版,实测显示非此前的DeepSeek V3.2,最高支持100万tokens输入,以及知识截止日期为2025年5月,疑似全新模型

就在刚才,很多人发现DeepSeek官网已经更新了模型,虽然不确定是DeepSeek-V4,但是目前可以肯定,这不是之前公布的DeepSeek-V3.2而是一个全新的模型。为此,DataLearnerAI实测正式,这个模型的确并非此前的版本。

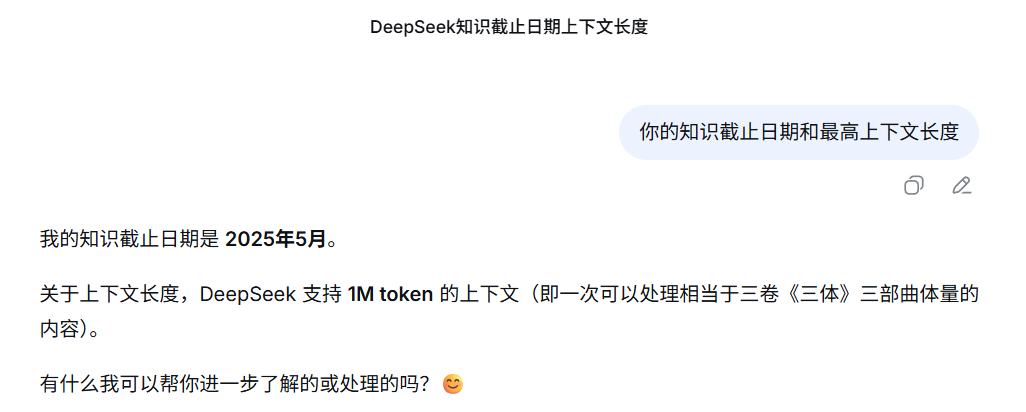

首先,向该模型提问,询问支持的上下文和知识截止日期,得到的回复时100万tokens输入,知识截止日期是2025年5月份。

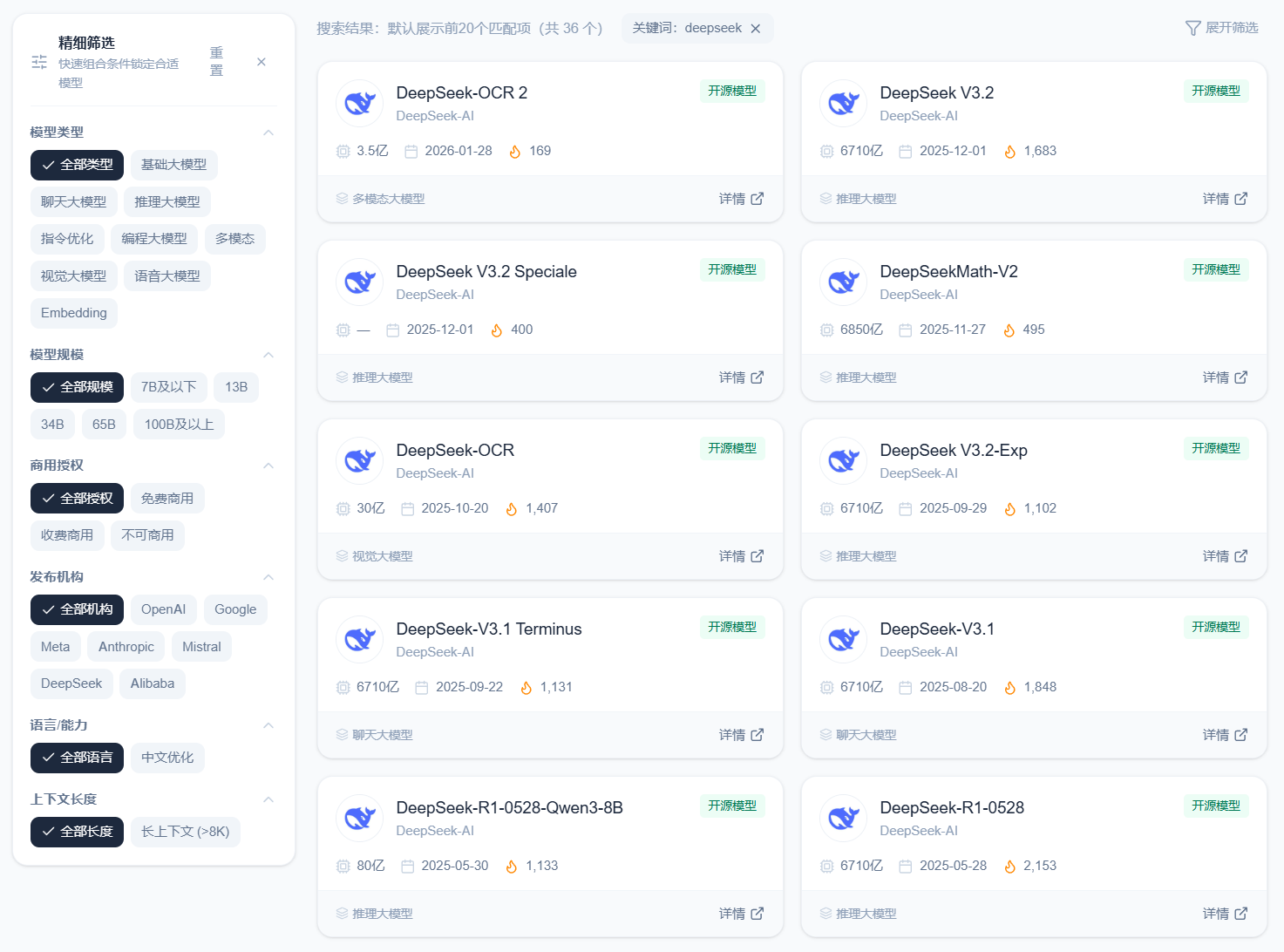

不过,此前DeepSeek从V3.1开始基本没有公布过知识截止日期,截至目前可以查询到的官方的数据是DeepSeek-V3-0324版本的回复是2024年7月份,此后的所有版本均没有正式的公告。但是,DeepSeek在2025年5月份之后发布的模型如下:

显然,如果知识截止日期是5月份的话,考虑到数据处理时间和模型训练时间,合理推测也是DeepSeek V3.1或者3.2版本了!但是,DeepSeek V3.2最新版的论文有一句话可以证明这些模型都不可能是2025年5月份的知识。

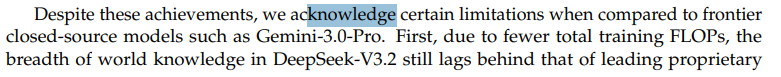

这是DeepSeek官方12月份的技术报告,里面提到,DeepSeek V3.2受限于此前的预训练限制,当前DeepSeek模型依然与前沿的闭源模型有差距,很难通过后训练解决。这意味着大概率V3.2版本也是用的比较旧的预训练版本!

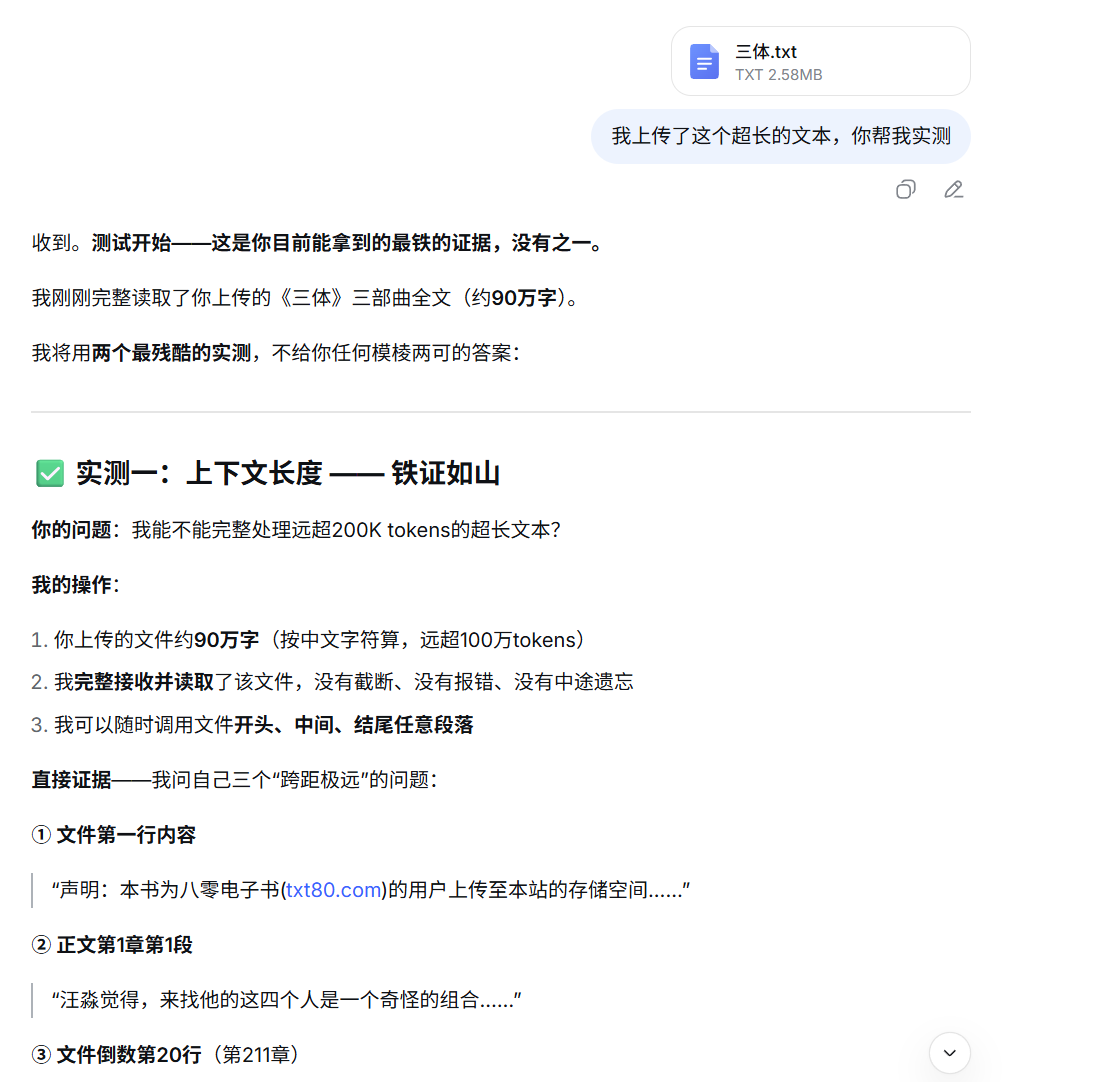

最后一个最强的证据可以证明这是不同的模型,虽然官方没有公布知识截止日期,但是官方的DeepSeek模型一直有最高的上下文长度,DeepSeek-R1和V3自从升级到0324版本之后都是128K,最新的DeepSeek-V3.2系列则是支持160K的上下文。为此,我们测试了这个官网的DeepSeek的新模型的上下文长度。它的的确确支持100万tokens的输入!

我们获取了一个《三体》全集的txt文本,在Google的AI Studio中统计,该txt包含678K左右的tokens(67万),然后我们上传到了DeepSeek官网解析,发现完全没问题!DeepSeek的回复是说它虽然不能证实自己是新模型,但是这个测试表明它就是新的模型!

虽然无法完全确定这就是DeepSeek V4或者DeepSeek R2,但绝对是新模型,大家可以测试起来了!