DeepSeekAI开源第二代数学理论证明大模型DeepSeek-Prover-V2:让AI帮助数学家证明数学理论!

就在刚才,DeepSeek-AI发布了其新一代自动定理证明模型 DeepSeek-Prover-V2。尽管官方暂未公开详细报告,但从其前代模型 DeepSeek-Prover-V1.5 的技术细节,以及去年底发布的通用推理模型 DeepSeek-R1 的进展来看,V2 很可能在多个关键能力上取得了实质性提升。

加载中...

就在刚才,DeepSeek-AI发布了其新一代自动定理证明模型 DeepSeek-Prover-V2。尽管官方暂未公开详细报告,但从其前代模型 DeepSeek-Prover-V1.5 的技术细节,以及去年底发布的通用推理模型 DeepSeek-R1 的进展来看,V2 很可能在多个关键能力上取得了实质性提升。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

很多人听说过语言大模型能写诗、编故事、写代码,但 DeepSeek-Prover 的目标更为严谨——它专注于解决数学中的形式化证明任务。

这类任务与普通语言生成不同,不仅要“看起来对”,还要在严密的数学逻辑下通过验证系统(如 Lean 编译器)检验每一步是否正确。哪怕一个小错误,整个证明也会失败。

这正是“自动定理证明(Automated Theorem Proving, ATP)”的核心目标:让 AI 在形式化系统中,像人类数学家那样严谨地进行推理、验证和构造证明。

虽然听起来非常学术化,但这类技术在现实中有着非常广泛的潜力应用:

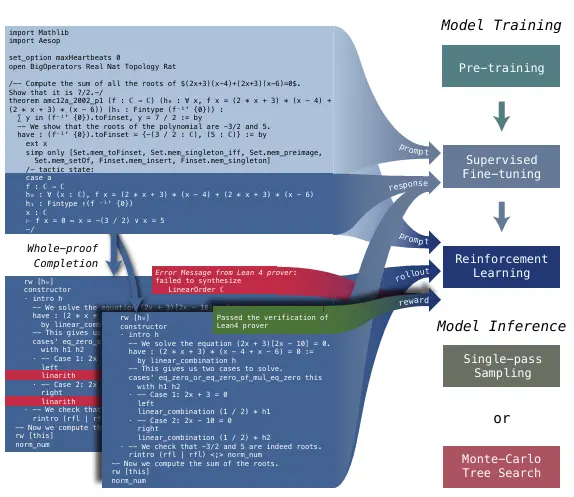

在 2024 年发布的 DeepSeek-Prover-V1.5 论文 中,DeepSeek 提出了一个完整的模型训练与搜索框架,将语言模型、数学证明系统和强化学习深度融合,主要包括以下三步:

模型首先在大量数学和代码语料(如 Lean、Isabelle 等形式语言)上进行预训练,建立对数学表达与逻辑结构的基本理解。

在微调阶段,DeepSeek 构建了一套增强数据,其中每个证明步骤前都带有“自然语言思路注释”,类似人类写作前的思考过程(Chain-of-Thought)。模型不仅要生成正确代码,还要写出清晰的推理过程。

此外,DeepSeek 还加入了来自编译器(Lean 4)提供的“中间状态信息”作为训练信号,帮助模型更精确地理解每一步是否合理。

最后,模型通过一种叫 RLPAF(Reinforcement Learning from Proof Assistant Feedback)的策略,持续从验证器那里获得反馈。如果生成的证明能通过检查,就给予正反馈,反之则惩罚。这一步进一步强化了模型生成可验证内容的能力。

V1.5 引入的另一项关键技术是 RMaxTS(RMax Tree Search),一种“探索驱动”的证明搜索算法。

它的工作方式是这样的:

这类似于人类“试一试 -> 出错 -> 回退 -> 改写”的思维过程。而且为了避免“反复走老路”,RMaxTS 还会给新路径提供“奖励”,鼓励探索不同思路。是不是很像当前DeepSeek R1推理大模型的思考过程?

在两个权威基准上,这种方法取得了显著成果:

虽然 DeepSeek-Prover-V2 的细节尚未公布,但结合 DeepSeek-R1 模型的能力,我们可以合理推测 V2 可能具备以下升级:

这些推测并非凭空想象,而是从 DeepSeek 在过去一年里模型体系的进化路径中,结合行业发展趋势而来的合理延伸。

此外,从发布时间看,也许正好是DeepSeek-Prover-V1.5的训练过程让DeepSeek发现了DeepSeek-R1这种推理大模型的训练秘诀呢?毕竟RMaxTS和当前所说的那种推理能力训练的强化学习似乎非常相似!

DeepSeek-Prover-V2 的发布意味着 AI 自动定理证明领域正持续快速前进。虽然我们还在等待官方更详细的报告和性能数据,但可以预见,该模型极有可能在形式化推理这一长期被认为“人类独有”的智能任务中,再次刷新行业对 AI 能力边界的认知。

我们也期待 DeepSeek 是否会继续保持开源传统,推动这一领域进一步走向普惠与标准化应用。

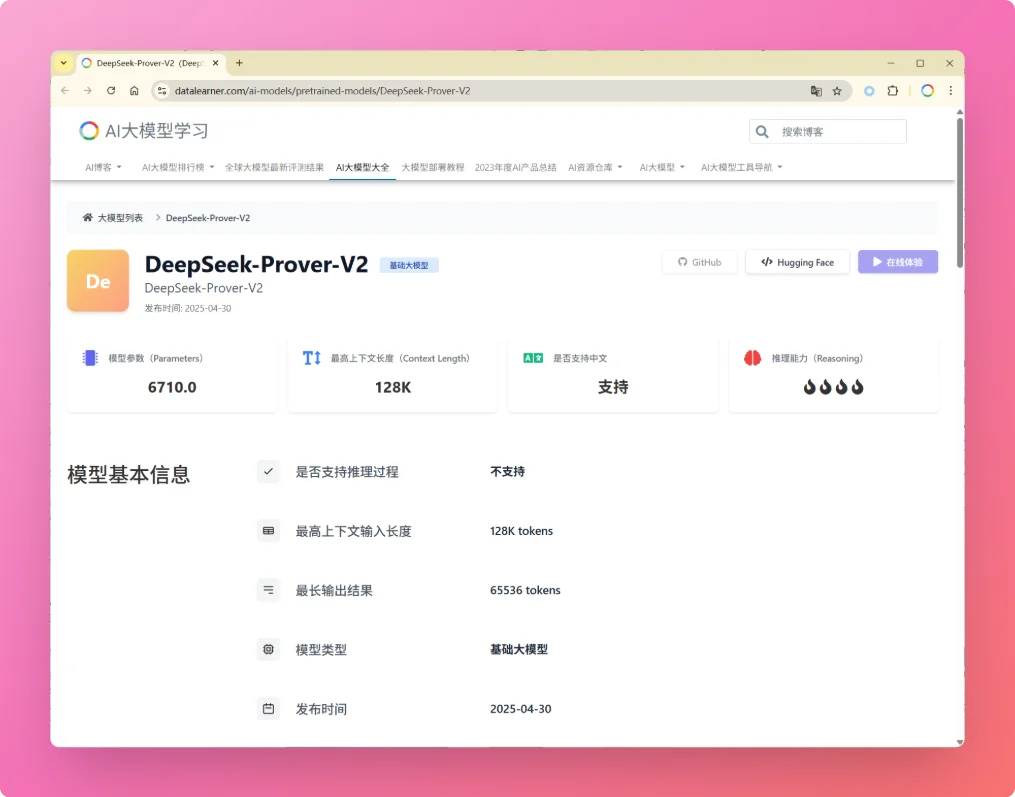

关于DeepSeek-Prover-V2大模型更多信息和开源地址参考DataLearnerAI模型信息卡地址:https://www.datalearner.com/ai-models/pretrained-models/DeepSeek-Prover-V2