DeepSeek AI团队重磅推出DeepSeek-OCR,该模型不仅在文档提取上达到了行业领先水平,更通过创新的视觉压缩技术,将长上下文处理效率提升了 10 倍以上。根据测算,在A100-40G的一个GPU上,它每天可以将20万页的文档图像数据转为Markdown文本!

DeepSeek-OCR 的最大价值在于,它将传统 OCR 的局限性转化为 LLM 训练的加速器:在高分辨率图像上实现近无损压缩,让模型在有限计算资源下处理更多信息。其核心特点是“Contexts Optical Compression”(上下文光学压缩),通过 2D 映射将文本密集文档浓缩为少量视觉令牌,显著降低了令牌消耗,同时保持高精度输出。这为构建更智能的文档理解系统铺平了道路,尤其在数据稀缺的时代。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

DeepSeek-OCR模型的基本信息

DeepSeek-OCR 采用 MoE 架构,总参数约 30 亿,但每次推理只激活约 5.7 亿参数,以极低的活跃计算量换来高吞吐与低延迟。它原生支持 512×512、640×640、1024×1024、1280×1280 等多档输入分辨率,覆盖从手机截图到高清扫描的主流场景。

DeepSeek-OCR训练集中涵盖英、中文、法文等多语言文档,样本量超过 500 万页,并以 95% 以上置信区间进行验证。模型从“识别”升级到“理解”,不仅抽取文本,还保留表格嵌套、图表关联和段落层级等布局语义,在等效信息承载上相当于把 32K 窗口扩展到更高容量;

DeepSeek-ORC以MIT许可开源,也就是完美免费商用授权,按照参数估计,6G 显存即可运行(暂不支持纯 CPU),多语言覆盖 10+ 种,方言如粤语可能需要再做微调。

DeepSeeK为什么要推出DeepSeek-OCR:从数据饥渴到视觉压缩的 OCR 进化

DeepSeek AI 自 2023 年以来,以高效的开源模型闻名,如 DeepSeek-V2 和 VL2,这些作品在视觉-语言任务上已展现出强劲实力。但随着互联网高质文本数据的枯竭,AI 训练面临瓶颈:海量书籍、报告和学术论文仍停留在纸质或扫描图像形式,无法直接喂养 LLM。DeepSeek-OCR 正是为此而生,它不是简单的文本提取工具,而是针对“数据数字化鸿沟”推出的战略性模型。通过 OCR 作为切入点,团队探索了将图像作为压缩媒介的潜力,帮助模型从结构化但非数字化的资源中提取营养。

相比前代如 DeepSeek-VL2,后者虽支持多模态输入,但令牌效率低下:在处理一页 A4 文档时,可能消耗 256 个以上视觉令牌,导致上下文窗口迅速饱和,甚至在单页上就超出 32K 限制。

DeepSeek-OCR 则直击痛点,通过光学压缩机制,将输入分辨率从 1280x1280 像素浓缩至仅 100 个tokens以内,解决了高分辨率图像的计算瓶颈。新技术借鉴了 2D 映射原理(类似于将三维文本投影到平面图像),避免了传统 OCR 的线性扫描误差,尤其在弯曲文本或手写笔记上表现突出。

这种升级的深层逻辑在于,OCR 已从“识别”转向“理解”。DeepSeek 团队在论文中强调,通过视觉压缩,不仅提取文本,还保留布局语义,如表格嵌套和图表关联。这为下游 LLM 提供了更丰富的上下文,潜在地将 32K 窗口扩展至 320K 等效容量。

DeepSeek-OCR的特点:不止提取文本,还可以提取公式、文档布局,转为Markdonw格式,成本下降10倍!

DeepSeek-OCR 的独特之处在于,它将 OCR 定位为“视觉压缩引擎”,而非孤立的文本工具。它主要包含三个特点:1)、解析数理化公式为Markdown格式、2)理解原文的布局,转为适合Markdown格式的布局;3)、极致的压缩能力,原来需要几千个tokens上下文才能达到的精度,目前只需要几十个!

1)、DeepSeek-ORC擅长解析STEM领域的公式

DeepSeek-OCR一个很重要的能力是对数理化领域公式的识别很强。这意味着,用户上传一张扫描页,不仅得到纯文本,还能获得结构化的 Markdown 输出,包括标题、段落和公式渲染。核心能力之一是高精度 STEM 解析:模型能识别数学符号(如积分 ∫ 或矩阵),并以 LaTeX 格式输出,准确率高达 95%。

为什么识别理工科的文本很重要?在教育和科研场景中,这避免了手动转录的繁琐,让 AI 直接“阅读”论文图表。例如,一张化学分子结构图,传统 OCR 可能仅提取 70% 键合信息,而 DeepSeek-OCR 通过语义增强,捕捉 92% 的立体构型细节。

而且理工科文本通常有更好的逻辑和质量,对于提升模型的智能方面很重要。

2)、DeepSeek-OCR擅长将图像转为Markdown的表示

DeepSeek-OCR另一个亮点是多模态布局理解。不同于简单逐行扫描,它采用全局注意力机制,模拟人类阅读路径:先定位块级元素(如图像块),再细化文本边界。这在复杂布局如报纸或报告中至关重要——测试样本显示,在 1000 页混合文档上,布局保留率达 98%,远超基线模型的 85%。

举个例子,上传一份包含流程图的业务报告,模型会自动生成带锚点的 Markdown文本,便于后续 LLM 推理。而不仅仅是一个图像文本提取工具。

3)、DeepSeek-OCR可以让tokens消耗下降10倍!

此外,DeepSeek-OCR最大的“杀手锏”是其压缩功能。

把需要喂给解码器的“条件长度”(上下文 token)压成原来的 1/10。在 DeepSeek-OCR 里,这通常体现在——同一页文档,用几十几百个视觉 token就能承载原来几百几千个 token的关键信息。

简单来说,多模态大语言模型识别图像的机制是处理每一页的图像的时候,我们通常先把图像转为tokens,然后基于tokens再输出完整的文本结果。这里的tokens通常代表了高度压缩的信息。越多通常模型输出质量越高,但是也会越慢,资源消耗也越大!

而这里说的压缩能力就是指DeepSeek-OCR模型将中间tokens压缩了10倍以上,但是准确性依然很高。进而导致了这个模型“小而美”!

当然,这些特性并非孤立,而是协同工作:从输入预处理到输出后置信评分,整个 pipeline 端到端延迟仅 50ms/页(A100 上)。对于普通用户,这意味着上传手机拍的笔记,即可获结构化摘要;对企业,则是自动化档案数字化的利器。

DeepSeek-OCR 评测结果:表现惊艳!

在多项权威测试中,DeepSeek-OCR 展现出压倒性的性能优势。

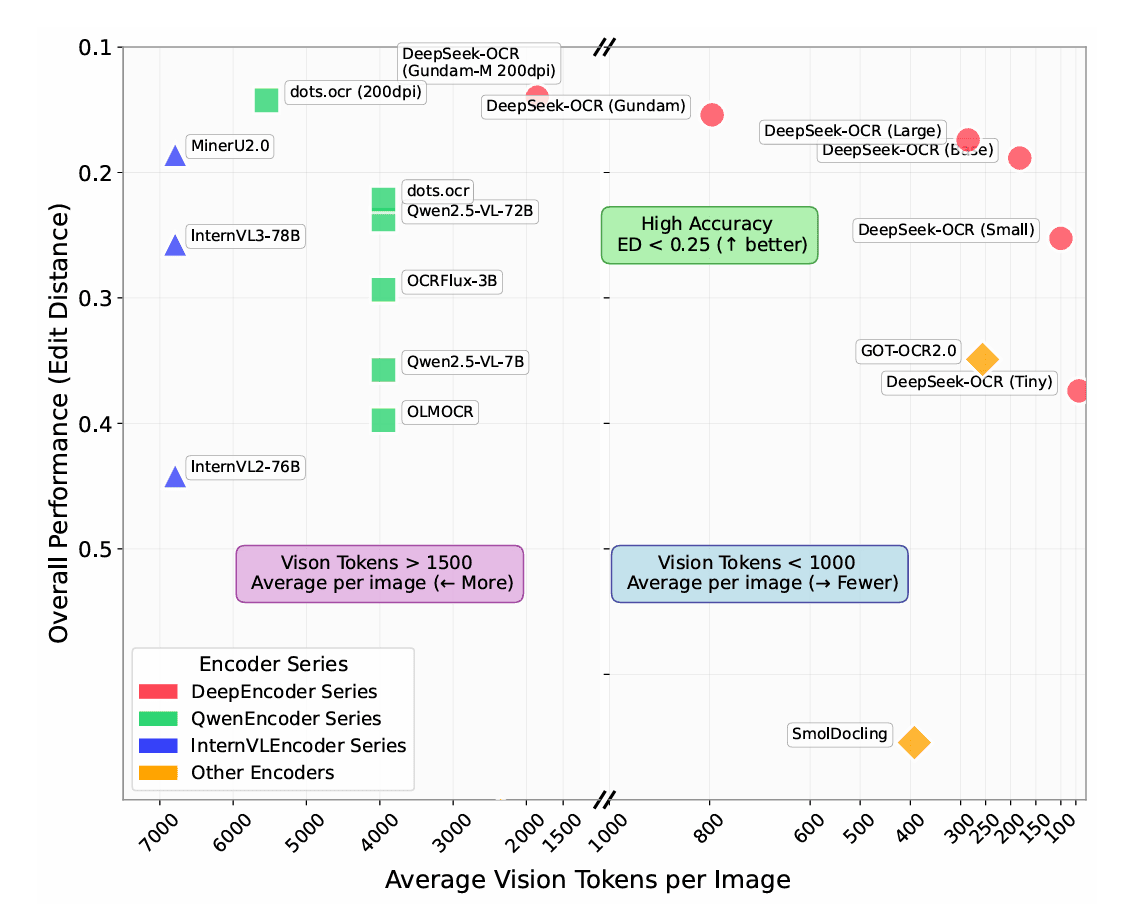

在最新的 OmniDocBench(CVPR 2025) 测试中(这一基准聚焦“文档解析多任务一体化评测”,覆盖学术论文、教材、幻灯片等 9 类复杂文档,评测维度包括版面、表格、公式与跨页一致性,极具企业落地代表性,评测结果越小越好),DeepSeek-OCR 在不同压缩率下均表现出极高效率。

当将每页文档压缩为 64 个 tokens 进行识别时,其解析结果与原文差距仅 0.386,而 Qwen2.5-VL-7B 需要 3949 个 tokens 才能达到 0.316 的差距。

当 DeepSeek-OCR 提高到 100 个 tokens 时,差距进一步缩小至 0.221,已明显优于 Qwen2.5-VL-7B。

若放宽至最大 tokens(约 795 个 tokens),模型误差降至 0.127,超越当前最佳的 MinerU 2.0(0.133),而后者却消耗了 6790 个 tokens——效率差距惊人。

此外,将输入分辨率至 200 dpi 的插值实验中,DeepSeek-OCR 使用 1853 个 tokens 即达到 0.123 的差距,再次超越 Dots.OCR(0.125, 5545 tokens),证明其在高保真条件下同样具备卓越的解析效率。

DeepSeek-OCR总结:依然开源,非常小而美

总结来看,DeepSeek-OCR 的核心竞争力并非源于盲目的参数堆叠,而是依托数据驱动的结构优化与视觉压缩创新。

Google开源多模态大模型Gemma3n的正式版:重新定义端侧AI的多模态能力,10B(100亿)参数以下最强多模态大模型,一个月前的预览版正式转正