阿里开源全模态大模型Qwen2.5-Omni-7B:支持文本、语音、视频、图像任意模态输入,可以实时生成文本或者语音,文本理解能力接近GPT-4o-mini,开源且免费商用

Qwen2.5-Omni-7B是阿里巴巴发布的一款端到端全模态大模型,支持文本、图像、音频、视频(无音频轨)的多模态输入与实时生成能力,可同步输出文本与自然语音的流式响应。目前,该模型在HuggingFace以Apache2.0协议开源,可以免费商用授权。

Qwen2.5-Omni-7B模型特点

Qwen2.5-Omni-7B模型最大的特点是端到端统一架构的多模态大模型,支持实时的语音和视频交互。

也就是说,你可以通过语音或者视频直接和它对话,而Qwen2.5-Omni-7B模型也可以实时输出文本和语音(流式输出)。需要注意的是,尽管Qwen2.5-Omni-7B支持文本、视频、语音和图片作为输入,输出的模态则仅支持文本和语音(视频对话输出似乎也没有必要)。

此外,这个模型只有70亿参数规模(应该是70亿语言模型参数+6.75亿ViT以及音频部分),最高支持32K的输入和8K的输出,响应非常快。官方的演示显示时延非常小。

Qwen2.5-Omni-7B模型在原有的Qwen2.5-7B的语言模型上继续增加了1.2万亿多模态数据的训练,主要包括:

- 800B tokens(图像 & 视频相关)

- 300B tokens(音频相关)

- 100B tokens(音视频同步数据)

- 额外使用 纯文本数据 维持语言能力

Qwen2.5-Omni-7B模型架构

Qwen2.5-Omni-7B的核心设计目标,是解决多模态数据的统一理解与实时生成难题。为此,阿里团队提出了Thinker-Talker架构,通过模块化分工实现高效协同。

下图展示了这一架构:

可以看到,下方的Thinker模块作为“大脑”,负责多模态信息的语义理解。它集成了视觉编码器(ViT)和音频编码器(Qwen2-Audio),能够动态处理图像、视频和音频输入。例如,视频内容会通过动态帧率采样转化为时序序列,音频则被转换为128通道的梅尔频谱图,确保不同模态数据的高效融合。而Talker模块则专注于流式语音生成,直接利用Thinker的隐藏表示,通过因果式解码器和滑动窗口机制,实现低延迟的语音输出。这种分工不仅降低了模态干扰,还通过共享历史上下文提升了交互效率。

Qwen2.5-Omni-7B模型的评测效果

作为Qwen系列的最新成员,该模型通过创新的架构设计与训练策略,实现了跨模态信息的深度协同,并在多项基准测试中展现了领先性能。

Qwen2.5-Omni-7B在单模态的评测结果中与同等参数规模中只专注单一任务的模型相比也很不错。例如,在ASR方面,中文的CommonVoice-zh数据集测试的错字率只有5.2%,而视频理解方面Video-MME的评测是72.4,优于GPT-4o-mini。

任务表现结果如下:

其中,核心的文本理解方面,MMLU Pro的评测与Llama3.1-8B接近,超过了Qwen2.5 7B,但是低于Gemma2-9B和Qwen2.5-7B模型。

Qwen2.5-Omni-7B模型总结

尽管与当前最强的大语言模型相比,Qwen2.5-Omni-7B模型的理解和推理能力不是最好的,但是低延迟、多模态输入以及还不错的通识能力,也提供了很多有价值的场景,例如:

- 实时交互场景:如智能客服、在线教育,支持低延迟语音对话与视频分析。

- 复杂任务处理:视频OCR、跨模态推理(如“根据监控视频描述事件并生成报告”)。

- 个性化服务:通过多说话人微调,适配不同音色与情感风格,适用于虚拟助手、有声内容创作。

阿里团队计划进一步扩展模型的输出模态(如图像、音乐生成),并优化推理速度与鲁棒性。

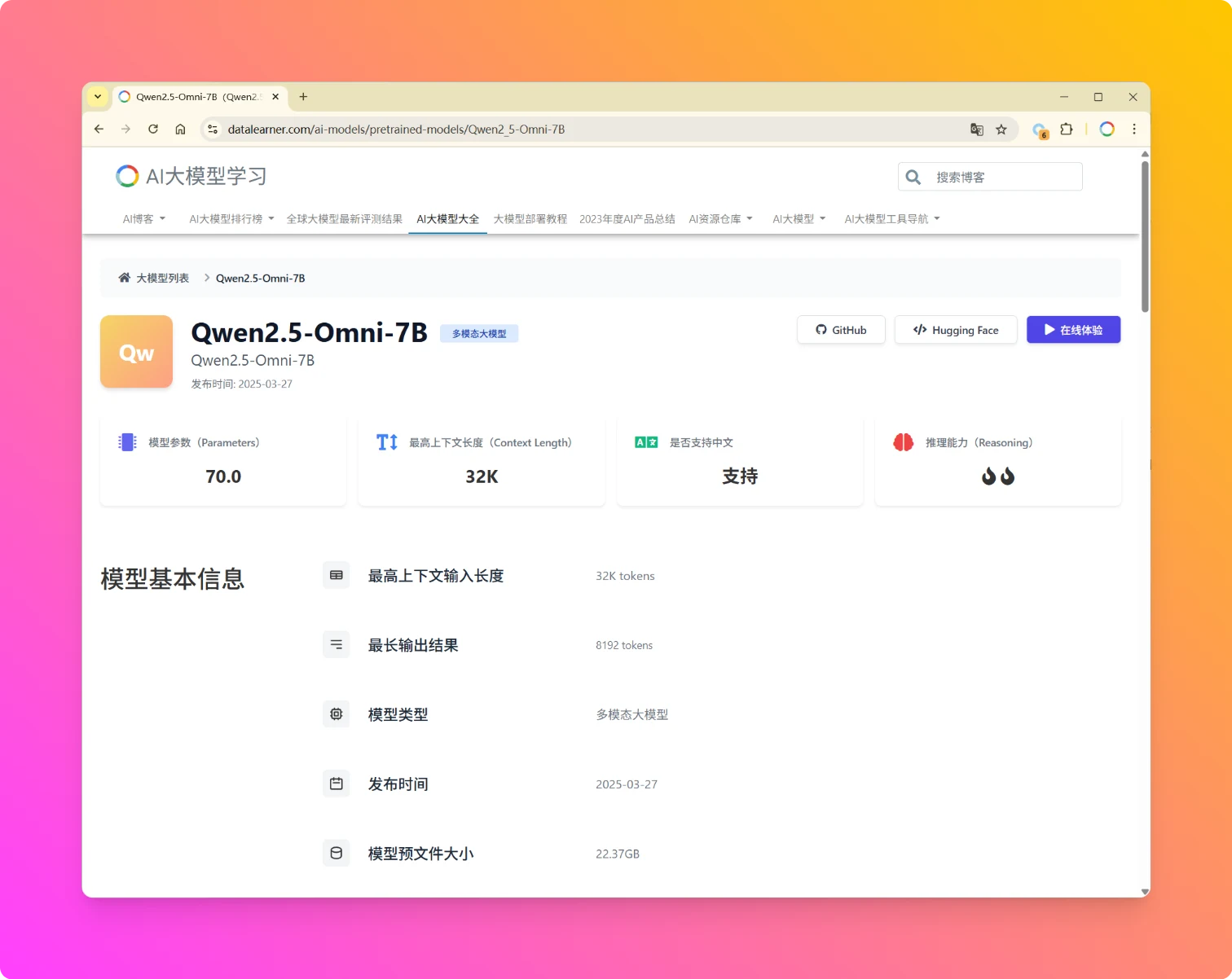

Qwen2.5-Omni-7B模型的开源地址和官方体验地址参考DataLearnerAI的模型信息卡:https://www.datalearner.com/ai-models/pretrained-models/Qwen2_5-Omni-7B