2023年11月第四周的HuggingFace流行的十大开源大模型分析——多模态大模型和小规模模型爆发

HuggingFace是当之无愧的大模型领域的开源社区最火的网站。基本上所有的重要的大模型开源都会选择在HuggingFace上发布自己的预训练结果。最近一周,HuggingFace上流行的十大模型非常有特点,多个最近发布的多模态模型霸榜,包括了Whisper V3、XTTS v2、Stable Video Diffusion等。这里给大家介绍一下。

加载中...

HuggingFace是当之无愧的大模型领域的开源社区最火的网站。基本上所有的重要的大模型开源都会选择在HuggingFace上发布自己的预训练结果。最近一周,HuggingFace上流行的十大模型非常有特点,多个最近发布的多模态模型霸榜,包括了Whisper V3、XTTS v2、Stable Video Diffusion等。这里给大家介绍一下。

欢迎关注 DataLearner 官方微信,获得最新 AI 技术推送

在本周,HuggingFace最流行的十个大模型多模态模型占了4个,包括StabilityAI最新开源的文本生成视频大模型Stable Video Diffusion、Coqui最新的语音合成大模型XTTS第二代等都吸引了大量的关注多。而大语言模型中,谷歌开源了2022年就已经发布的Switch大模型,该模型号称参数可以达到上万亿,也是十分有意思。下面我们分别介绍这几个模型。

SVD全称Stable Video Diffusion,是StabilityAI最新的开源文本生成视频大模型。这个模型是基于Stable Diffusion 2.1进行初始化,然后通过在图像模型中插入时空卷积和注意力层来构建这个视频生成模型的架构,最终在1.52亿视频数据集上训练得到。

下图是效果图:

SVD系列模型包含2个版本,一个是可以生成14帧576x1024图像的SVD常规模板,一个是可以生成20帧的SVD-XT的微调版本。二者除了生成视频的帧数不一样外,其它都是完全相同的。

二者的开源地址和详细信息参考DataLearner模型信息卡:

关乎这个模型的详细信息参考DataLearnerAI的介绍:可能比runway更好!StabilityAI最新开源文本生成视频大模型:Stable Video Diffusion,可以生成最多20帧的视频,但不可商用

SVD的两个版本分别占据了排行榜的第一名和第四名。

Orca是微软发布的一系列参数规模较小的大语言模型。为了证明小型模型也可以有很强的推理等能力,微软训练了Orca2。证明了即使是10亿参数级别以下的小型模型也能通过改进的训练信号和方法达到增强的推理能力。Orca 2的关键洞见在于,不同的任务可能会从不同的解决策略中受益,例如逐步处理、回忆后生成、回忆-推理-生成、提取-生成和直接回答。Orca 2通过一个扩展的、高度定制的合成数据集进行训练,这些数据教会了Orca 2各种推理技术,并教会它为不同任务选择不同的解决策略。

Orca2模型测试结果显示,即使是130亿参数规模的模型,经过上述策略微调之后也可以达到Llama2 700亿参数规模的水平,与ChatGPT 3.5比也有一定的竞争力。对比结果:

这里的MMLU评估的是文本理解能力,ARC评测LLM在复杂推理和解决问题方面能力,而BBH则是Big Bench for HuggingFace,可以在不同的任务上评估大模型的性能。可以看到Orac2在70亿、130亿参数规模上都可以达到700亿参数模型的水平,十分令人惊艳。

Whisper是OpenAI提出的一种用于自动语音识别(ASR)和语音翻译的预训练模型。该模型在680k小时的标记数据上进行训练,展现出在多个数据集和领域的强大泛化能力,无需进行微调。V3是最新发布的第三代模型。

Whisper large-v3模型在多种语言上的表现有所提升,与Whisper large-v2相比,错误率降低了10%到20%。研究表明,与许多现有的ASR系统相比,该模型在口音、背景噪音、专业术语的鲁棒性方面有所提高,同时在多种语言到英语的零样本翻译方面也显示出较好的性能;在语音识别和翻译的准确性上接近最先进水平。

V3版本的Whisper通过使用 Whisper large-v2 收集的 100 万小时弱标签音频和 400 万小时伪标签音频进行训练。

以下表格总结了Whisper的信息:

这个模型是Intel开源的一个聊天语言大模型。这个模型有2个值得注意的特点:一个是在Intel的硬件Gaudi2上进行微调的,另一个是使用了DPO技术。

随着ChatGPT的火爆,强化学习作为大模型训练的第三个阶段不仅可以让大模型与人类偏好对齐,还能有效提高模型的效果。而RLHF作为第三阶段的核心方法也包含许多路径。其中DPO(Direct Preference Optimization)是其中最重要的一种路径。DPO专注于从人类的偏好反馈中学习。它被设计用于那些难以定义清晰、可量化的奖励函数的场景,如自然语言生成等。DPO的核心在于使用人类的偏好作为指导,而不是传统的奖励信号。

但是,DPO的开源实现很少。Intel开源的Neural Chat在DPO方面做了非常详细的介绍和实现细节。Neural Chat是基于Mistral-7B模型微调得到,而其训练的结果是模型在各项评分中都有答复提升,在OpenLLMLeaderboard中的平均分有原始的MistraL-7b的50.32提升到了59.06,效果十分明显!

NeuralChat 7B的一个亮点是它采用了无偏好数据的直接偏好优化(DPO)技术。传统上,偏好数据的收集成本高昂且耗时,因此英特尔通过消除偏好数据的需求,实现了模型性能的提升。

Neural Chat信息参考:https://huggingface.co/Intel/neural-chat-7b-v3-1

语音合成是大模型领域另一个发展十分迅猛但是技术发展相对语言模型较慢的领域。Coqui此次开源的XTTS V2也是一个非常神秘的语音合成模型。

根据官方的介绍,这个模型支持17中语言,可以基于6秒的语音就能克隆模仿声音。甚至包括克隆来源声音的风格和情绪。然而,可惜的是XTTS V2并没有公布训练细节,而这个模型也不允许商用,你可以用来作为研究目的,而商用只允许用来测试。

该模型支持的语言列表:

官方有个在线演示,效果还是很可以的:https://huggingface.co/spaces/coqui/xtts

不过不支持商用的原因可能是他们在推自己的云服务,大家也可以商业采购~

Switch Transformers是谷歌在2022年1月份公布的模型,这个模型最高包含了1.6万亿参数,是目前已知的参数量最大的大语言模型。

模型的这种巨大规模主要得益于它的Mixture of Experts(MoE)架构。MoE允许模型在不同的“专家”网络之间分配任务,每个专家负责学习数据的不同方面。这种设计不仅提高了模型的处理能力,也大大增加了其参数量。此次开源的google/switch-c-2048包含了2048个专家,1.6万亿参数。而且开源的协议是Apache2.0,意味着可以商用。

不过官方公布的是这个开源模型有3.1TB,大概率没人玩得动,而且公布这么彻底估计也是因为这条路线可能不是很好~

OpenChat 3.5是由Alignment Lab AI团队开发的对话模型,它基于一种名为C-RLFT(Constant Reasoning Language Model Training)的技术。这种技术允许模型在对话中提供高质量的用户体验,并在推理基准测试中表现出色。

C-RLFT是OpenChat框架的核心技术,可以提升混合质量数据的开源语言模型。具体来说,它考虑了通用的SFT训练数据,正常来说都包含少量的专家数据和大量的次优数据,没有任何偏好标签。C(onditioned)-RLFT将不同的数据源视为粗粒度的奖励标签,并学习一个类条件策略,以利用补充的数据质量信息。有趣的是,C-RLFT中的最优策略可以通过单阶段、无RL的监督学习轻松解决,这种方法轻量级并避免了昂贵的人类偏好标注。

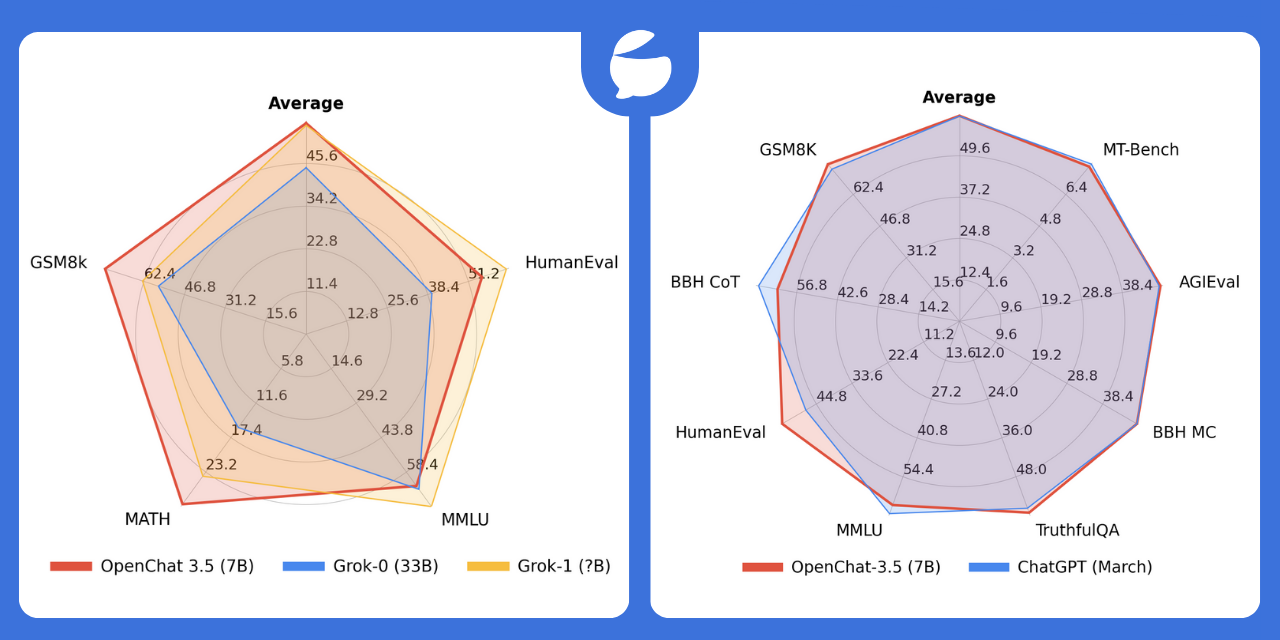

OpenChat 3.5与ChatGPT的评测对比:

尽管ChatGPT的具体参数没有公布,但是可以肯定的是远超过70亿。而OpenChat 3.5的测试结果让人惊讶!

OpenChat 3.5是apache 2.0开源协议,可以直接测试:https://huggingface.co/openchat/openchat_3.5

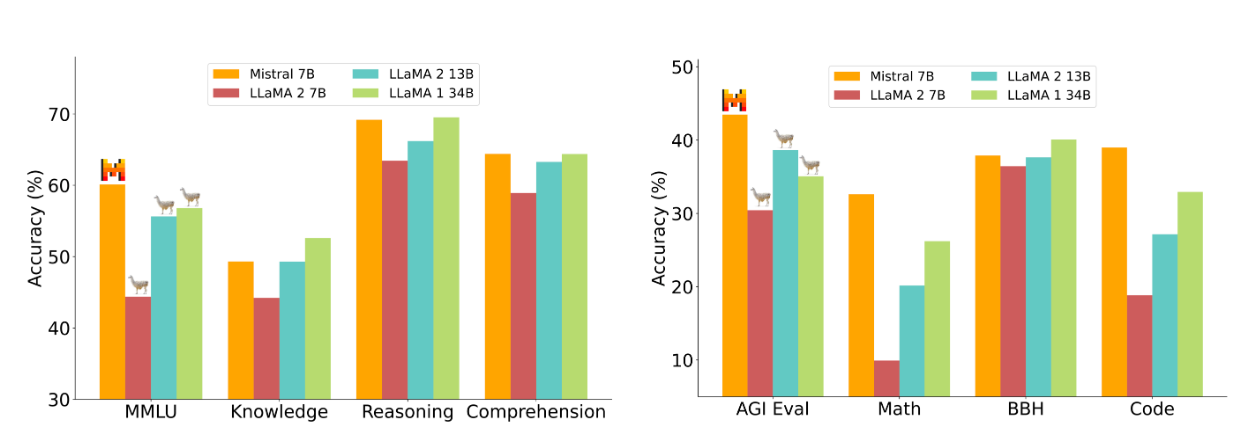

Mistral 7B是由法国人工智能初创公司Mistral AI发布的。这款模型以其73亿参数规模在多项基准测试中均优于Llama 2 13B模型,并在许多方面超过了Llama 1 34B模型。Mistral 7B因其强大的性能、较低的硬件需求、包含2023年的最新知识、更可靠的安全对齐以及更宽松的开源协议而受到广泛赞誉。

Mistral 7B的表现在各项评估中通常优于Llama 2 13B,尽管在知识基准测试中其表现与Llama 2 13B相当,这可能是由于其有限的参数数量限制了它能够压缩的知识量。它还在代码、数学和推理评测中超越了Llama 1 34B,同时在代码任务上的表现接近专门的CodeLlama 7B,同时保留了自然语言处理的能力。

Mistral 7B完全开源,Apache2.0协议,吸引了广泛关注。而Mistral AI也成立欧洲诸多大模型创业公司中最耀眼的一家,有可能让欧洲在大模型领域有一席之地。

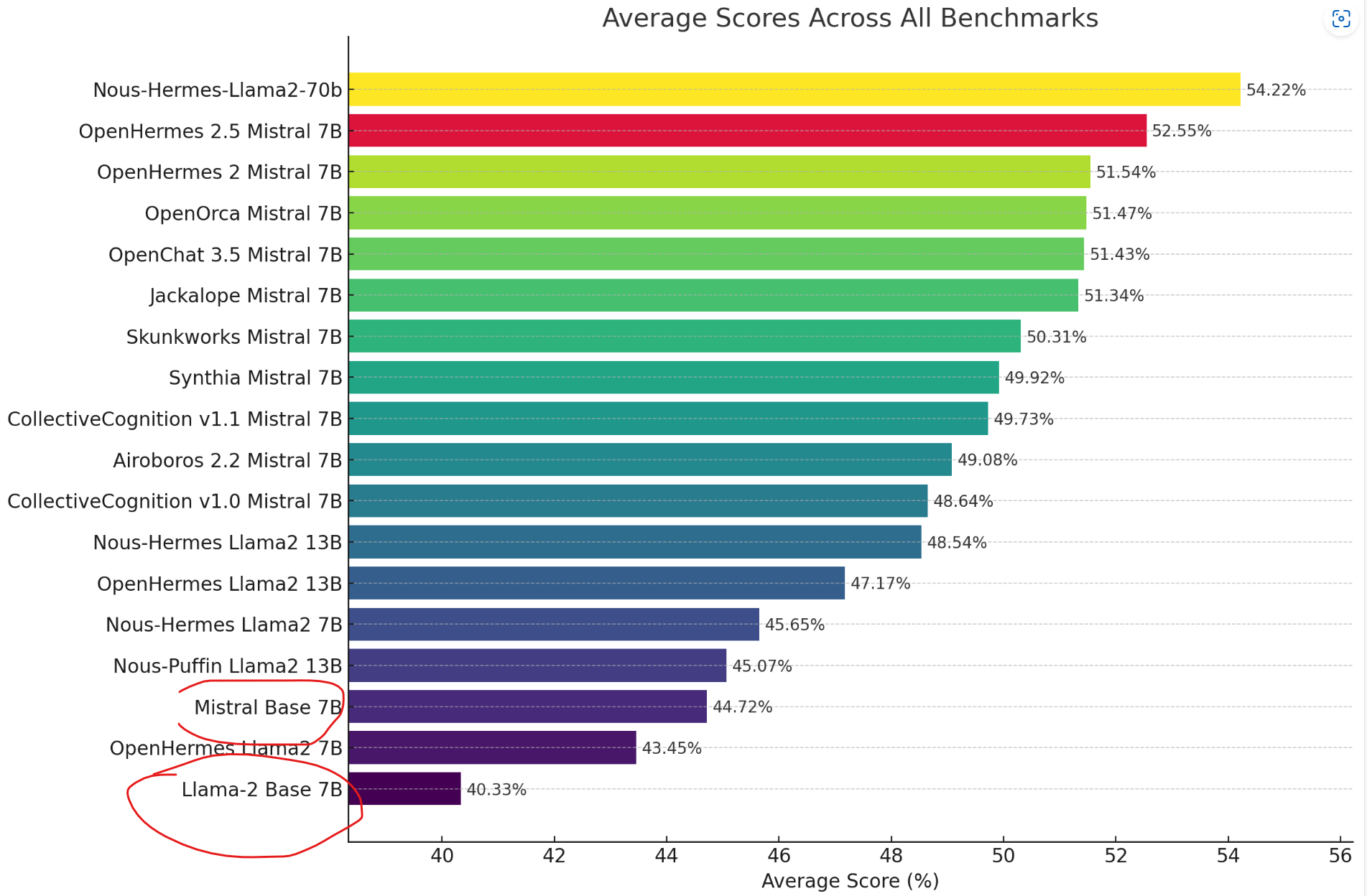

OpenHermes-2.5是由Teknium在Mistral-7B模型上微调的一个大模型。这位老兄此前在StabilityAI工作,后来创办了NousResearch公司。是个人开发者。

OpenHermes-2.5是基于Mistral-7B,采用Hermes 2数据集和10万条代码指令(GPT-4产生)微调得到。这个模型的实践有一个非常有意思的发现,在微调数据集上配比7-14%的代码指令可以大幅提高模型的效果。这个模型比前面提到的欧洲之光Mistral 7B效果也是大幅提升!

OpenHermes-2.5-Mistral-7B开源协议为apache2.0,自由使用:https://huggingface.co/teknium/OpenHermes-2.5-Mistral-7B

从前面描述的这十个流行模型我们也可以看到,大语言模型现在的发展是小型的使用特殊数据和方法优化的模型更加流行。而多模态领域则发展十分迅速。虽然有小部分模型开源协议不友好,但是开源生态很繁荣,发展十分迅速。大家应该持续关注。

| 44.68 |

| ChatGPT (GPT-3.5-Turbo) | 68.92 | 93.73 | 84.73 | 55.38 |

| 俄语 |

| Dutch | nl | 荷兰语 |

| Czech | cs | 捷克语 |

| Arabic | ar | 阿拉伯语 |

| Chinese | zh-cn | 中文 |

| Japanese | ja | 日语 |

| Hungarian | hu | 匈牙利语 |

| Korean | ko | 韩语 |

| Hindi | hi | 印地语 |

| 73.2 |

| 70.1 |

| 78.2 |