Hugging Face发布最新的深度学习模型评估库Evaluate!

2,390 阅读

就在儿童节前一天,Hugging Face发布了一个最新的深度学习模型评估库Evaluate。对于机器学习模型而言,评估是最重要的一个方面。但是Hugging Face认为当前模型评估方面非常分散且没有很好的文档。导致评估十分困难。因此,Hugging Face发布了这样一个Python的库,用以简化大家评估的步骤与时间。

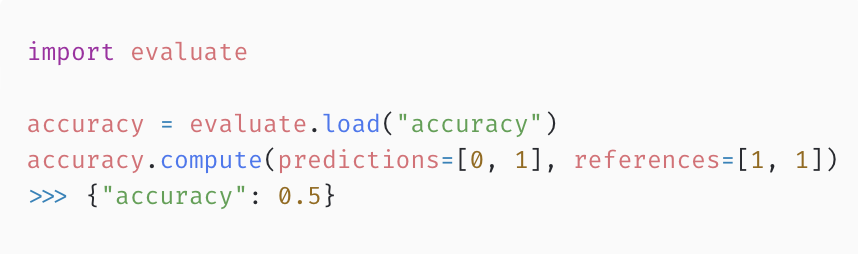

可以看一下这个代码示例,非常简单:

目前,Evaluate主要包括如下三个功能特点:

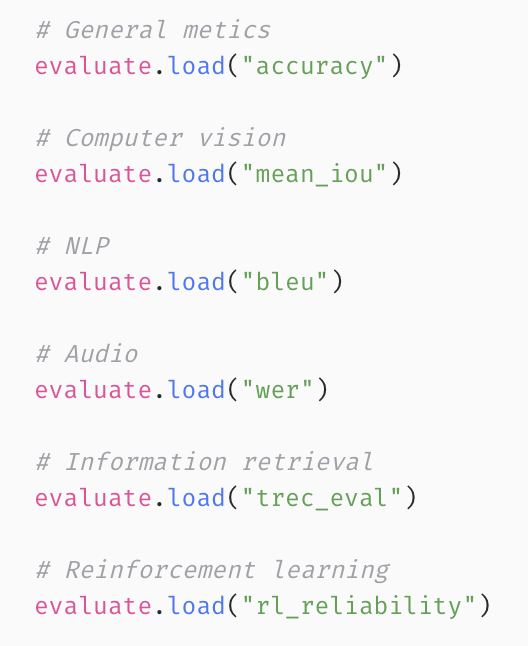

- 实现了几十个六性的评估metrics:从NLP到计算机视觉,甚至包括datasets的衡量标准。只需要载入相关的评估指标,就可以直接对任意模型结果进行评估,包括Numpy、Pandas、PyTorch、TensorFlow、JAX等。

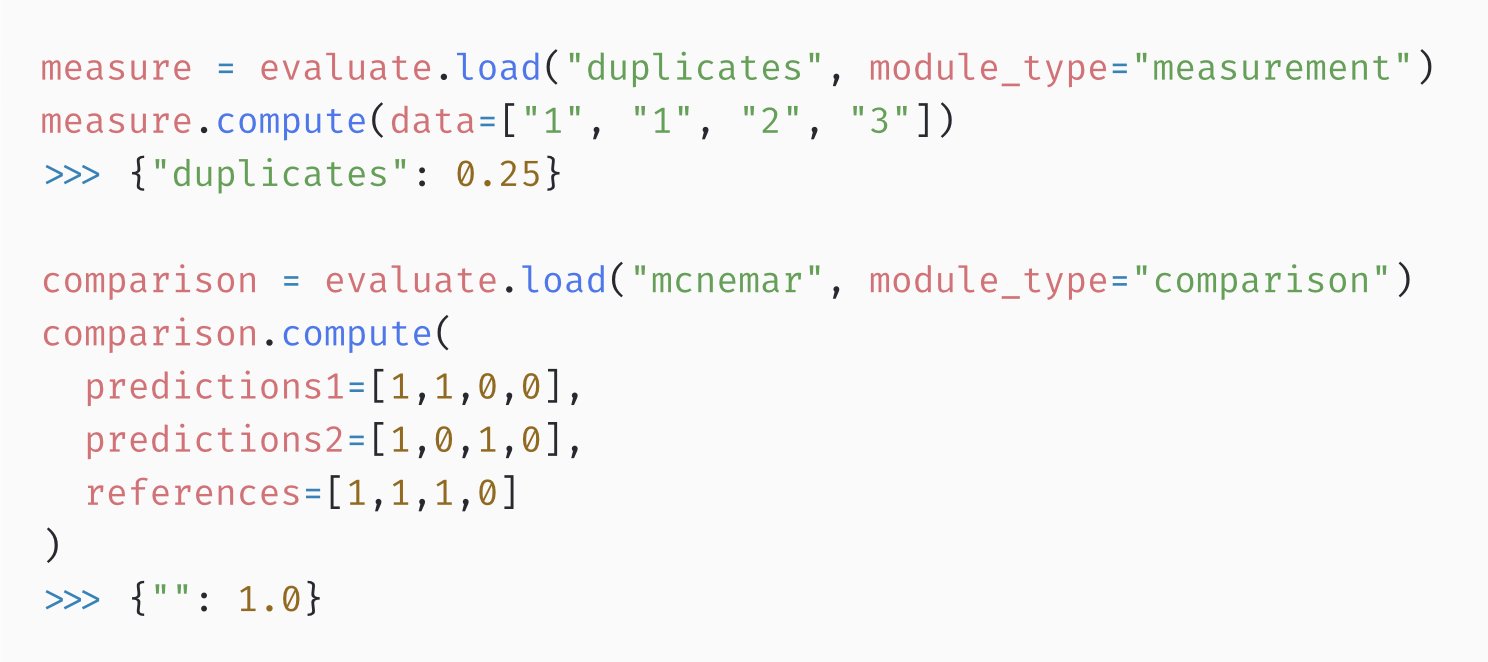

- 包含了比较与度量:大家经常会对比不同模型之间的结果,而这个工具也在这个方面也非常好用,不需要你自己额外的管理和编写代码去比较。