开源版本的GPT-3来临!Meta发布OPT大语言模型!

关注深度学习或者NLP的童鞋应该都知道openAI的GPT-3模型,这是一个非常厉害的模型,在很多任务上都取得了极其出色的成绩。然而,OpenAI的有限开放政策让这个模型的应用被限定在很窄的范围内。甚至由于大陆不在OpenAI的API开放国家,大家几乎都无法使用和体验。而五一假期期间,FaceBook的研究人员Susan Zhang等人发布了一个开源的大预言模型,其参数规模1750亿,与GPT-3几乎一样。

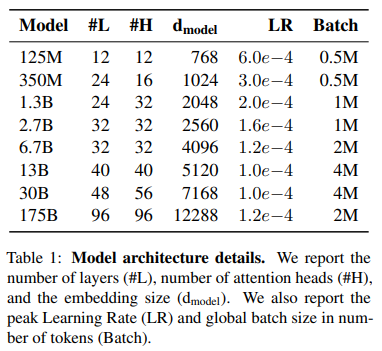

GPT-3的不开放使得很多研究人员无法对这个强大的模型进行进一步探索,而FaceBook这次开源的大模型表示其能力与GPT-3基本一致,并且向感兴趣的研究人员充分和负责地分享!该模型名称为OPT(Open Pre-trained Transformer Language Models),从名字上不仅与GPT-3差不多,但也突出了开放。目前开放的OPT版本包括如下几种:

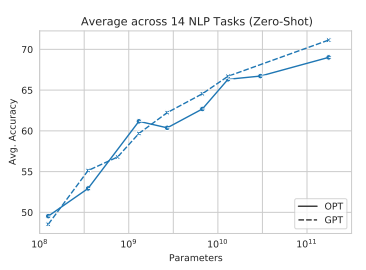

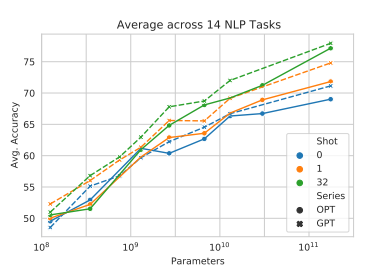

从与GPT-3在14个任务的对比情况来看,OPT几乎与GPT-3的水平一致(下图分布是zero-shot与multi-shot对比结果):