MistralAI开源240亿参数的多模态大模型Mistral-Small-3.1-24B:评测结果与GPT-4o-mini与Gemma 3 27B有来有回,开源且免费商用,支持24种语言

欧洲大模型之光MistralAI开源了2个全新的多模态大模型,即Mistral-Small-3.1-24B基座版本和指令微调版本。这两个大模型均以Apache2.0协议开源,因此可以完全免费商用。而官方也给出了这个模型在多个评测集上的效果,高于GPT-4o-mini和Gemma 3 27B。因为其参数规模较小,推理速度可以达到每秒150个tokens,同时支持多种语言,是一个非常值得关注的小而美的多模态大模型。

Mistral Small 3.1介绍

MistralAI是法国的一家大模型初创企业,MistralAI一直秉持着开源的精神,在推出各种自家大模型服务的同时也一直在开源不同的模型。2023年12月8日,该公司在其推特官方账号上公布了一个8×7B的Mixture of Experts模型的下载链接,几乎是当时最好的MoE的开源实现,引起了广泛的关注(参考此前DataLearnerAI关于Mistral 8*7B的介绍:https://www.datalearner.com/blog/1051702125462162 )。

本次发布的Mistral Small 3.1模型是其2025年1月底发布的Mistral Small 3基础上发展而来的更强的多模态模型。分为两个版本,即没有任何微调的预训练基座版本Mistral-Small-3.1-24B-Base-2503以及经过指令微调的Mistral-Small-3.1-24B-Instruct-2503,前者可以用于其它领域的微调,而后者则可以直接用来对话使用。

Mistral-Small-3.1-24B的关键技术信息

MistralAI以Apache2.0协议开源了Mistral-Small-3.1-24B模型。其主要的技术信息总结如下:

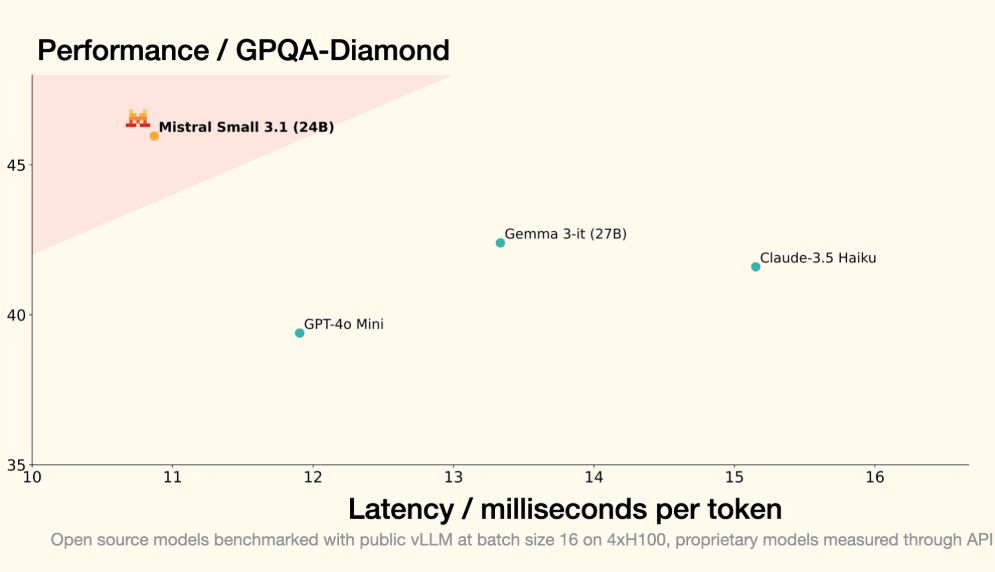

- Mistral-Small-3.1-24B的架构:构建为一个具有宽浅设计的 transformer 模型,与典型的 LLM 相比,层数较少但中间尺寸较大。这种结构在保持高性能的同时降低了延迟。

- Mistral-Small-3.1-24B的分词器:使用 Tekken 分词器,词汇量为 131k,增强了处理多样化语言输入的能力。

- Mistral-Small-3.1-24B的视觉能力:3.1 更新引入了最先进的视觉理解,允许模型分析图像并将视觉数据与文本响应集成。

- Mistral-Small-3.1-24B的部署:足够轻量,可以在单个 NVIDIA RTX 4090 GPU(在 bf16 或 fp16 中需要约 55 GB GPU RAM)或量化后在 32GB RAM 的 MacBook 上运行,使其可用于本地推理。

Mistral-Small-3.1-24B非常强大,支持文本和图像处理,能够执行视觉理解和基于图像的推理等任务,同时支持传统的基于文本的操作。240 亿参数规模,在能力和资源效率之间取得了平衡。Mistral-Small-3.1-24B的上下文长度最高支持128K,应该说是当前模型最主流的一类了。

此外,Mistral-Small-3.1-24B支持24种语言,包括英语、法语、德语、西班牙语、意大利语、中文、日语、韩语、葡萄牙语、荷兰语、波兰语等,适合欧洲人体质,当然中文也可以,这也是MistralAI家模型一直以来的优良传统(不像Llama系列,不知道是因为不服还是啥原因,始终不愿意用中文的语料,不愿意支持中文)。

Mistral-Small-3.1-24B评测结果

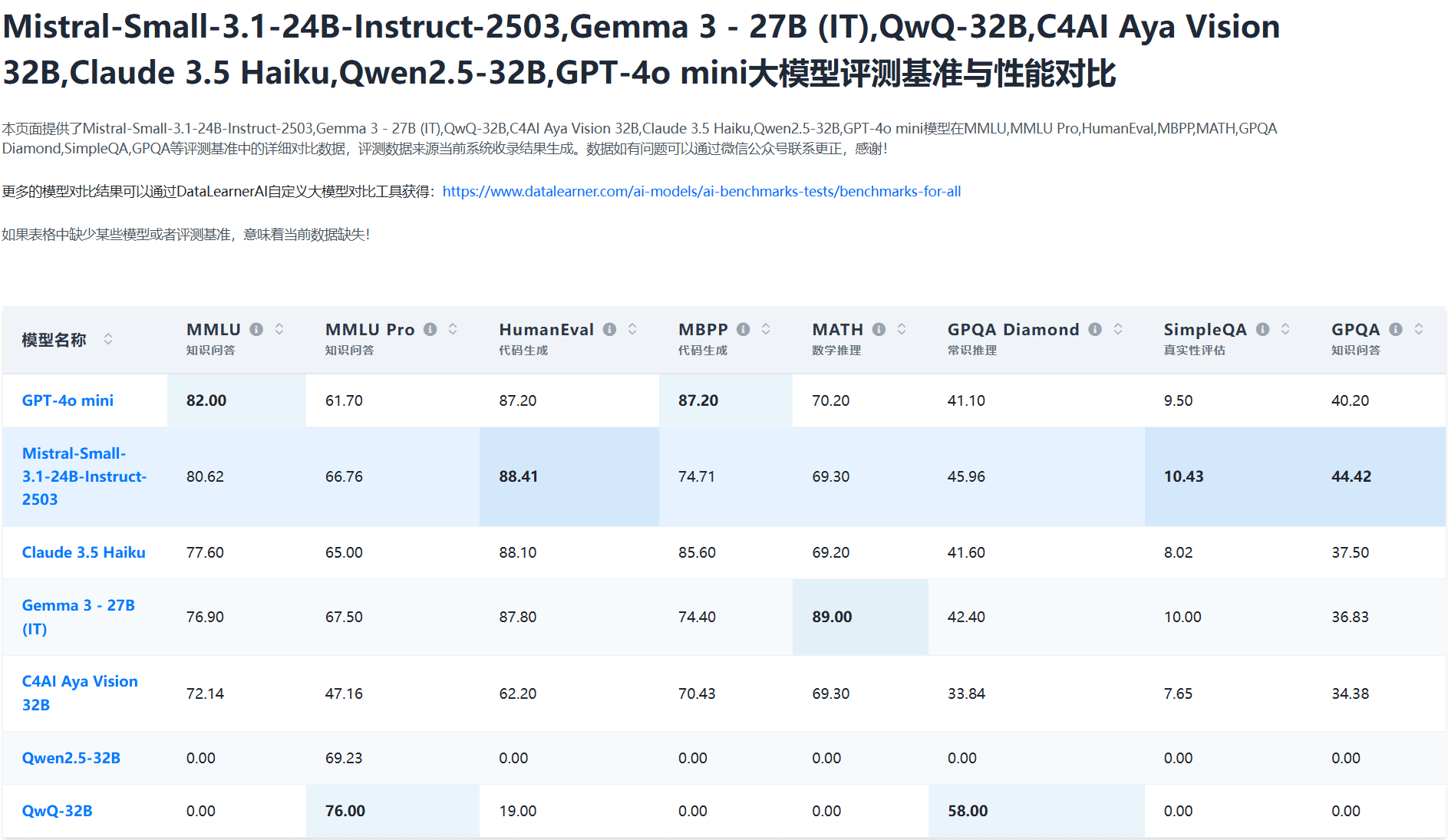

官方一个给出了Mistral-Small-3.1-24B与主流同等参数规模模型的对比结果,DataLearnerAI在此基础上增加了QwQ-32B以及Qwen2.5-32B的评测,如下图所示:

从以上对比可以看到,Mistral-Small-3.1-24B在多项主流评测中展现了较强的综合能力,尤其在代码生成和知识广度上表现亮眼,但在数学逻辑和复杂推理任务中稍逊于部分产品,但是考虑到这是完全开源且只有240亿参数的模型来说,非常够了。在上述8项测试中,Mistral-Small-3.1-24B有3项都是第一,剩余几个评测效果也不错(除了数学)。

在HumanEval测试(代码生成任务)中,Mistral-Small以88.41分位列所有模型之首,甚至小幅超越GPT-4o mini(87.20)和Claude 3.5 Haiku(88.10)。这表明其在理解代码需求、生成高效准确的代码片段方面表现卓越,非常适合开发者辅助工具或自动化编程场景。

但是在MATH测试(数学问题解决)中,Mistral-Small仅得69.30分,远低于Gemma 3的89.00分,甚至略逊于GPT-4o mini(70.20)。这表明模型对复杂数学逻辑和符号运算的处理能力较弱。

Mistral-Small-3.1-24B是一款以代码生成和知识广度见长的模型,尤其适合编程辅助与通用智能场景。若能补足数学逻辑与复杂推理的短板,其综合竞争力有望进一步提升,成为多领域应用的优选工具。

Mistral-Small-3.1-24B模型的开源地址和总结

Mistral Small 3.1 是一款在 Apache 2.0 许可证下发布的开源 AI 模型,它支持欧洲、东亚和中东等多种语言,在多语言任务中表现优异。

此外,大家需要注意,该模型提供低延迟函数调用和自动化工作流程支持,非常适合构建智能代理和虚拟助手。它还具备多模态理解和长上下文处理能力,应该是GPT-4o mini和Gemma3 27B之外的优秀选择。此外,MistralAI还提供了预训练基座版本的模型,适合大家自己用来在特定领域微调,这在最近的模型开源中也非常难得。

关于Mistral-Small-3.1-24B的开源HuggingFace地址以及其它信息请参考DataLearnerAI的模型信息卡。

Mistral-Small-3.1-24B-Base-2503(预训练基座版):https://www.datalearner.com/ai-models/pretrained-models/Mistral-Small-3_1-24B-Base-2503 Mistral-Small-3.1-24B-Instruct-2503(指令微调版本):https://www.datalearner.com/ai-models/pretrained-models/Mistral-Small-3_1-24B-Instruct-2503